我有一个带有MD raid的Debian服务器(2个活动,一个备用):

Personalities : [raid1]

md1 : active raid1 sdc2[0] sdb2[1] sda2[2](S)

1068224 blocks [2/2] [UU]

md0 : active raid1 sdc1[2](S) sdb1[1] sda1[0]

487315584 blocks [2/2] [UU]

bitmap: 5/233 pages [20KB],1024KB chunk

unused devices: <none>

每当我启动此服务器时,阵列都会降级并开始同步备用磁盘.问题是,它似乎是因为有一个USB磁盘连接到它,目前是/ dev / sdd.当此磁盘不存在时,它会正常启动. / dev / sdd1,唯一的分区,上面没有md超级块,分区类型是Linux,而不是raid自动检测.

这是md0的镜像设备细节:

mdadm --detail /dev/md0

/dev/md0:

Version : 0.90

Creation Time : Sun Jun 8 04:10:39 2008

Raid Level : raid1

Array Size : 487315584 (464.74 GiB 499.01 GB)

Used Dev Size : 487315584 (464.74 GiB 499.01 GB)

Raid Devices : 2

Total Devices : 3

Preferred Minor : 0

Persistence : Superblock is persistent

Intent Bitmap : Internal

Update Time : Tue Sep 15 09:23:33 2015

State : active

Active Devices : 2

Working Devices : 3

Failed Devices : 0

Spare Devices : 1

UUID : 9e408fbb:563a5459:f999b789:24d3b44e

Events : 0.83145

Number Major Minor RaidDevice State

0 8 1 0 active sync /dev/sda1

1 8 17 1 active sync /dev/sdb1

2 8 33 - spare /dev/sdc1

/ dev / sdc1的详细信息确实显示了它的备用:

mdadm --examine /dev/sdc1

/dev/sdc1:

Magic : a92b4efc

Version : 0.90.00

UUID : 9e408fbb:563a5459:f999b789:24d3b44e

Creation Time : Sun Jun 8 04:10:39 2008

Raid Level : raid1

Used Dev Size : 487315584 (464.74 GiB 499.01 GB)

Array Size : 487315584 (464.74 GiB 499.01 GB)

Raid Devices : 2

Total Devices : 3

Preferred Minor : 0

Update Time : Sat Sep 12 21:09:59 2015

State : clean

Internal Bitmap : present

Active Devices : 2

Working Devices : 3

Failed Devices : 0

Spare Devices : 1

Checksum : 7761bb13 - correct

Events : 83145

Number Major Minor RaidDevice State

this 2 8 33 2 spare /dev/sdc1

0 0 8 1 0 active sync /dev/sda1

1 1 8 17 1 active sync /dev/sdb1

2 2 8 33 2 spare /dev/sdc1

真的没什么特别的.

任何的想法?

编辑:

/etc/mdadm/mdadm.conf的相关内容:

ARRAY /dev/md0 level=raid1 num-devices=2 UUID=9e408fbb:563a5459:f999b789:24d3b44e spares=1 ARRAY /dev/md1 level=raid1 num-devices=2 UUID=e4578e57:9e0fd9e9:c7736f30:0e251564 spares=1

这种匹配mdadm的输出–detail –scan:

ARRAY /dev/md0 metadata=0.90 spares=1 UUID=9e408fbb:563a5459:f999b789:24d3b44e ARRAY /dev/md1 metadata=0.90 spares=1 UUID=e4578e57:9e0fd9e9:c7736f30:0e251564

它可能是新线吗?

>内核3.2.0-4-686-pae.

> Debian 7.8

> mdadm – v3.2.5 – 2012年5月18日

解决方法

我认为你的initramfs中可能有一个太旧的mdadm.conf和/或mdadm在数组的发现和初始化期间感到困惑.

尝试告诉mdadm只考虑PCI总线上的磁盘,在mdadm.conf中添加以下行:

DEVICE /dev/disk/by-path/pci*

更进一步,您可以直接指定磁盘本身.确保使用与订单无关的寻址(例如,通过UUID),并将备用放在最后一个条目中:

DEVICE /dev/disk/by-uuid/<uuid1> DEVICE /dev/disk/by-uuid/<uuid2> DEVICE /dev/disk/by-uuid/<uuid3>

更进一步,在上一步之后,您还可以将devices = attributes添加到ARRAY标记,将raid的确切布局提供给mdadm.此处也考虑设备的顺序.

在此之后不要忘记更新initramfs,因为mdadm.conf也是启动初始化过程的一部分:

sudo update-initramfs -k all -u

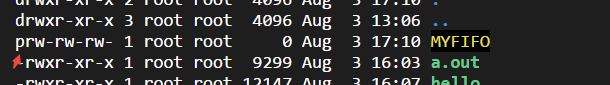

linux常用进程通信方式包括管道(pipe)、有名管道(FIFO)、...

linux常用进程通信方式包括管道(pipe)、有名管道(FIFO)、... Linux性能观测工具按类别可分为系统级别和进程级别,系统级别...

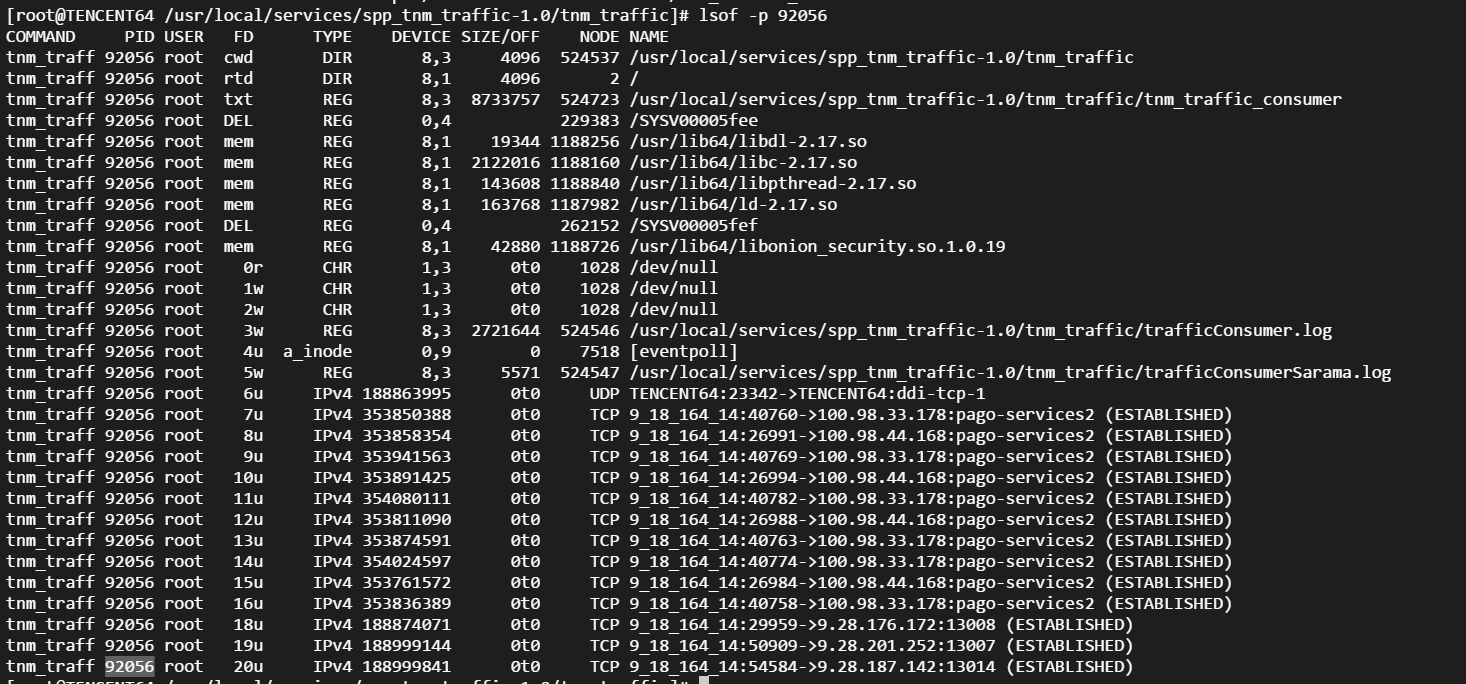

Linux性能观测工具按类别可分为系统级别和进程级别,系统级别... 本文包含作者工作中常用到的一些命令,用于诊断网络、磁盘占满...

本文包含作者工作中常用到的一些命令,用于诊断网络、磁盘占满... linux的平均负载表示运行态和就绪态及不可中断状态(正在io)的...

linux的平均负载表示运行态和就绪态及不可中断状态(正在io)的... CPU上下文频繁切换会导致系统性能下降,切换分为进程切换、线...

CPU上下文频繁切换会导致系统性能下降,切换分为进程切换、线...