一、Linux系统状态概述

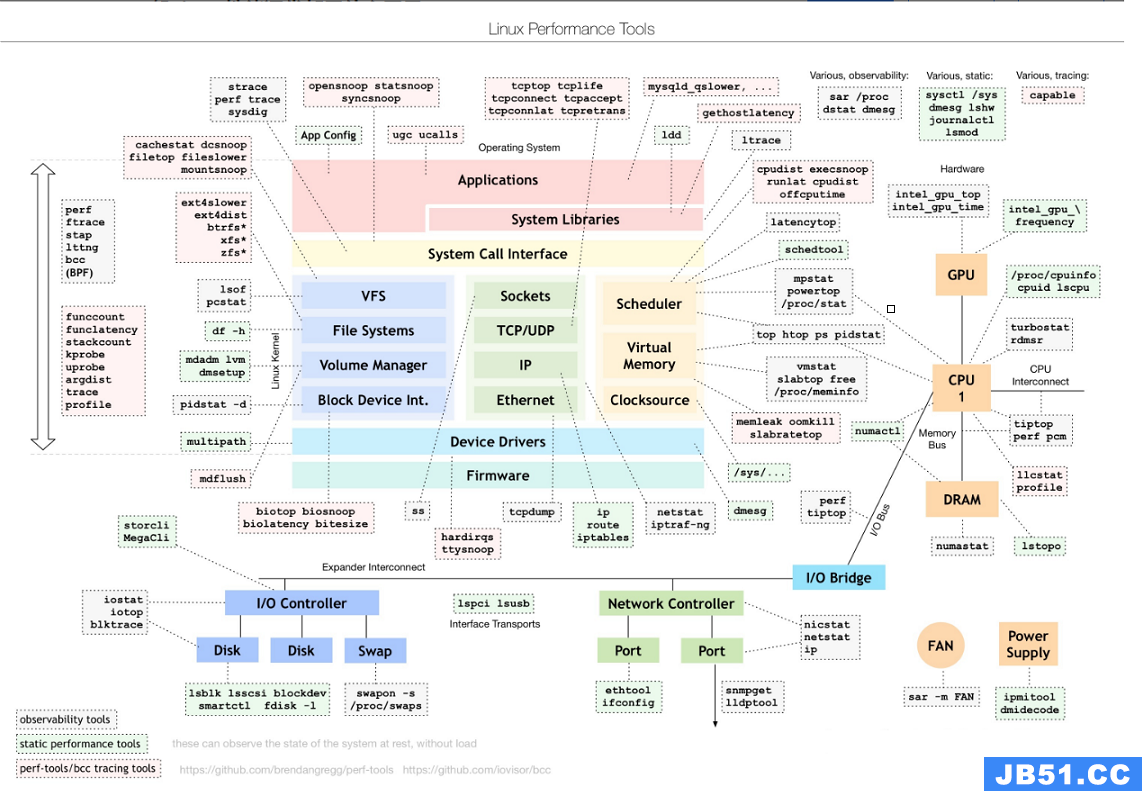

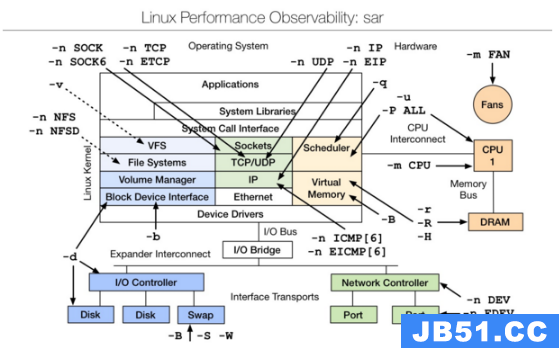

1、Linux系统状态分析工具

和上面图是同一个链接:

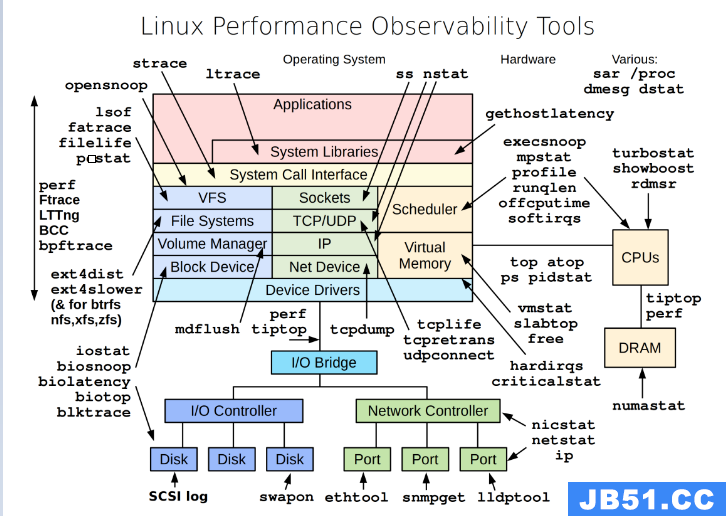

Linux 性能观测工具:

Basic Tool有如下:

uptime、top(htop)、mpstat、isstat、vmstat、free、ping、nicstat、dstat。

高级的命令如下:

sar、netstat、pidstat、strace、tcpdump、blktrace、iotop、slabtop、sysctl、/proc。

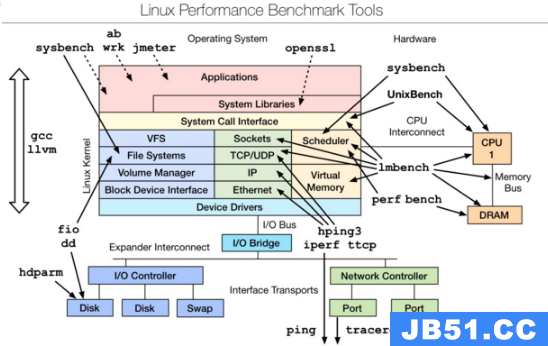

Linux 性能测评工具:

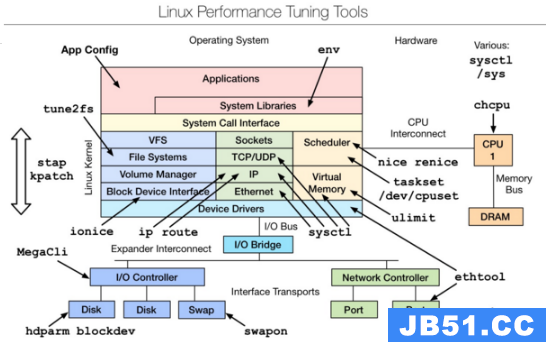

Linux 性能调优工具:

linux性能观测工具:

原文链接如下:

系统运行状态分析工具大体如下:

- 静态代码检测工具或平台:cppcheck、PC-lint、Coverity、QAC C/C++、Clang-Tidy、Clang Static Analyzer、SonarQube+sonar-cxx(推荐)、Facebook的infer

- profiling工具:gnu prof、Oprofile、google gperftools(推荐)、perf、intel VTune、AMD CodeAnalyst

- 内存泄漏:valgrind、AddressSanitizer(推荐)、mtrace、dmalloc、ccmalloc、memwatch、debug_new

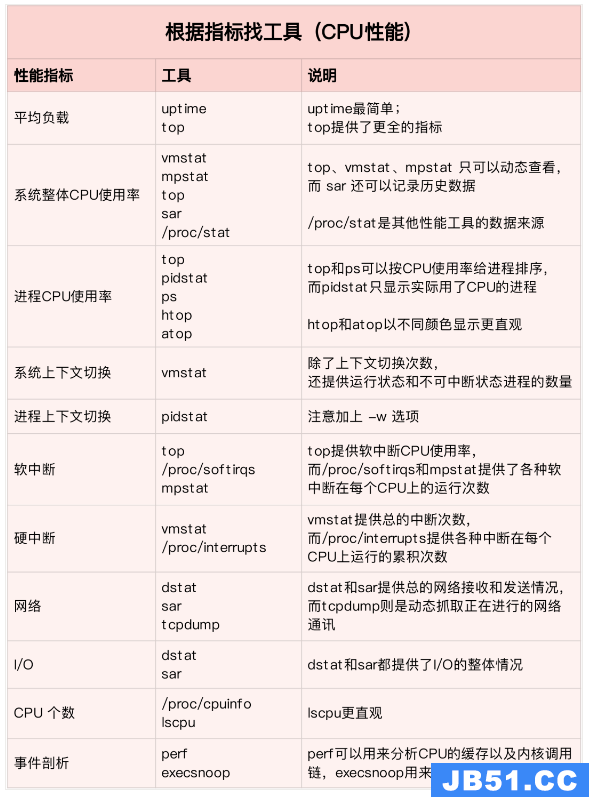

- CPU使用率:pidstat(推荐)、vmstat、mpstat、top、sar

- 上下文切换:pidstat(推荐)、vmstat

- 网络I/O:dstat、tcpdump(推荐)、sar

- 磁盘I/O:iostat(推荐)、dstat、sar

- 系统调用追踪:strace(推荐)

- 网络吞吐量:iftop、nethogs、sar

- 网络延迟:ping

- 文件系统空间:df

- 内存容量:free、vmstat(推荐)、sar

- 进程内存分布:pmap

- CPU负载:uptime、top

- 软中断硬中断:/proc/softirqs、/proc/interrupts

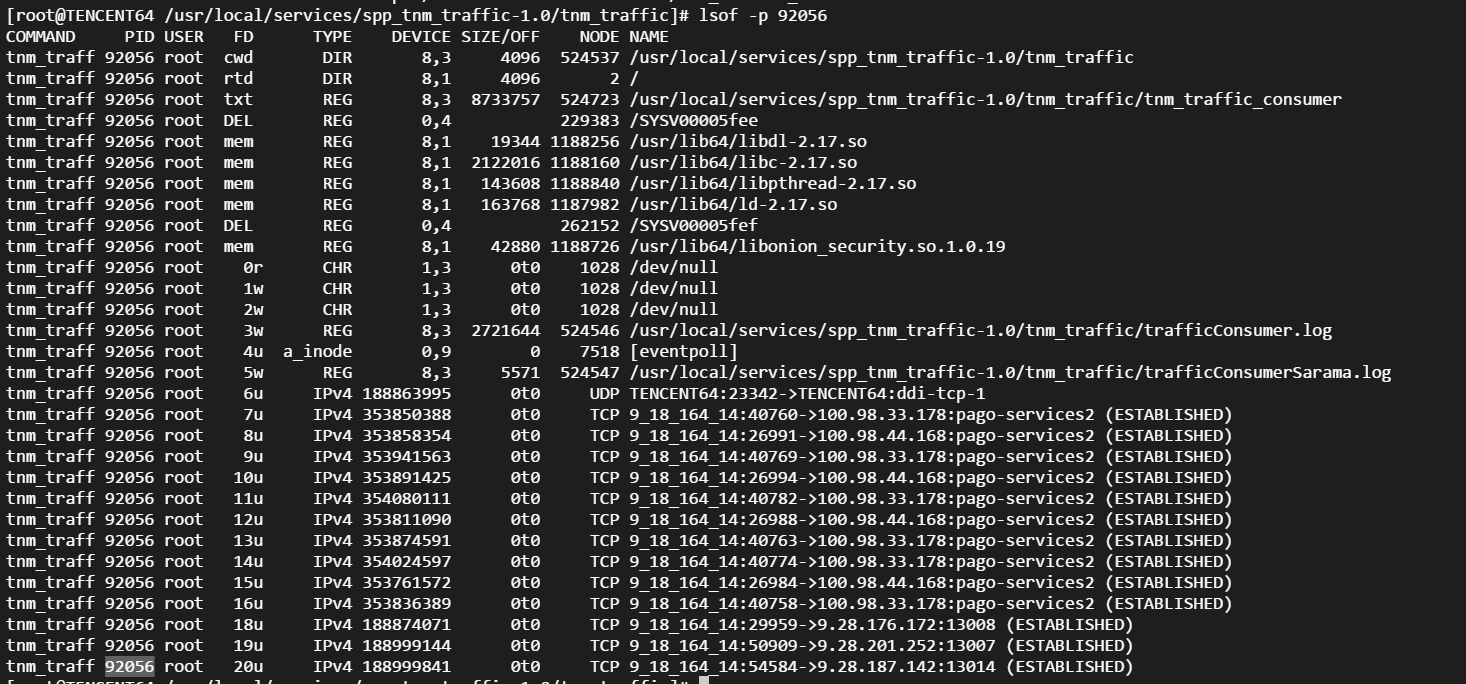

- 确定哪些进程正在使用一组给定的文件:lsof

很多的监控工具 Ubuntu/CentOS 都不自带,需要手动安装,在开始前我们最好先把所有可能用得上的监控工具都装上。(它们都很小,基本不占空间)

# ubuntu/debian

sudo apt-get install \

sysstat iotop fio \

nethogs iftop

# centos

# 需要安装 epel 源,很多监控工具都在该源中!

# 也可使用[阿里云 epel 源](https://developer.aliyun.com/mirror/epel)

sudo yum install epel-release

sudo yum install \

sysstat iotop fio \

nethogs iftop2、大一统的监控工具

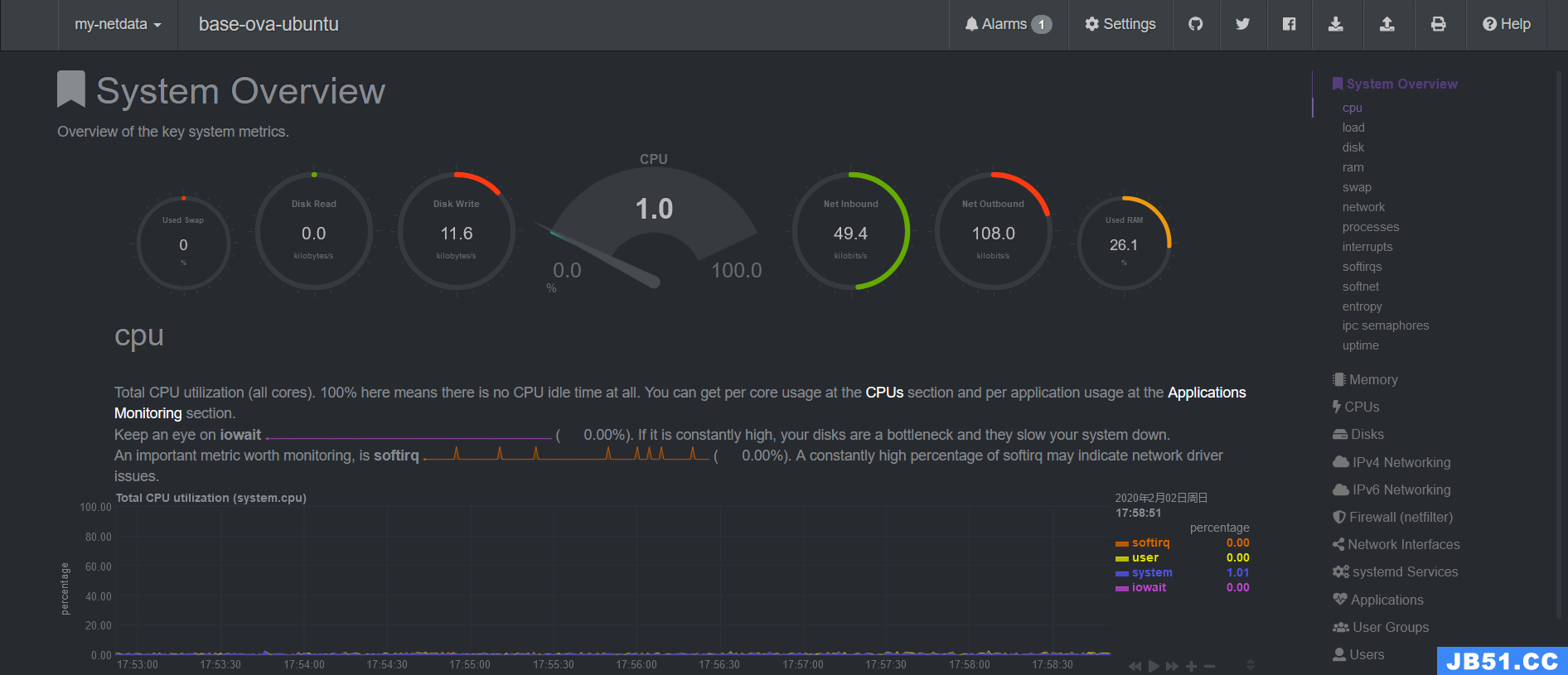

下面介绍两个非常方便的大一统监控工具,它们将一台服务器的所有监控数据汇总到一个地方,方便监控。

多机监控推荐用 prometheus+grafana,不过这一套比较吃性能,个人服务器没必要上。

NetData: 极简安装、超详细超漂亮的 Web UI。

这里只介绍单机监控。NetData 也支持中心化的多机监控,待进一步研究。netdata 也可以被用作 prometheus 的 exporter.

NetData 我要吹爆!它是 Github 上最受欢迎的系统监控工具,目前已经 44.5k star 了。

CPU 占用率低(0.1 核),界面超级漂亮超级详细,还对各种指标做了很详细的说明,安装也是一行命令搞定。相当适合萌新运维。

默认通过 19999 端口提供 Web UI 界面。

sudo apt-get install netdata

# 然后修改 /etc/netdata/netdata.conf,绑定 ip 设为 0.0.0.0

sudo systemctl restart netdata现在就可以访问http://<server-ip>:19999查看超级漂亮超级详细的监控界面了!

Glances: 同样极简安装、方便的命令行 UI

netdata 只以 Web 服务器的方式提供 Web UI,因此必须常驻后台。

如果只是想要临时在 ssh 控制台进行监控,可以使用 Glances,安装命令如下:

sudo apt-get install glances

sudo yum install glances启动命令:glances,可提供 CPU、RAM、NetWork、Disk 和系统状态等非常全面的信息。(只是不够详细)

glances 同样提供中心化的多机监控,还有 Web 界面,但是和 netdata 相比就有些简陋了。

3、Linux主要性能指标说明

一台 Linux 服务器的四类指标如下:

- CPU:使用率、平均负载(load average)

- RAM:used | free | buffer/cache | avaliable

- Disk:空闲容量大小、IO 状态

- Network:网速、延迟、丢包率等

1)CPU指标

1. CPU 使用率

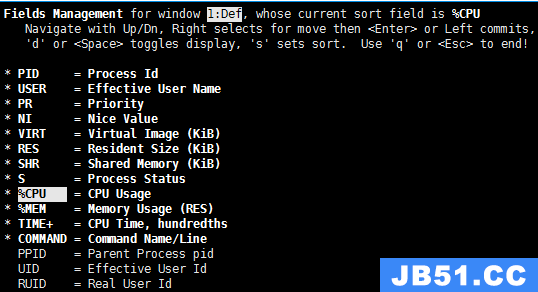

CPU 使用率即 CPU 运行在非空闲状态的时间占比,它反应了 CPU 的繁忙程度。使用 top 命令我们可以得到如下信息:

%Cpu(s): 0.0 us,2.3 sy,0.0 ni,97.7 id,0.0 wa,0.0 hi,0.0 si,0.0 st-

us(user):表示 CPU 在用户态运行的时间百分比,通常用户态 CPU 高表示有应用程序比较繁忙。典型的用户态程序包括:数据库、Web 服务器等。 -

sy(sys):表示 CPU 在内核态运行的时间百分比(不包括中断),通常内核态 CPU 越低越好,否则表示系统存在某些瓶颈。 -

ni(nice):表示用 nice 修正进程优先级的用户态进程执行的 CPU 时间。nice 是一个进程优先级的修正值,如果进程通过它修改了优先级,则会单独统计 CPU 开销。 -

id(idle):表示 CPU 处于空闲态的时间占比,此时,CPU 会执行一个特定的虚拟进程,名为 System Idle Process。 -

wa(iowait):表示 CPU 在等待 I/O 操作完成的时间占比,通常该指标越低越好,否则表示 I/O 可能存在瓶颈,需要用 iostat 等命令做进一步分析。- iowait 只考虑 Synchronous File IO,It does NOT count time spent waiting for IPC objects such as sockets,pipes,ttys,select(),poll(),sleep(),pause() etc.

-

hi(hardirq):表示 CPU 处理硬中断所花费的时间。硬中断是由外设硬件(如键盘控制器、硬件传感器等)发出的,需要有中断控制器参与,特点是快速执行。 -

si(softirq):表示 CPU 处理软中断所花费的时间。软中断是由软件程序(如网络收发、定时调度等)发出的中断信号,特点是延迟执行。 -

st(steal):表示 CPU 被其他虚拟机占用的时间,仅出现在多虚拟机场景。如果该指标过高,可以检查下宿主机或其他虚拟机是否异常。

2. 平均负载(Load Average)

top命令的第一行输出如下:

top - 21:11:00 up 8 min,0 users,load average: 0.52,0.58,0.59其中带有三个平均负载的值,它们的意思分别是** 1 分钟(load1)、5 分钟(load5)、15 分钟(load15)内系统的平均负载**。

平均负载(Load Average)是指单位时间内,系统处于 可运行状态(Running / Runnable) 和 不可中断态 的平均进程数,也就是 平均活跃进程数。

我们知道实际上一个 CPU 核只能跑一个进程,操作系统通过分时调度提供了多进程并行的假象。所以当平均负载(平均活跃进程数)不大于 CPU 逻辑核数时,系统可以正常运转。

如果平均负载超过了核数,那就说明有一部分进程正在活跃中,但是它却没有使用到 CPU(同一时间只能有 1 个进程在使用 CPU),这只可能有两个原因:

- 这部分进程在排队等待 CPU 空闲。

- 这部分 CPU 在进行 IO 操作。

不论是何种状况,都说明系统的负载过高了,需要考虑降负或者升级硬件。

理想状态下,系统满负荷工作,此时平均负载 = CPU 逻辑核数(4核8线程 CPU 有8个逻辑核)。但是,在实际生产系统中,不建议系统满负荷运行。通用的经验法则是:平均负载 <= 0.7 * CPU 逻辑核数。

- 当平均负载持续大于 0.7 * CPU 逻辑核数,就需要开始调查原因,防止系统恶化;

- 当平均负载持续大于 1.0 * CPU 逻辑核数,必须寻找解决办法,降低平均负载;

- 当平均负载持续大于 5.0 * CPU 逻辑核数,表明系统已出现严重问题,长时间未响应,或者接近死机。

除了关注平均负载值本身,我们也应关注平均负载的变化趋势,这包含两层含义。一是 load1、load5、load15 之间的变化趋势;二是历史的变化趋势。

- 当 load1、load5、load15 三个值非常接近,表明短期内系统负载比较平稳。此时,应该将其与昨天或上周同时段的历史负载进行比对,观察是否有显著上升。

- 当 load1 远小于 load5 或 load15 时,表明系统最近 1 分钟的负载在降低,而过去 5 分钟或 15 分钟的平均负载却很高。

- 当 load1 远大于 load5 或 load15 时,表明系统负载在急剧升高,如果不是临时性抖动,而是持续升高,特别是当 load5 都已超过

0.7 * CPU 逻辑核数时,应调查原因,降低系统负载。

日常运维时,应该重点关注上述三个负载值之间的关系。

3. CPU 使用率与平均负载的关系

CPU 使用率是单位时间内 CPU 繁忙程度的统计。而平均负载不仅包括正在使用 CPU 的进程,还包括等待 CPU 或 I/O 的进程(前面讲过平均负载过高的两种情况)。

因此 CPU 使用率是包含在平均负载内的。这两个参数有两种组合需要注意:

- 两个参数值都很高:需要降低 CPU 使用率!

- CPU 使用率很低,可平均负载却超过了CPU逻辑核数:IO 有瓶颈了!需要排查 内存/磁盘/网络 的问题。

- 最常遇到的场景:内存用尽导致负载飙升。

2)RAM内存指标

free # 单位 kb

free -m # 单位 mb

free -g # 单位 gb

不考虑 Swap 时,建议以 Avaliable 值为可用内存的参考,因为 buffer/cache 中的内存不一定能完全释放出来!因为:

- OS 本身需要占用一定 buffer/cache

- 通过 tmpfs 等方式被使用的 cache 不能被回收使用

- 通过 cgroups 设置的资源预留无法被别的进程回收利用。(容器资源预留)

内存泄漏

内存泄漏有多种可能,通过监控能确定的只有内存是否在无上限地上升。很难直接通过监控排查。

3)Disk 磁盘指标

Disk 的性能指标主要有:

- bandwidth 带宽,即每秒的 IO 吞吐量

- 连续读写频繁的应用(传输大量连续的数据)重点关注吞吐量,如读写视频的应用。

- IOPS,每秒的 IO 次数

- 随机读写频繁的应用需要关注 IOPS,如大量小文件(图片等)的读写。

我们是 Web 服务器/数据库服务器,主要是随机读写,更关注 IOPS。

1. IO 基准测试

要监控磁盘的指标,首先得有个基准值做参考。

方法一:对整块磁盘进行测试

首先安装磁盘测试工具 fio(安装命令见文章开始),然后将如下内容保存为fio-rand-rw.fio(Web 服务器/数据库更关注随机读写):

; https://github.com/axboe/fio/blob/master/examples/fio-rand-RW.fio

; fio-rand-RW.job for fiotest

[global]

name=fio-rand-RW

filename=fio-rand-RW

rw=randrw

rwmixread=60

rwmixwrite=40

bs=4K

direct=0

numjobs=4

time_based=1

runtime=900

[file1]

size=4G

ioengine=libaio

iodepth=16

现在运行命令fio fio-rand-rw.fio以启动测试,可根据情况调整 .fio 文件中的参数,最后记录测试结果。

方法二:使用 dd 进行磁盘速度测试

使用 dd 测试的好处是系统自带,而且也不会破坏磁盘内容。

# 写入测试,读取 /dev/zero 这个空字符流,写入到 test.dbf 中(就是只测写入)

# 块大小为 8k,也就是说偏向随机写

dd if=/dev/zero of=test.dbf bs=8k count=50000 oflag=dsync # 每次写完一个 block 都同步,伤硬盘,不要没事就测

# 读取 /dev/sda1 中的数据,写入到 /dev/null 这个黑洞中(只测读取)

# 块大小还是 8k,即偏向随机读

dd if=/dev/sda1 of=/dev/null bs=8k

日常监控的数值远低于上面测得的基准值的情况下,基本就可以确定磁盘没有问题。

2. 使用率

通过df -h查看磁盘的使用情况。

磁盘不足会导致各种问题,比如:

- ElasticSearch 自动将索引设为只读,禁止写入。

- k8s 报告 "Disk Pressure",导致节点无法调度。

- shell 的 tab 补全无法使用,会报错。

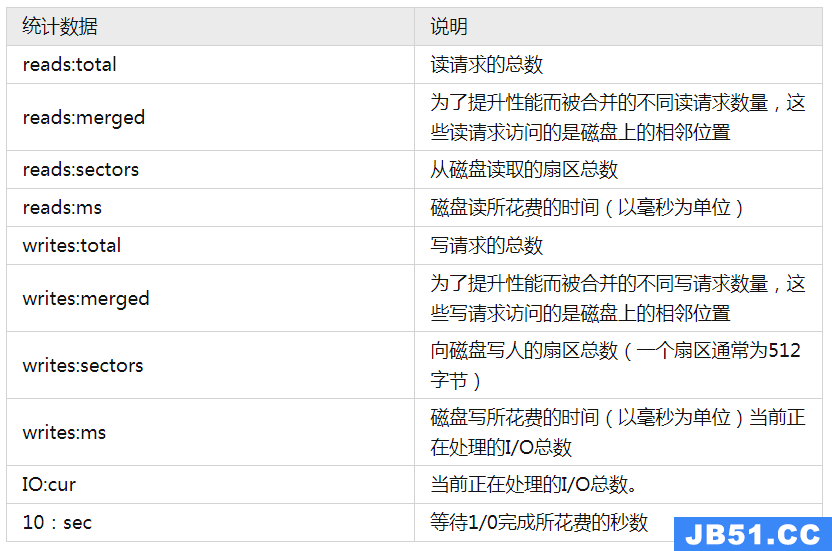

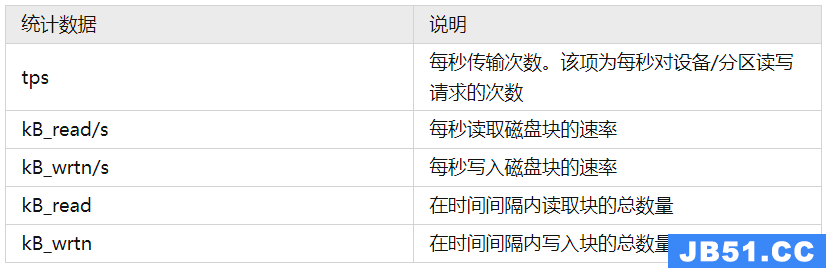

3. IO 带宽(吞吐量)以及 IOPS

使用 iostat 查看磁盘 io 的状态(需要安装 sysstat):

# 每个磁盘一列,给出所有磁盘的当前状态

iostat -d -k 3 # 以 kb 为单位,3 秒刷新一次

iostat -d -m 3 # 以 mb 为单位,其他不变

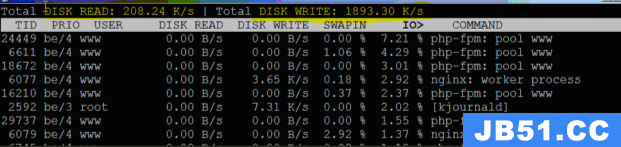

# 每个进程一列,可用于排查各进程的磁盘使用状态

iotop将监控值与前述测试得到的基准值进行对比,低很多的话,基本就可以确认磁盘没问题。

4)Network网络指标

和 IO 指标类似,网络指标主要有:

- socket 连接

- 连接数存在上限,该上限与 Linux 的文件描述符上限等参数有关。

- 广为人知的 DDOS 攻击,通过 TCP 连接的 ACK 洪泛来使服务器瘫痪,针对的就是 TCP 协议的一个弱点。

- 网络带宽(吞吐量)

- PPS(Packets Per Second) 数据包的收发速率

- 网络延迟:一般通过 ping 来确定网络延迟和丢包率

- 丢包率等等

- DNS 解析

客户端与服务器之间的整条网络链路的任何一部分出现故障或配置不当,都可能导致上述的监控参数异常,应用无法正常运行。典型的如交换机、负载均衡器、Kubernetes 配置、Linux 系统参数(sysctl/ulimit)配置不当等。

1. 网络带宽监控

- nethogs: 每个进程的带宽监控,并且进程是按带宽排序的

- 使用:

sudo nethogs - 快速分析出占用大量带宽的进程

- 使用:

- tcpdump/tshark/mitmproxy: 命令行的网络抓包工具,mitmproxy 提供 Web UI 界面,而 tshark 是 wireshark 的命令行版本。

-

tcpdump -i eth0 -w dump.pcap: 使用 tcpdump 抓 eth0 的数据包,保存到 dump.pcap 中。之后可以通过 scp/ssh 等命令将该 pcap 文件拷贝下来,使用 wireshark 进行分析。

-

2. Socket

Socket 的状态查看方法:

# 查看 socket 连接的统计信息

# 主要统计处于各种状态的 tcp sockets 数量,以及其他 sockets 的统计信息

ss --summary

ss -s # 缩写

# 查看哪个进程在监听 80 端口

# --listening 列出所有正在被监听的 socket

# --processes 显示出每个 socket 对应的 process 名称和 pid

# --numeric 直接打印数字端口号(不解析协议名称)

ss --listening --processes --numeric | grep 80

ss -nlp | grep 80 # 缩写

ss -lp | grep http # 解析协议名称,然后通过协议名搜索监听

## 使用过时的 netstat

### -t tcp

### -u udp

netstat -tunlp | grep ":80"

# 查看 sshd 当前使用的端口号

ss --listening --processes | grep sshd

## 使用过时的 netstat

netstat -tunlp | grep <pid> # pid 通过 ps 命令获得

# 列出所有的 tcp sockets,包括所有的 socket 状态

ss --tcp --all

# 只列出正在 listen 的 socket

ss --listening

# 列出所有 ESTABLISHED 的 socket(默认行为)

ss

# 统计 TCP 连接数

ss | grep ESTAB | wc -l

# 列出所有 ESTABLISHED 的 socket,并且给出连接的计时器

ss --options

# 查看所有来自 192.168.5 的 sockets

ss dst 192.168.1.5

# 查看本机与服务器 192.168.1.100 建立的 sockets

ss src 192.168.1.5

# 查看路由表

routel3. 网络延迟、丢包率

通过 ping 命令进行测试,使用 pathping (仅 Windows)进行分段网络延迟与丢包率测试。

4. DNS故障排查

dig +trace baidu.com # 诊断 dns 的主要工具,非常强大

host -a baidu.com # host 基本就是 dig 的弱化版,不过 host 有个有点就是能打印出它测试过的所有 FQDN

nslookup baidu.com # 和 host 没啥大差别,多个交互式查询不过一般用不到

whois baidu.com # 查询域名注册信息,内网诊断用不到TCP 连接数受 Linux 文件描述符上限控制,可以通过如下方法查看已用文件句柄的数量。

# 已用文件描述符数量

lsof | wc -l

# 文件描述符上限

ulimit -n Docker 容器有自己的 namespace,直接通过宿主机的 ss 命令是查看不到容器的 socket 信息的。

比较直观的方法是直接通过 docker exec 在容器中通过 ss 命令。但是这要求容器中必须自带 ss 等程序,有的精简镜像可能不会自带它。

因此用的更多的方法,有两种:

1. 通过 nsenter 直接在目标容器的 namespace 中使用宿主机的命令。

这个适合单机 docker 的网络诊断,用法如下:

# 1. 查询到容器对应的 pid

PID=$(docker inspect --format {{.State.Pid}} <container_name_or_ID>)

# 2. nsenter 通过 pid 进入容器的 network namespace,执行 ss 查看 socket 信息

nsenter --target $PID --net ss -s

nsenter 这个工具貌似是 docker 自带的,只要装了 docker,ubuntu/centos 都可以直接使用这个命令。

2. 使用专用的网络诊断镜像进行容器网络诊断(SideCar)

这种方式一般用于容器集群的诊断,K8s 社区提供了一个工具 kubectl-debug,以这种 SideCar 的方式进行容器诊断。

5)其他

如果服务器出现问题,但是上述四项参数都没有明显异常,就要考虑是不是系统配置或者应用配置的问题了。

1. 僵尸进程

僵尸进程过多,可以在上述指标都非常正常的情况下,使系统响应变得特别慢。

如果通过 top 命令观察到存在僵尸进程,可以使用如下命令将僵尸进程查找出来:

ps -ef| grep defunc2. sysctl/ulimit 参数设置

sysctl/ulimit 设置不当,可以在上述指标都非常正常的情况下,使系统响应变得特别慢。

案例:为了方便,我在系统的初始化脚本 configure_server.py 里一次性将 redis/elasticsearch/网络 等 sysctl/ulimit 参数全部配置好。结果 elasticsearch 需要设置的 vm.max_map_count 参数导致 redis 服务器在长时间运行后响应变慢。

4、Linux性能优化

高并发和响应快对应着性能优化的两个核心指标:吞吐和延时。

-

应用负载角度:直接影响了产品终端的用户体验

-

系统资源角度:资源使用率、饱和度等

性能问题的本质就是系统资源已经到达瓶颈,但请求的处理还不够快,无法支撑更多的请求。性能分析实际上就是找出应用或系统的瓶颈,设法去避免或缓解它们。

-

选择指标评估应用程序和系统性能

-

为应用程序和系统设置性能目标

-

进行性能基准测试

-

性能分析定位瓶颈

-

性能监控和告警

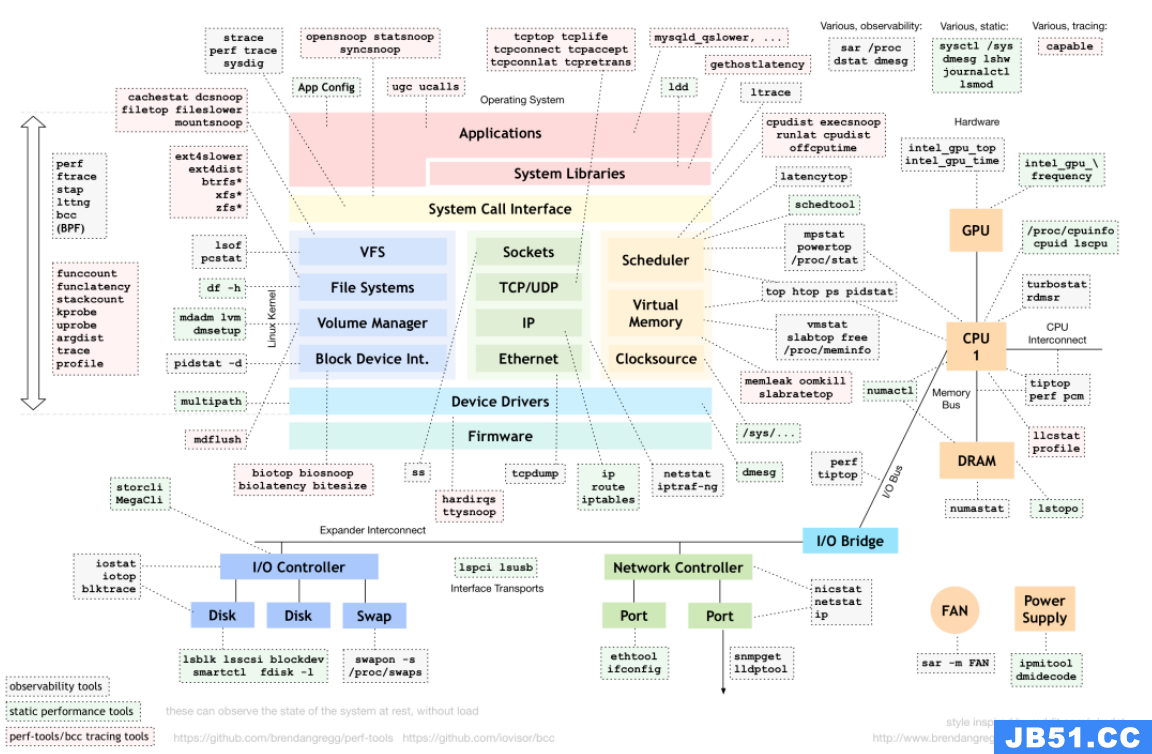

对于不同的性能问题要选取不同的性能分析工具。下面是常用的Linux Performance Tools以及对应分析的性能问题类型。

到底应该怎么理解"平均负载"

平均负载:单位时间内,系统处于可运行状态和不可中断状态的平均进程数,也就是平均活跃进程数。它和我们传统意义上理解的CPU使用率并没有直接关系。

其中不可中断进程是正处于内核态关键流程中的进程(如常见的等待设备的I/O响应)。不可中断状态实际上是系统对进程和硬件设备的一种保护机制。

平均负载多少时合理

实际生产环境中将系统的平均负载监控起来,根据历史数据判断负载的变化趋势。当负载存在明显升高趋势时,及时进行分析和调查。当然也可以当设置阈值(如当平均负载高于CPU数量的70%时)

现实工作中我们会经常混淆平均负载和CPU使用率的概念,其实两者并不完全对等:

-

CPU密集型进程,大量CPU使用会导致平均负载升高,此时两者一致

-

I/O密集型进程,等待I/O也会导致平均负载升高,此时CPU使用率并不一定高

-

大量等待CPU的进程调度会导致平均负载升高,此时CPU使用率也会比较高

平均负载高时可能是CPU密集型进程导致,也可能是I/O繁忙导致。具体分析时可以结合mpstat/pidstat工具辅助分析负载来源。

CPU上下文切换

CPU上下文切换,就是把前一个任务的CPU上下文(CPU寄存器和PC)保存起来,然后加载新任务的上下文到这些寄存器和程序计数器,最后再跳转到程序计数器所指的位置,运行新任务。其中,保存下来的上下文会存储在系统内核中,待任务重新调度执行时再加载,保证原来的任务状态不受影响。

按照任务类型,CPU上下文切换分为:

-

进程上下文切换

-

线程上下文切换

-

中断上下文切换

进程上下文切换

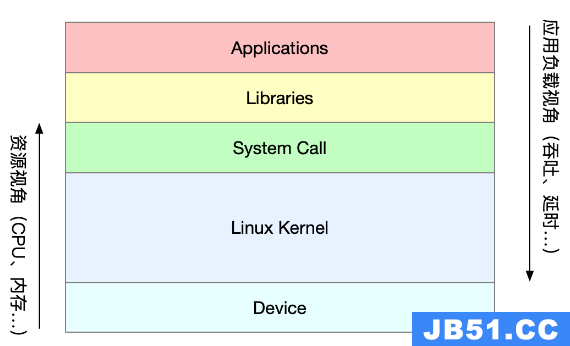

Linux进程按照等级权限将进程的运行空间分为内核空间和用户空间。从用户态向内核态转变时需要通过系统调用来完成。

一次系统调用过程其实进行了两次CPU上下文切换:

-

CPU寄存器中用户态的指令位置先保存起来,CPU寄存器更新为内核态指令的位置,跳转到内核态运行内核任务;

-

系统调用结束后,CPU寄存器恢复原来保存的用户态数据,再切换到用户空间继续运行。

系统调用过程中并不会涉及虚拟内存等进程用户态资源,也不会切换进程。和传统意义上的进程上下文切换不同。因此系统调用通常称为特权模式切换。

进程是由内核管理和调度的,进程上下文切换只能发生在内核态。因此相比系统调用来说,在保存当前进程的内核状态和CPU寄存器之前,需要先把该进程的虚拟内存,栈保存下来。再加载新进程的内核态后,还要刷新进程的虚拟内存和用户栈。

进程只有在调度到CPU上运行时才需要切换上下文,有以下几种场景:CPU时间片轮流分配,系统资源不足导致进程挂起,进程通过sleep函数主动挂起,高优先级进程抢占时间片,硬件中断时CPU上的进程被挂起转而执行内核中的中断服务。

线程上下文切换

线程上下文切换分为两种:

-

前后线程同属于一个进程,切换时虚拟内存资源不变,只需要切换线程的私有数据,寄存器等;

-

前后线程属于不同进程,与进程上下文切换相同。

同进程的线程切换消耗资源较少,这也是多线程的优势。

中断上下文切换

中断上下文切换并不涉及到进程的用户态,因此中断上下文只包括内核态中断服务程序执行所必须的状态(CPU寄存器,内核堆栈,硬件中断参数等)。

中断处理优先级比进程高,所以中断上下文切换和进程上下文切换不会同时发生。

CPU上下文切换(下)

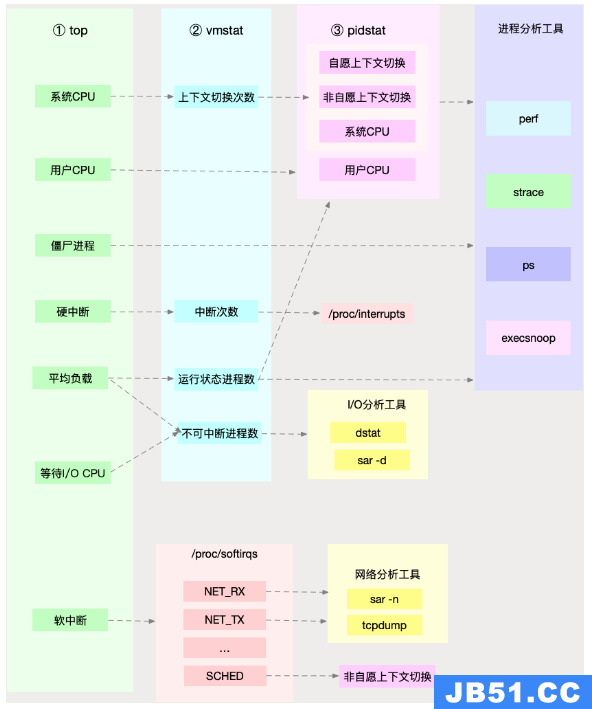

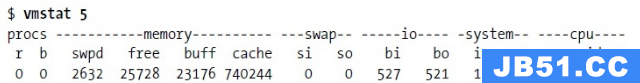

通过vmstat可以查看系统总体的上下文切换情况:

vmstat 5 #每隔5s输出一组数据

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

1 0 0 103388 145412 511056 0 0 18 60 1 1 2 1 96 0 0

0 0 0 103388 145412 511076 0 0 0 2 450 1176 1 1 99 0 0

0 0 0 103388 145412 511076 0 0 0 8 429 1135 1 1 98 0 0

0 0 0 103388 145412 511076 0 0 0 0 431 1132 1 1 98 0 0

0 0 0 103388 145412 511076 0 0 0 10 467 1195 1 1 98 0 0

1 0 0 103388 145412 511076 0 0 0 2 426 1139 1 0 99 0 0

4 0 0 95184 145412 511108 0 0 0 74 500 1228 4 1 94 0 0

0 0 0 103512 145416 511076 0 0 0 455 723 1573 12 3 83 2 0-

cs (context switch) 每秒上下文切换次数

-

in (interrupt) 每秒中断次数

-

r (runnning or runnable)就绪队列的长度,正在运行和等待CPU的进程数

-

b (Blocked) 处于不可中断睡眠状态的进程数

要查看每个进程的详细情况,需要使用pidstat来查看每个进程上下文切换情况:

pidstat -w 5

14时51分16秒 UID PID cswch/s nvcswch/s Command

14时51分21秒 0 1 0.80 0.00 systemd

14时51分21秒 0 6 1.40 0.00 ksoftirqd/0

14时51分21秒 0 9 32.67 0.00 rcu_sched

14时51分21秒 0 11 0.40 0.00 watchdog/0

14时51分21秒 0 32 0.20 0.00 khugepaged

14时51分21秒 0 271 0.20 0.00 jbd2/vda1-8

14时51分21秒 0 1332 0.20 0.00 argusagent

14时51分21秒 0 5265 10.02 0.00 AliSecGuard

14时51分21秒 0 7439 7.82 0.00 kworker/0:2

14时51分21秒 0 7906 0.20 0.00 pidstat

14时51分21秒 0 8346 0.20 0.00 sshd

14时51分21秒 0 20654 9.82 0.00 AliYunDun

14时51分21秒 0 25766 0.20 0.00 kworker/u2:1

14时51分21秒 0 28603 1.00 0.00 python3-

cswch 每秒自愿上下文切换次数 (进程无法获取所需资源导致的上下文切换)

-

nvcswch 每秒非自愿上下文切换次数 (时间片轮流等系统强制调度)

vmstat 1 1 #首先获取空闲系统的上下文切换次数

sysbench --threads=10 --max-time=300 threads run #模拟多线程切换问题

vmstat 1 1 #新终端观察上下文切换情况

此时发现cs数据明显升高,同时观察其他指标:

r列: 远超系统CPU个数,说明存在大量CPU竞争

us和sy列:sy列占比80%,说明CPU主要被内核占用

in列: 中断次数明显上升,说明中断处理也是潜在问题说明运行/等待CPU的进程过多,导致大量的上下文切换,上下文切换导致系统的CPU占用率高:

pidstat -w -u 1 #查看到底哪个进程导致的问题从结果中看出是sysbench导致CPU使用率过高,但是pidstat输出的上下文次数加起来也并不多。分析sysbench模拟的是线程的切换,因此需要在pidstat后加-t参数查看线程指标。

另外对于中断次数过多,我们可以通过/proc/interrupts文件读取:

watch -d cat /proc/interrupts发现次数变化速度最快的是重调度中断(RES),该中断用来唤醒空闲状态的CPU来调度新的任务运行。分析还是因为过多任务的调度问题,和上下文切换分析一致。

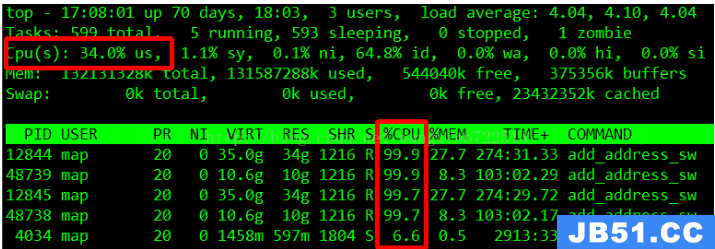

某个应用的CPU使用率达到100%,怎么办?

Linux作为多任务操作系统,将CPU时间划分为很短的时间片,通过调度器轮流分配给各个任务使用。为了维护CPU时间,Linux通过事先定义的节拍率,触发时间中断,并使用全局变了jiffies记录开机以来的节拍数。时间中断发生一次该值+1.

CPU使用率,除了空闲时间以外的其他时间占总CPU时间的百分比。可以通过/proc/stat中的数据来计算出CPU使用率。因为/proc/stat时开机以来的节拍数累加值,计算出来的是开机以来的平均CPU使用率,一般意义不大。可以间隔取一段时间的两次值作差来计算该段时间内的平均CPU使用率。性能分析工具给出的都是间隔一段时间的平均CPU使用率,要注意间隔时间的设置。

CPU使用率可以通过top 或 ps来查看。分析进程的CPU问题可以通过perf,它以性能事件采样为基础,不仅可以分析系统的各种事件和内核性能,还可以用来分析指定应用程序的性能问题。

perf top / perf record / perf report (-g 开启调用关系的采样)

sudo docker run --name nginx -p 10000:80 -itd feisky/nginx

sudo docker run --name phpfpm -itd --network container:nginx feisky/php-fpm

ab -c 10 -n 100 http://XXX.XXX.XXX.XXX:10000/ #测试Nginx服务性能发现此时每秒可承受请求给长少,此时将测试的请求数从100增加到10000。在另外一个终端运行top查看每个CPU的使用率。发现系统中几个php-fpm进程导致CPU使用率骤升。

接着用perf来分析具体是php-fpm中哪个函数导致该问题。

perf top -g -p XXXX #对某一个php-fpm进程进行分析发现其中sqrt和add_function占用CPU过多, 此时查看源码找到原来是sqrt中在发布前没有删除测试代码段,存在一个百万次的循环导致。将该无用代码删除后发现nginx负载能力明显提升

系统的CPU使用率很高,为什么找不到高CPU的应用?

sudo docker run --name nginx -p 10000:80 -itd feisky/nginx:sp

sudo docker run --name phpfpm -itd --network container:nginx feisky/php-fpm:sp

ab -c 100 -n 1000 http://XXX.XXX.XXX.XXX:10000/ #并发100个请求测试实验结果中每秒请求数依旧不高,我们将并发请求数降为5后,nginx负载能力依旧很低。

此时用top和pidstat发现系统CPU使用率过高,但是并没有发现CPU使用率高的进程。

出现这种情况一般时我们分析时遗漏的什么信息,重新运行top命令并观察一会。发现就绪队列中处于Running状态的进行过多,超过了我们的并发请求次数5. 再仔细查看进程运行数据,发现nginx和php-fpm都处于sleep状态,真正处于运行的却是几个stress进程。

下一步就利用pidstat分析这几个stress进程,发现没有任何输出。用ps aux交叉验证发现依旧不存在该进程。说明不是工具的问题。再top查看发现stress进程的进程号变化了,此时有可能时以下两种原因导致:

-

进程不停的崩溃重启(如段错误/配置错误等),此时进程退出后可能又被监控系统重启;

-

短时进程导致,即其他应用内部通过exec调用的外面命令,这些命令一般只运行很短时间就结束,很难用top这种间隔较长的工具来发现

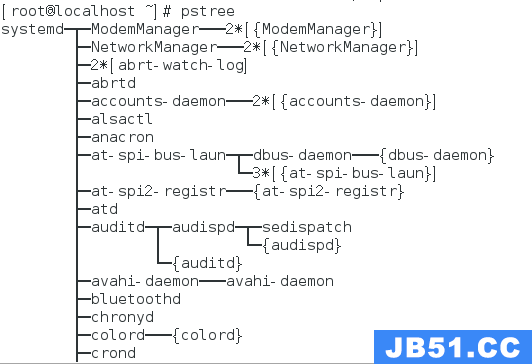

可以通过pstree来查找 stress的父进程,找出调用关系。

pstree | grep stress发现是php-fpm调用的该子进程,此时去查看源码可以看出每个请求都会调用一个stress命令来模拟I/O压力。之前top显示的结果是CPU使用率升高,是否真的是由该stress命令导致的,还需要继续分析。代码中给每个请求加了verbose=1的参数后可以查看stress命令的输出,在中断测试该命令结果显示stress命令运行时存在因权限问题导致的文件创建失败的bug。

此时依旧只是猜测,下一步继续通过perf工具来分析。性能报告显示确实时stress占用了大量的CPU,通过修复权限问题来优化解决即可。

系统中出现大量不可中断进程和僵尸进程怎么办?

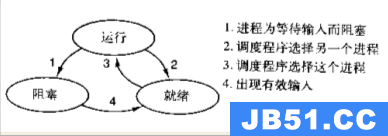

进程状态

-

R Running/Runnable,表示进程在CPU的就绪队列中,正在运行或者等待运行;

-

D Disk Sleep,不可中断状态睡眠,一般表示进程正在跟硬件交互,并且交互过程中不允许被其他进程中断;

-

Z Zombie,僵尸进程,表示进程实际上已经结束,但是父进程还没有回收它的资源;

-

S Interruptible Sleep,可中断睡眠状态,表示进程因为等待某个事件而被系统挂起,当等待事件发生则会被唤醒并进入R状态;

-

I Idle,空闲状态,用在不可中断睡眠的内核线程上。该状态不会导致平均负载升高;

-

T Stop/Traced,表示进程处于暂停或跟踪状态(SIGSTOP/SIGCONT, GDB调试);

-

X Dead,进程已经消亡,不会在top/ps中看到。

对于不可中断状态,一般都是在很短时间内结束,可忽略。但是如果系统或硬件发生故障,进程可能会保持不可中断状态很久,甚至系统中出现大量不可中断状态,此时需注意是否出现了I/O性能问题。

僵尸进程一般多进程应用容易遇到,父进程来不及处理子进程状态时子进程就提前退出,此时子进程就变成了僵尸进程。大量的僵尸进程会用尽PID进程号,导致新进程无法建立。

磁盘O_DIRECT问题:

sudo docker run --privileged --name=app -itd feisky/app:iowait

ps aux | grep '/app'可以看到此时有多个app进程运行,状态分别时Ss+和D+。其中后面s表示进程是一个会话的领导进程,+号表示前台进程组。

其中进程组表示一组相互关联的进程,子进程是父进程所在组的组员。会话指共享同一个控制终端的一个或多个进程组。

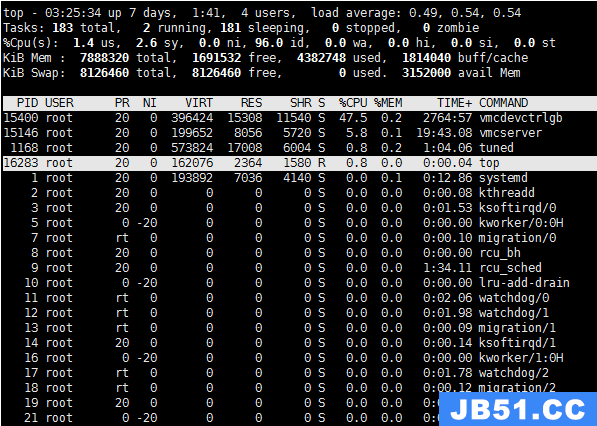

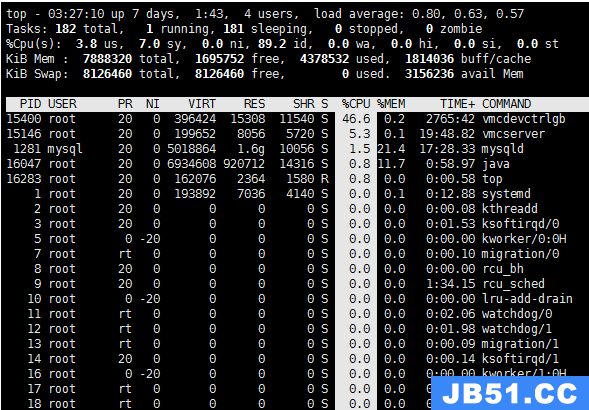

用top查看系统资源发现:1)平均负载在逐渐增加,且1分钟内平均负载达到了CPU个数,说明系统可能已经有了性能瓶颈;2)僵尸进程比较多且在不停增加;3)us和sys CPU使用率都不高,iowait却比较高;4)每个进程CPU使用率也不高,但有两个进程处于D状态,可能在等待IO。

分析目前数据可知:iowait过高导致系统平均负载升高,僵尸进程不断增长说明有程序没能正确清理子进程资源。

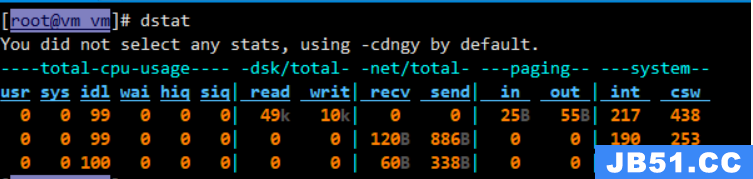

用dstat来分析,因为它可以同时查看CPU和I/O两种资源的使用情况,便于对比分析。

dstat 1 10 #间隔1秒输出10组数据可以看到当wai(iowait)升高时磁盘请求read都会很大,说明iowait的升高和磁盘的读请求有关。接下来分析到底时哪个进程在读磁盘。

之前top查看的处于D状态的进程号,用pidstat -d -p XXX 展示进程的I/O统计数据。发现处于D状态的进程都没有任何读写操作。在用pidstat -d 查看所有进程的I/O统计数据,看到app进程在进行磁盘读操作,每秒读取32MB的数据。进程访问磁盘必须使用系统调用处于内核态,接下来重点就是找到app进程的系统调用。

sudo strace -p XXX #对app进程调用进行跟踪报错没有权限,因为已经时root权限了。所以遇到这种情况,首先要检查进程状态是否正常。ps命令查找该进程已经处于Z状态,即僵尸进程。

这种情况下top pidstat之类的工具无法给出更多的信息,此时像第5篇一样,用perf record -d和perf report进行分析,查看app进程调用栈。

看到app确实在通过系统调用sys_read()读取数据,并且从new_sync_read和blkdev_direct_IO看出进程时进行直接读操作,请求直接从磁盘读,没有通过缓存导致iowait升高。

通过层层分析后,root cause是app内部进行了磁盘的直接I/O。然后定位到具体代码位置进行优化即可。

僵尸进程

上述优化后iowait显著下降,但是僵尸进程数量仍旧在增加。首先要定位僵尸进程的父进程,通过pstree -aps XXX,打印出该僵尸进程的调用树,发现父进程就是app进程。

查看app代码,看看子进程结束的处理是否正确(是否调用wait()/waitpid(),有没有注册SIGCHILD信号的处理函数等)。

碰到iowait升高时,先用dstat pidstat等工具确认是否存在磁盘I/O问题,再找是哪些进程导致I/O,不能用strace直接分析进程调用时可以通过perf工具分析。

对于僵尸问题,用pstree找到父进程,然后看源码检查子进程结束的处理逻辑即可。

CPU性能指标

-

CPU使用率

-

用户CPU使用率,包括用户态(user)和低优先级用户态(nice). 该指标过高说明应用程序比较繁忙.

-

系统CPU使用率,CPU在内核态运行的时间百分比(不含中断). 该指标高说明内核比较繁忙.

-

等待I/O的CPU使用率,iowait,该指标高说明系统与硬件设备I/O交互时间比较长.

-

软/硬中断CPU使用率,该指标高说明系统中发生大量中断.

-

steal CPU / guest CPU,表示虚拟机占用的CPU百分比.

-

-

平均负载

理想情况下平均负载等于逻辑CPU个数,表示每个CPU都被充分利用. 若大于则说明系统负载较重.

-

进程上下文切换

包括无法获取资源的自愿切换和系统强制调度时的非自愿切换. 上下文切换本身是保证Linux正常运行的一项核心功能. 过多的切换则会将原本运行进程的CPU时间消耗在寄存器,内核占及虚拟内存等数据保存和恢复上

-

CPU缓存命中率

CPU缓存的复用情况,命中率越高性能越好. 其中L1/L2常用在单核,L3则用在多核中。

性能工具

-

平均负载案例

-

先用uptime查看系统平均负载

-

判断负载在升高后再用mpstat和pidstat分别查看每个CPU和每个进程CPU使用情况.找出导致平均负载较高的进程.

-

-

上下文切换案例

-

先用vmstat查看系统上下文切换和中断次数

-

再用pidstat观察进程的自愿和非自愿上下文切换情况

-

最后通过pidstat观察线程的上下文切换情况

-

-

进程CPU使用率高案例

-

先用top查看系统和进程的CPU使用情况,定位到进程

-

再用perf top观察进程调用链,定位到具体函数

-

-

系统CPU使用率高案例

-

先用top查看系统和进程的CPU使用情况,top/pidstat都无法找到CPU使用率高的进程

-

重新审视top输出

-

从CPU使用率不高,但是处于Running状态的进程入手

-

perf record/report发现短时进程导致 (execsnoop工具)

-

-

不可中断和僵尸进程案例

-

先用top观察iowait升高,发现大量不可中断和僵尸进程

-

strace无法跟踪进程系统调用

-

perf分析调用链发现根源来自磁盘直接I/O

-

-

软中断案例

-

top观察系统软中断CPU使用率高

-

查看/proc/softirqs找到变化速率较快的几种软中断

-

sar命令发现是网络小包问题

-

tcpdump找出网络帧的类型和来源,确定SYN FLOOD攻击导致

-

根据不同的性能指标来找合适的工具:

在生产环境中往往开发者没有权限安装新的工具包,只能最大化利用好系统中已经安装好的工具. 因此要了解一些主流工具能够提供哪些指标分析:

先运行几个支持指标较多的工具,如top/vmstat/pidstat,根据它们的输出可以得出是哪种类型的性能问题. 定位到进程后再用strace/perf分析调用情况进一步分析. 如果是软中断导致用/proc/softirqs。

CPU优化

-

应用程序优化

-

编译器优化: 编译阶段开启优化选项,如gcc -O2

-

算法优化

-

异步处理: 避免程序因为等待某个资源而一直阻塞,提升程序的并发处理能力. (将轮询替换为事件通知)

-

多线程代替多进程: 减少上下文切换成本

-

善用缓存: 加快程序处理速度

-

-

系统优化

-

CPU绑定: 将进程绑定要1个/多个CPU上,提高CPU缓存命中率,减少CPU调度带来的上下文切换

-

CPU独占: CPU亲和性机制来分配进程

-

优先级调整:使用nice适当降低非核心应用的优先级

-

为进程设置资源显示: cgroups设置使用上限,防止由某个应用自身问题耗尽系统资源

-

NUMA优化: CPU尽可能访问本地内存

-

中断负载均衡: irpbalance,将中断处理过程自动负载均衡到各个CPU上

-

-

TPS、QPS、系统吞吐量的区别和理解

-

QPS(TPS)

-

并发数

-

响应时间

QPS(TPS)=并发数/平均相应时间

-

用户请求服务器

-

服务器内部处理

-

服务器返回给客户

QPS类似TPS,但是对于一个页面的访问形成一个TPS,但是一次页面请求可能包含多次对服务器的请求,可能计入多次QPS

-

QPS (Queries Per Second)每秒查询率,一台服务器每秒能够响应的查询次数.

-

TPS (Transactions Per Second)每秒事务数,软件测试的结果.

-

系统吞吐量,包括几个重要参数:

-

内存

Linux内存是怎么工作的

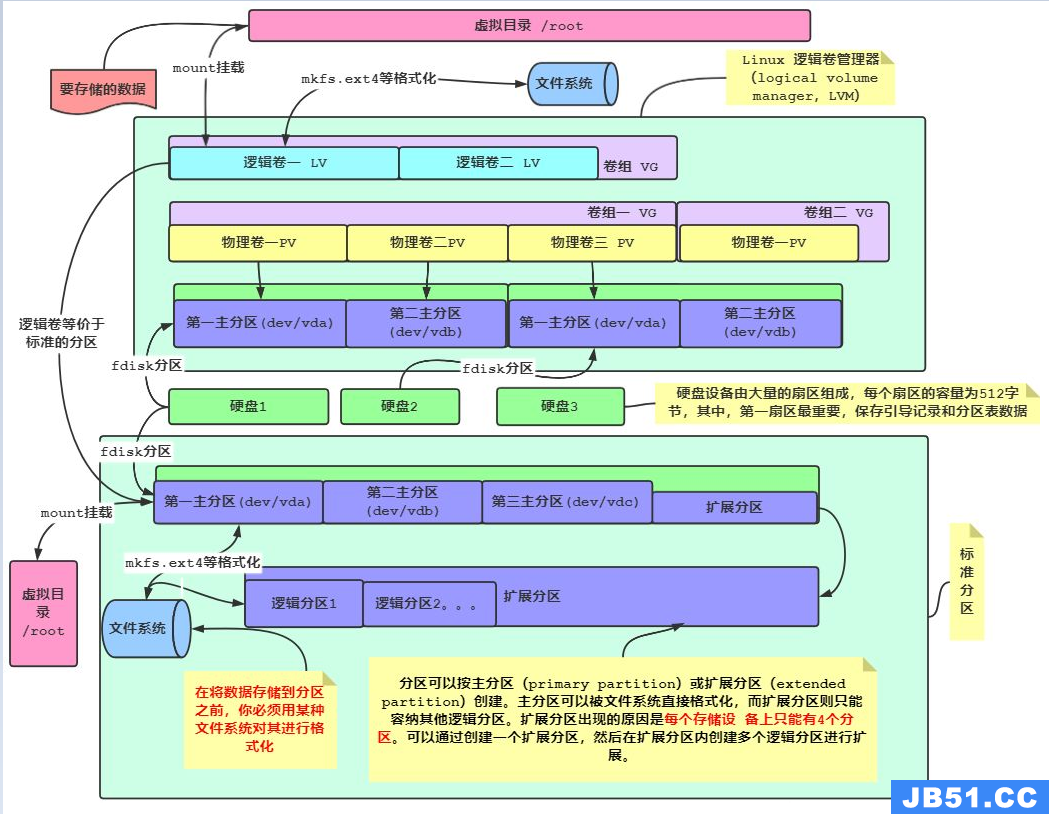

内存映射

大多数计算机用的主存都是动态随机访问内存(DRAM),只有内核才可以直接访问物理内存。Linux内核给每个进程提供了一个独立的虚拟地址空间,并且这个地址空间是连续的。这样进程就可以很方便的访问内存(虚拟内存)。

虚拟地址空间的内部分为内核空间和用户空间两部分,不同字长的处理器地址空间的范围不同。32位系统内核空间占用1G,用户空间占3G。64位系统内核空间和用户空间都是128T,分别占内存空间的最高和最低处,中间部分为未定义。

并不是所有的虚拟内存都会分配物理内存,只有实际使用的才会。分配后的物理内存通过内存映射管理。为了完成内存映射,内核为每个进程都维护了一个页表,记录虚拟地址和物理地址的映射关系。页表实际存储在CPU的内存管理单元MMU中,处理器可以直接通过硬件找出要访问的内存。

当进程访问的虚拟地址在页表中查不到时,系统会产生一个缺页异常,进入内核空间分配物理内存,更新进程页表,再返回用户空间恢复进程的运行。

MMU以页为单位管理内存,页大小4KB。为了解决页表项过多问题Linux提供了多级页表和HugePage的机制。

虚拟内存空间分布

用户空间内存从低到高是五种不同的内存段:

-

只读段 代码和常量等

-

数据段 全局变量等

-

堆 动态分配的内存,从低地址开始向上增长

-

文件映射 动态库、共享内存等,从高地址开始向下增长

-

栈 包括局部变量和函数调用的上下文等,栈的大小是固定的。一般8MB

内存分配与回收

分配

malloc对应到系统调用上有两种实现方式:

-

brk() 针对小块内存(<128K),通过移动堆顶位置来分配。内存释放后不立即归还内存,而是被缓存起来。

-

**mmap()**针对大块内存(>128K),直接用内存映射来分配,即在文件映射段找一块空闲内存分配。

前者的缓存可以减少缺页异常的发生,提高内存访问效率。但是由于内存没有归还系统,在内存工作繁忙时,频繁的内存分配/释放会造成内存碎片。

后者在释放时直接归还系统,所以每次mmap都会发生缺页异常。在内存工作繁忙时,频繁内存分配会导致大量缺页异常,使内核管理负担增加。

上述两种调用并没有真正分配内存,这些内存只有在首次访问时,才通过缺页异常进入内核中,由内核来分配

回收

内存紧张时,系统通过以下方式来回收内存:

-

回收缓存:LRU算法回收最近最少使用的内存页面;

-

回收不常访问内存:把不常用的内存通过交换分区写入磁盘

-

杀死进程:OOM内核保护机制 (进程消耗内存越大oom_score越大,占用CPU越多oom_score越小,可以通过/proc手动调整oom_adj)

echo -16 > /proc/$(pidof XXX)/oom_adj如何查看内存使用情况?

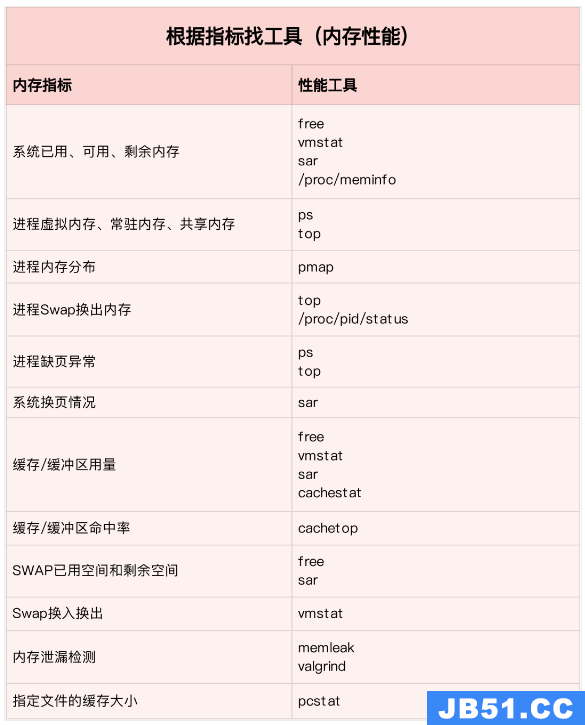

free来查看整个系统的内存使用情况

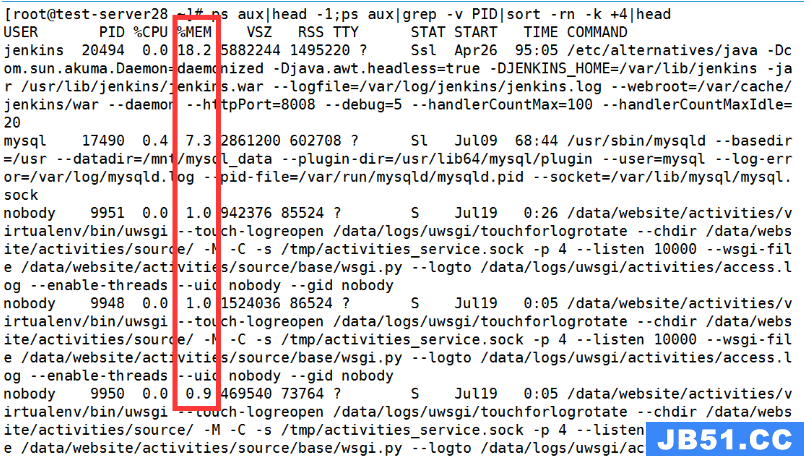

top/ps来查看某个进程的内存使用情况

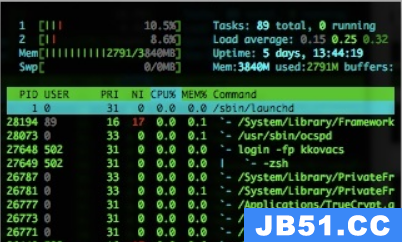

-

VIRT 进程的虚拟内存大小

-

RES 常驻内存的大小,即进程实际使用的物理内存大小,不包括swap和共享内存

-

SHR 共享内存大小,与其他进程共享的内存,加载的动态链接库以及程序代码段

-

%MEM 进程使用物理内存占系统总内存的百分比

怎样理解内存中的Buffer和Cache?

buffer是对磁盘数据的缓存,cache是对文件数据的缓存,它们既会用在读请求也会用在写请求中。

如何利用系统缓存优化程序的运行效率

缓存命中率

缓存命中率是指直接通过缓存获取数据的请求次数,占所有请求次数的百分比。命中率越高说明缓存带来的收益越高,应用程序的性能也就越好。

安装bcc包后可以通过cachestat和cachetop来监测缓存的读写命中情况。

安装pcstat后可以查看文件在内存中的缓存大小以及缓存比例。

#首先安装Go

export GOPATH=~/go

export PATH=~/go/bin:$PATH

go get golang.org/x/sys/unix

go ge github.com/tobert/pcstat/pcstatdd缓存加速:

dd if=/dev/sda1 of=file bs=1M count=512 #生产一个512MB的临时文件

echo 3 > /proc/sys/vm/drop_caches #清理缓存

pcstat file #确定刚才生成文件不在系统缓存中,此时cached和percent都是0

cachetop 5

dd if=file of=/dev/null bs=1M #测试文件读取速度

#此时文件读取性能为30+MB/s,查看cachetop结果发现并不是所有的读都落在磁盘上,读缓存命中率只有50%。

dd if=file of=/dev/null bs=1M #重复上述读文件测试

#此时文件读取性能为4+GB/s,读缓存命中率为100%

pcstat file #查看文件file的缓存情况,100%全部缓存O_DIRECT选项绕过系统缓存:

cachetop 5

sudo docker run --privileged --name=app -itd feisky/app:io-direct

sudo docker logs app #确认案例启动成功

#实验结果表明每读32MB数据都要花0.9s,且cachetop输出中显示1024次缓存全部命中但是凭感觉可知如果缓存命中读速度不应如此慢,读次数时1024,页大小为4K,五秒的时间内读取了1024*4KB数据,即每秒0.8MB,和结果中32MB相差较大。说明该案例没有充分利用缓存,怀疑系统调用设置了直接I/O标志绕过系统缓存。因此接下来观察系统调用。

strace -p $(pgrep app)

#strace 结果可以看到openat打开磁盘分区/dev/sdb1,传入参数为O_RDONLY|O_DIRECT这就解释了为什么读32MB数据那么慢,直接从磁盘读写肯定远远慢于缓存。找出问题后我们再看案例的源代码发现flags中指定了直接IO标志。删除该选项后重跑,验证性能变化。

内存泄漏,如何定位和处理?

对应用程序来说,动态内存的分配和回收是核心又复杂的一个逻辑功能模块。管理内存的过程中会发生各种各样的“事故”:

-

没正确回收分配的内存,导致了泄漏

-

访问的是已分配内存边界外的地址,导致程序异常退出

内存的分配与回收

虚拟内存分布从低到高分别是只读段,数据段,堆,内存映射段,栈五部分。其中会导致内存泄漏的是:

-

堆:由应用程序自己来分配和管理,除非程序退出这些堆内存不会被系统自动释放。

-

内存映射段:包括动态链接库和共享内存,其中共享内存由程序自动分配和管理

内存泄漏的危害比较大,这些忘记释放的内存,不仅应用程序自己不能访问,系统也不能把它们再次分配给其他应用。 内存泄漏不断累积甚至会耗尽系统内存.

如何检测内存泄漏

预先安装systat,docker,bcc:

sudo docker run --name=app -itd feisky/app:mem-leak

sudo docker logs app

vmstat 3可以看到free在不断下降,buffer和cache基本保持不变。说明系统的内存一致在升高。但并不能说明存在内存泄漏。此时可以通过memleak工具来跟踪系统或进程的内存分配/释放请求:

/usr/share/bcc/tools/memleak -a -p $(pidof app)从memleak输出可以看到,应用在不停地分配内存,并且这些分配的地址并没有被回收。通过调用栈看到是fibonacci函数分配的内存没有释放。定位到源码后查看源码来修复增加内存释放函数即可。

为什么系统的Swap变高

系统内存资源紧张时通过内存回收和OOM杀死进程来解决。其中可回收内存包括:

-

缓存/缓冲区,属于可回收资源,在文件管理中通常叫做文件页

-

在应用程序中通过fsync将脏页同步到磁盘

-

交给系统,内核线程pdflush负责这些脏页的刷新

-

被应用程序修改过暂时没写入磁盘的数据(脏页),要先写入磁盘然后才能内存释放

-

-

内存映射获取的文件映射页,也可以被释放掉,下次访问时从文件重新读取

对于程序自动分配的堆内存,也就是我们在内存管理中的匿名页,虽然这些内存不能直接释放,但是Linux提供了Swap机制将不常访问的内存写入到磁盘来释放内存,再次访问时从磁盘读取到内存即可。

Swap原理

Swap本质就是把一块磁盘空间或者一个本地文件当作内存来使用,包括换入和换出两个过程:

-

换出:将进程暂时不用的内存数据存储到磁盘中,并释放这些内存

-

换入:进程再次访问内存时,将它们从磁盘读到内存中

Linux如何衡量内存资源是否紧张?

-

直接内存回收 新的大块内存分配请求,但剩余内存不足。此时系统会回收一部分内存;

-

kswapd0 内核线程定期回收内存。为了衡量内存使用情况,定义了pages_min,pages_low,pages_high三个阈值,并根据其来进行内存的回收操作。

-

剩余内存 < pages_min,进程可用内存耗尽了,只有内核才可以分配内存

-

pages_min < 剩余内存 < pages_low,内存压力较大,kswapd0执行内存回收,直到剩余内存 > pages_high

-

pages_low < 剩余内存 < pages_high,内存有一定压力,但可以满足新内存请求

-

剩余内存 > pages_high,说明剩余内存较多,无内存压力

pages_low = pages_min 5 / 4 pages_high = pages_min 3 / 2

-

NUMA 与 SWAP

很多情况下系统剩余内存较多,但SWAP依旧升高,这是由于处理器的NUMA架构。

在NUMA架构下多个处理器划分到不同的Node,每个Node都拥有自己的本地内存空间。在分析内存的使用时应该针对每个Node单独分析:

numactl --hardware #查看处理器在Node的分布情况,以及每个Node的内存使用情况内存三个阈值可以通过/proc/zoneinfo来查看,该文件中还包括活跃和非活跃的匿名页/文件页数。

当某个Node内存不足时,系统可以从其他Node寻找空闲资源,也可以从本地内存中回收内存。通过/proc/sys/vm/zone_raclaim_mode来调整。

-

0表示既可以从其他Node寻找空闲资源,也可以从本地回收内存

-

1,2,4表示只回收本地内存,2表示可以会回脏数据回收内存,4表示可以用Swap方式回收内存。

swappiness

在实际回收过程中Linux根据/proc/sys/vm/swapiness选项来调整使用Swap的积极程度,从0-100,数值越大越积极使用Swap,即更倾向于回收匿名页;数值越小越消极使用Swap,即更倾向于回收文件页。

注意:这只是调整Swap积极程度的权重,即使设置为0,当剩余内存+文件页小于页高阈值时,还是会发生Swap。

Swap升高时如何定位分析:

free #首先通过free查看swap使用情况,若swap=0表示未配置Swap

#先创建并开启swap

fallocate -l 8G /mnt/swapfile

chmod 600 /mnt/swapfile

mkswap /mnt/swapfile

swapon /mnt/swapfile

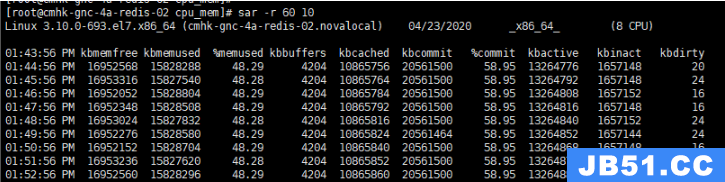

free #再次执行free确保Swap配置成功

dd if=/dev/sda1 of=/dev/null bs=1G count=2048 #模拟大文件读取

sar -r -S 1 #查看内存各个指标变化 -r内存 -S swap

#根据结果可以看出,%memused在不断增长,剩余内存kbmemfress不断减少,缓冲区kbbuffers不断增大,由此可知剩余内存不断分配给了缓冲区

#一段时间之后,剩余内存很小,而缓冲区占用了大部分内存。此时Swap使用之间增大,缓冲区和剩余内存只在小范围波动

停下sar命令

cachetop5 #观察缓存

#可以看到dd进程读写只有50%的命中率,未命中数为4w+页,说明正式dd进程导致缓冲区使用升高

watch -d grep -A 15 ‘Normal’ /proc/zoneinfo #观察内存指标变化

#发现升级内存在一个小范围不停的波动,低于页低阈值时会突然增大到一个大于页高阈值的值说明剩余内存和缓冲区的波动变化正是由于内存回收和缓存再次分配的循环往复。有时候Swap用的多,有时候缓冲区波动更多。此时查看swappiness值为60,是一个相对中和的配置,系统会根据实际运行情况来选去合适的回收类型.

如何“快准狠”找到系统内存存在的问题

内存性能指标

系统内存指标

-

已用内存/剩余内存

-

共享内存 (tmpfs实现)

-

可用内存:包括剩余内存和可回收内存

-

缓存:磁盘读取文件的页缓存,slab分配器中的可回收部分

-

缓冲区:原始磁盘块的临时存储,缓存将要写入磁盘的数据

进程内存指标

-

虚拟内存:5大部分

-

常驻内存:进程实际使用的物理内存,不包括Swap和共享内存

-

共享内存:与其他进程共享的内存,以及动态链接库和程序的代码段

-

Swap内存:通过Swap换出到磁盘的内存

缺页异常

-

可以直接从物理内存中分配,次缺页异常

-

需要磁盘IO介入(如Swap),主缺页异常。此时内存访问会慢很多

内存性能工具

根据不同的性能指标来找合适的工具:

内存分析工具包含的性能指标:

如何迅速分析内存的性能瓶颈

通常先运行几个覆盖面比较大的性能工具,如free,top,vmstat,pidstat等

-

先用free和top查看系统整体内存使用情况

-

再用vmstat和pidstat,查看一段时间的趋势,从而判断内存问题的类型

-

最后进行详细分析,比如内存分配分析,缓存/缓冲区分析,具体进程的内存使用分析等

常见的优化思路:

-

最好禁止Swap,若必须开启则尽量降低swappiness的值

-

减少内存的动态分配,如可以用内存池,HugePage等

-

尽量使用缓存和缓冲区来访问数据。如用堆栈明确声明内存空间来存储需要缓存的数据,或者用Redis外部缓存组件来优化数据的访问

-

cgroups等方式来限制进程的内存使用情况,确保系统内存不被异常进程耗尽

-

/proc/pid/oom_adj调整核心应用的oom_score,保证即使内存紧张核心应用也不会被OOM杀死

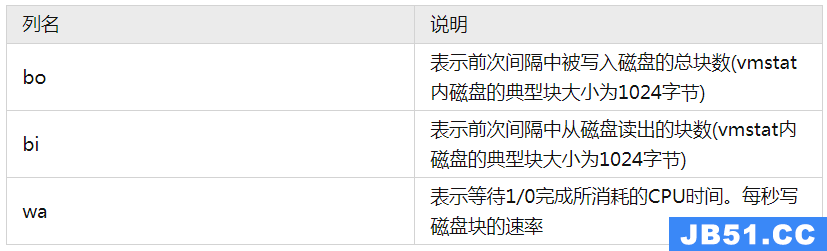

vmstat使用详解

vmstat命令是最常见的Linux/Unix监控工具,可以展现给定时间间隔的服务器的状态值,包括服务器的CPU使用率,内存使用,虚拟内存交换情况,IO读写情况。可以看到整个机器的CPU,内存,IO的使用情况,而不是单单看到各个进程的CPU使用率和内存使用率(使用场景不一样)。

vmstat 2

procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu-----

r b swpd free buff cache si so bi bo in cs us sy id wa st

1 0 0 1379064 282244 11537528 0 0 3 104 0 0 3 0 97 0 0

0 0 0 1372716 282244 11537544 0 0 0 24 4893 8947 1 0 98 0 0

0 0 0 1373404 282248 11537544 0 0 0 96 5105 9278 2 0 98 0 0

0 0 0 1374168 282248 11537556 0 0 0 0 5001 9208 1 0 99 0 0

0 0 0 1376948 282248 11537564 0 0 0 80 5176 9388 2 0 98 0 0

0 0 0 1379356 282256 11537580 0 0 0 202 5474 9519 2 0 98 0 0

1 0 0 1368376 282256 11543696 0 0 0 0 5894 8940 12 0 88 0 0

1 0 0 1371936 282256 11539240 0 0 0 10554 6176 9481 14 1 85 1 0

1 0 0 1366184 282260 11542292 0 0 0 7456 6102 9983 7 1 91 0 0

1 0 0 1353040 282260 11556176 0 0 0 16924 7233 9578 18 1 80 1 0

0 0 0 1359432 282260 11549124 0 0 0 12576 5495 9271 7 0 92 1 0

0 0 0 1361744 282264 11549132 0 0 0 58 8606 15079 4 2 95 0 0

1 0 0 1367120 282264 11549140 0 0 0 2 5716 9205 8 0 92 0 0

0 0 0 1346580 282264 11562644 0 0 0 70 6416 9944 12 0 88 0 0

0 0 0 1359164 282264 11550108 0 0 0 2922 4941 8969 3 0 97 0 0

1 0 0 1353992 282264 11557044 0 0 0 0 6023 8917 15 0 84 0 0

# 结果说明

- r 表示运行队列(就是说多少个进程真的分配到CPU),我测试的服务器目前CPU比较空闲,没什么程序在跑,当这个值超过了CPU数目,就会出现CPU瓶颈了。这个也和top的负载有关系,一般负载超过了3就比较高,超过了5就高,超过了10就不正常了,服务器的状态很危险。top的负载类似每秒的运行队列。如果运行队列过大,表示你的CPU很繁忙,一般会造成CPU使用率很高。

- b 表示阻塞的进程,这个不多说,进程阻塞,大家懂的。

- swpd 虚拟内存已使用的大小,如果大于0,表示你的机器物理内存不足了,如果不是程序内存泄露的原因,那么你该升级内存了或者把耗内存的任务迁移到其他机器。

- free 空闲的物理内存的大小,我的机器内存总共8G,剩余3415M。

- buff Linux/Unix系统是用来存储,目录里面有什么内容,权限等的缓存,我本机大概占用300多M

- cache cache直接用来记忆我们打开的文件,给文件做缓冲,我本机大概占用300多M(这里是Linux/Unix的聪明之处,把空闲的物理内存的一部分拿来做文件和目录的缓存,是为了提高 程序执行的性能,当程序使用内存时,buffer/cached会很快地被使用。)

- si 每秒从磁盘读入虚拟内存的大小,如果这个值大于0,表示物理内存不够用或者内存泄露了,要查找耗内存进程解决掉。我的机器内存充裕,一切正常。

- so 每秒虚拟内存写入磁盘的大小,如果这个值大于0,同上。

- bi 块设备每秒接收的块数量,这里的块设备是指系统上所有的磁盘和其他块设备,默认块大小是1024byte,我本机上没什么IO操作,所以一直是0,但是我曾在处理拷贝大量数据(2-3T)的机器上看过可以达到140000/s,磁盘写入速度差不多140M每秒

- bo 块设备每秒发送的块数量,例如我们读取文件,bo就要大于0。bi和bo一般都要接近0,不然就是IO过于频繁,需要调整。

- in 每秒CPU的中断次数,包括时间中断

- cs 每秒上下文切换次数,例如我们调用系统函数,就要进行上下文切换,线程的切换,也要进程上下文切换,这个值要越小越好,太大了,要考虑调低线程或者进程的数目,例如在apache和nginx这种web服务器中,我们一般做性能测试时会进行几千并发甚至几万并发的测试,选择web服务器的进程可以由进程或者线程的峰值一直下调,压测,直到cs到一个比较小的值,这个进程和线程数就是比较合适的值了。系统调用也是,每次调用系统函数,我们的代码就会进入内核空间,导致上下文切换,这个是很耗资源,也要尽量避免频繁调用系统函数。上下文切换次数过多表示你的CPU大部分浪费在上下文切换,导致CPU干正经事的时间少了,CPU没有充分利用,是不可取的。

- us 用户CPU时间,我曾经在一个做加密解密很频繁的服务器上,可以看到us接近100,r运行队列达到80(机器在做压力测试,性能表现不佳)。

- sy 系统CPU时间,如果太高,表示系统调用时间长,例如是IO操作频繁。

- id 空闲CPU时间,一般来说,id + us + sy = 100,一般我认为id是空闲CPU使用率,us是用户CPU使用率,sy是系统CPU使用率。

- wt 等待IO CPU时间pidstat 使用详解

pidstat主要用于监控全部或指定进程占用系统资源的情况,如CPU,内存、设备IO、任务切换、线程等。

使用方法:

-

pidstat –d interval times 统计各个进程的IO使用情况

-

pidstat –u interval times 统计各个进程的CPU统计信息

-

pidstat –r interval times 统计各个进程的内存使用信息

-

pidstat -w interval times 统计各个进程的上下文切换

-

p PID 指定PID

1、统计IO使用情况

pidstat -d 1 10

03:02:02 PM UID PID kB_rd/s kB_wr/s kB_ccwr/s Command

03:02:03 PM 0 816 0.00 918.81 0.00 jbd2/vda1-8

03:02:03 PM 0 1007 0.00 3.96 0.00 AliYunDun

03:02:03 PM 997 7326 0.00 1904.95 918.81 java

03:02:03 PM 997 8539 0.00 3.96 0.00 java

03:02:03 PM 0 16066 0.00 35.64 0.00 cmagent

03:02:03 PM UID PID kB_rd/s kB_wr/s kB_ccwr/s Command

03:02:04 PM 0 816 0.00 1924.00 0.00 jbd2/vda1-8

03:02:04 PM 997 7326 0.00 11156.00 1888.00 java

03:02:04 PM 997 8539 0.00 4.00 0.00 java-

UID

-

PID

-

kB_rd/s: 每秒进程从磁盘读取的数据量 KB 单位 read from disk each second KB

-

kB_wr/s: 每秒进程向磁盘写的数据量 KB 单位 write to disk each second KB

-

kB_ccwr/s: 每秒进程向磁盘写入,但是被取消的数据量,This may occur when the task truncates some dirty pagecache.

-

iodelay: Block I/O delay,measured in clock ticks

-

Command: 进程名 task name

2、统计CPU使用情况

# 统计CPU

pidstat -u 1 10

03:03:33 PM UID PID %usr %system %guest %CPU CPU Command

03:03:34 PM 0 2321 3.96 0.00 0.00 3.96 0 ansible

03:03:34 PM 0 7110 0.00 0.99 0.00 0.99 4 pidstat

03:03:34 PM 997 8539 0.99 0.00 0.00 0.99 5 java

03:03:34 PM 984 15517 0.99 0.00 0.00 0.99 5 java

03:03:34 PM 0 24406 0.99 0.00 0.00 0.99 5 java

03:03:34 PM 0 32158 3.96 0.00 0.00 3.96 2 ansible-

UID

-

PID

-

%usr: 进程在用户空间占用 cpu 的百分比

-

%system: 进程在内核空间占用 CPU 百分比

-

%guest: 进程在虚拟机占用 CPU 百分比

-

%wait: 进程等待运行的百分比

-

%CPU: 进程占用 CPU 百分比

-

CPU: 处理进程的 CPU 编号

-

Command: 进程名

3、统计内存使用情况

# 统计内存

pidstat -r 1 10

Average: UID PID minflt/s majflt/s VSZ RSS %MEM Command

Average: 0 1 0.20 0.00 191256 3064 0.01 systemd

Average: 0 1007 1.30 0.00 143256 22720 0.07 AliYunDun

Average: 0 6642 0.10 0.00 6301904 107680 0.33 java

Average: 997 7326 10.89 0.00 13468904 8395848 26.04 java

Average: 0 7795 348.15 0.00 108376 1233 0.00 pidstat

Average: 997 8539 0.50 0.00 8242256 2062228 6.40 java

Average: 987 9518 0.20 0.00 6300944 1242924 3.85 java

Average: 0 10280 3.70 0.00 807372 8344 0.03 aliyun-service

Average: 984 15517 0.40 0.00 6386464 1464572 4.54 java

Average: 0 16066 236.46 0.00 2678332 71020 0.22 cmagent

Average: 995 20955 0.30 0.00 6312520 1408040 4.37 java

Average: 995 20956 0.20 0.00 6093764 1505028 4.67 java

Average: 0 23936 0.10 0.00 5302416 110804 0.34 java

Average: 0 24406 0.70 0.00 10211672 2361304 7.32 java

Average: 0 26870 1.40 0.00 1470212 36084 0.11 promtail-

UID

-

PID

-

Minflt/s : 每秒次缺页错误次数 (minor page faults),虚拟内存地址映射成物理内存地址产生的 page fault 次数

-

Majflt/s : 每秒主缺页错误次数 (major page faults),虚拟内存地址映射成物理内存地址时,相应 page 在 swap 中

-

VSZ virtual memory usage : 该进程使用的虚拟内存 KB 单位

-

RSS : 该进程使用的物理内存 KB 单位

-

%MEM : 内存使用率

-

Command : 该进程的命令 task name

4、查看具体进程使用情况

pidstat -T ALL -r -p 20955 1 10

03:12:16 PM UID PID minflt/s majflt/s VSZ RSS %MEM Command

03:12:17 PM 995 20955 0.00 0.00 6312520 1408040 4.37 java

03:12:16 PM UID PID minflt-nr majflt-nr Command

03:12:17 PM 995 20955 0 0 java二、跑机器脚本与工具

1、stress

安装 stress 和 sysstat 包:

apt install stress sysstat

sudo apt install stressCPU 密集型进程

运行 stress 命令,模拟一个 CPU 使用率 100% 的场景:

在一个终端执行:

stress --cpu 1 --timeout 600在另一个终端执行:

watch -d uptime在第三个终端运行 mpstat 查看 CPU 使用率的变化情况。

-P ALL 表示监控所有 CPU,后面数字 5 表示间隔 5 秒后输出一组数据:

root@davinci-mini:/home/HwHiAiUser# mpstat -P ALL 5Linux 4.19.90+ (davinci-mini) 12/23/21 _aarch64_ (8 CPU)查看哪个进程导致了 CPU 使用率高,可以使用 pidstat 来查询。

间隔 5 秒后输出一组数据:

root@davinci-mini:/home/HwHiAiUser# pidstat -u 5 1Linux 4.19.90+ (davinci-mini) 12/23/21 _aarch64_ (8 CPU)I/O 密集型进程

行 stress 命令,但这次模拟 I/O 压力,即不停地执行 sync:

在一个终端执行:

stress -i 1 --timeout 600在第二个终端运行 uptime 查看平均负载的变化情况:

watch -d uptime第三个终端运行 mpstat 查看 CPU 使用率的变化情况。

显示所有 CPU 的指标,并在间隔 5 秒输出一组数据:

mpstat -P ALL 5 1可以看到iowait导致平均负载升高。

哪个进程,导致 iowait 这么高呢? 我们还是用 pidstat 来查询。

间隔 5 秒后输出一组数据,-u 表示 CPU 指标:

pidstat -u 5 1可以发现,是 stress 进程导致的。

大量进程的场景

当系统中运行进程超出 CPU 运行能力时,就会出现等待 CPU 的进程。

我们使用 stress,但这次模拟的是 8 个进程:

stress -c 8 --timeout 600由于系统只有 2 个 CPU,明显比 8 个进程要少得多,因而,系统的 CPU 处于严重过载状态, 平均负载高达 7.97:

uptime...,load average: 7.97,5.93,3.02接着再运行 pidstat 来看一下进程的情况。

间隔 5 秒后输出一组数据,-u 表示 CPU 指标:

pidstat -u 5 18 个进程在争抢 2 个 CPU,每个进程等待 CPU 的时间(也就是代码块中的 %wait 列)高达 75%。这些超出 CPU 计算能力的进程,最终导致 CPU 过载。

总结:

平均负载高有可能是 CPU 密集型进程导致的。

平均负载高并不一定代表 CPU 使用率高,还有可能是 I/O 更繁忙了。

当发现负载高的时候,你可以使用 mpstat、pidstat 等工具,辅助分析负载的来源。

2、sysbench

使用 sysbench 来模拟系统多线程调度切换的情况。

先安装 sysbench 和 sysstat 包:

apt install sysbench sysstat上下文切换导致负载高

vmstat是一个常用的系统性能分析工具,主要用来分析系统的内存使用情况,也常用来分析 CPU 上下文切换和中断的次数:

cs(context switch)是每秒上下文切换的次数。

in(interrupt)则是每秒中断的次数。

r(Running or Runnable)是就绪队列的长度,也就是正在运行和等待 CPU 的进程数。

b(Blocked)则是处于不可中断睡眠状态的进程数。vmstat 只给出了系统总体的上下文切换情况,要想查看每个进程的详细情况,就需要使用我们 前面提到过的 pidstat 了。给它加上 -w 选项,你就可以查看每个进程上下文切换的情况了。

这个结果中有两列内容是我们的重点关注对象:

一个是 cswch ,表示每秒自愿上下文切换 (voluntary context switches)的次数。

另一个则是 nvcswch ,表示每秒非自愿上下文切换 (non voluntary context switches)的次数。

运行sysbench ,模拟系统多线程调度的瓶颈。

以 10 个线程运行 5 分钟的基准测试,模拟多线程切换的问题:

sysbench --threads=10 --max-time=300 threads run在第二个终端运行 vmstat ,观察上下文切换情况:

每隔 1 秒输出 1 组数据(需要 Ctrl+C 才结束):

$ vmstat 1你应该可以发现,cs 列的上下文切换次数从之前的 35 骤然上升到了 139 万。同时,注意观察 其他几个指标:

r 列:就绪队列的长度已经到了 8,远远超过了系统 CPU 的个数 2,所以肯定会有大量的 CPU 竞争。

us(user)和 sy(system)列:这两列的 CPU 使用率加起来上升到了 100%,其中系统 CPU 使用率,也就是 sy 列高达 84%,说明 CPU 主要是被内核占用了。

in 列:中断次数也上升到了 1 万左右,说明中断处理也是个潜在的问题。综合这几个指标,我们可以知道,系统的就绪队列过长,也就是正在运行和等待 CPU 的进程数过多,导致了大量的上下文切换,而上下文切换又导致了系统 CPU 的占用率升高。

那么到底是什么进程导致了这些问题呢?

在第三个终端再用 pidstat 来看一下, CPU 和进程上下文切换的情况:

HwHiAiUser@davinci-mini:~$ pidstat -w -u 1Linux 4.19.90+ (davinci-mini) 12/23/21 _aarch64_ (8 CPU)

19:05:01 UID PID %usr %system %guest %wait %CPU CPU Command19:05:02 0 10 0.00 0.98 0.00 0.00 0.98 1 rcu_sched19:05:02 0 1483 0.98 0.00 0.00 0.00 0.98 3 prometheus19:05:02 0 1904 5.88 0.00 0.00 0.00 5.88 1 java19:05:02 0 2452 1.96 2.94 0.00 0.00 4.90 1 stream19:05:02 0 21148 82.35 22.55 0.00 0.00 100.00 5 vmr-lite19:05:02 0 22155 99.02 11.76 0.00 0.00 100.00 1 analyzer19:05:02 1000 23640 0.98 0.98 0.00 0.00 1.96 3 pidstat

-w 参数表示输出进程切换指标,而 -u 参数则表示输出 CPU 使用指标,-wt 参数表示输出线程的上下文切换指标。

中断

从 /proc/interrupts 这个只读文件中读取。/proc 实际上是 Linux 的一个虚拟文 件系统,用于内核空间与用户空间之间的通信。/proc/interrupts 就是这种通信机制的一部分, 提供了一个只读的中断使用情况。

-d 参数表示高亮显示变化的区域:

$ watch -d cat /proc/interrupts。总结:

首先通过uptime查看系统负载,然后使用mpstat结合pidstat来初步判断到底是cpu计算量大还是进程争抢过大或者是io过多,接着使用vmstat分析切换次数,以及切换类型,来进一步判断到底是io过多导致问题还是进程争抢激烈导致问题。

3、ab

ab是Apache超文本传输协议(HTTP)的性能测试工具。 其设计意图是描绘当前所安装的Apache的执行性能, 主要是显示你安装的Apache每秒可以处理多少个请求。

语法:

ab [ -A auth-username ] [ -c concurrency ] [ -C cookie-name=value ] [ -d ] [ -e csv-file ] [ -g gnuplot-file ] [ -h ] [ -H custom-header ] [ -i ] [ -k ] [ -n requests ] [ -p POST-file ] [ -P proxy-auth-username ] [ -q ] [ -s ] [ -S ] [ -t timelimit ] [ -T content-type ] [ -v verbosity] [ -V ] [ -w ] [ -x <table>-attributes ] [ -X proxy[] ] [ -y <tr>-attributes ] [ -z <td>-attributes ] [http://]hostname[:port]/path参数:

-A auth-username:password

对服务器提供BASIC认证信任。 用户名和密码由一个:隔开,并以base64编码形式发送。 无论服务器是否需要(即,是否发送了401认证需求代码),此字符串都会被发送。

-c concurrency

一次产生的请求个数。默认是一次一个。

-C cookie-name=value

对请求附加一个Cookie:行。 其典型形式是name=value的一个参数对。 此参数可以重复。

-d

不显示"percentage served within XX [ms] table"的消息(为以前的版本提供支持)。

-e csv-file

产生一个以逗号分隔的(CSV)文件, 其中包含了处理每个相应百分比的请求所需要(从1%到100%)的相应百分比的(以微妙为单位)时间。 由于这种格式已经“二进制化”,所以比'gnuplot'格式更有用。

-g gnuplot-file

把所有测试结果写入一个'gnuplot'或者TSV (以Tab分隔的)文件。 此文件可以方便地导入到Gnuplot,IDL,Mathematica,Igor甚至Excel中。 其中的第一行为标题。

-h

显示使用方法。

-H custom-header

对请求附加额外的头信息。 此参数的典型形式是一个有效的头信息行,其中包含了以冒号分隔的字段和值的对 (如,"Accept-Encoding: zip/zop;8bit").

-i

执行HEAD请求,而不是GET。

-k

启用HTTP KeepAlive功能,即,在一个HTTP会话中执行多个请求。 默认时,不启用KeepAlive功能.

-n requests

在测试会话中所执行的请求个数。 默认时,仅执行一个请求,但通常其结果不具有代表意义。

-p POST-file

包含了需要POST的数据的文件.

-P proxy-auth-username:password

对一个中转代理提供BASIC认证信任。 用户名和密码由一个:隔开,并以base64编码形式发送。 无论服务器是否需要(即,是否发送了401认证需求代码),此字符串都会被发送。

-q

如果处理的请求数大于150, ab每处理大约10%或者100个请求时,会在stderr输出一个进度计数。 此-q标记可以抑制这些信息。

-s

用于编译中(ab -h会显示相关信息)使用了SSL的受保护的https, 而不是http协议的时候。此功能是实验性的,也是很简陋的。最好不要用。

-S

不显示中值和标准背离值, 而且在均值和中值为标准背离值的1到2倍时,也不显示警告或出错信息。 默认时,会显示 最小值/均值/最大值等数值。(为以前的版本提供支持).

-t timelimit

测试所进行的最大秒数。其内部隐含值是-n 50000。 它可以使对服务器的测试限制在一个固定的总时间以内。默认时,没有时间限制。

-T content-type

POST数据所使用的Content-type头信息。

-v verbosity

设置显示信息的详细程度 - 4或更大值会显示头信息, 3或更大值可以显示响应代码(404,200等),2或更大值可以显示警告和其他信息。

-V

显示版本号并退出。

-w

以HTML表的格式输出结果。默认时,它是白色背景的两列宽度的一张表。

-x <table>-attributes

设置<table>属性的字符串。 此属性被填入<table 这里 >.

-X proxy[:port]

对请求使用代理服务器。

-y <tr>-attributes

设置<tr>属性的字符串.

-z <td>-attributes

设置<td>属性的字符串.ab性能指标:

1、吞吐率(Requests per second)

服务器并发处理能力的量化描述,单位是reqs/s,指的是在某个并发用户数下单位时间内处理的请求数。某个并发用户数下单位时间内能处理的最大请求数,称之为最大吞吐率。

记住:吞吐率是基于并发用户数的。这句话代表了两个含义:

a、吞吐率和并发用户数相关

b、不同的并发用户数下,吞吐率一般是不同的

计算公式:总请求数/处理完成这些请求数所花费的时间,即

Request per second=Complete requests/Time taken for tests

必须要说明的是,这个数值表示当前机器的整体性能,值越大越好。

2、并发连接数(The number of concurrent connections)

并发连接数指的是某个时刻服务器所接受的请求数目,简单的讲,就是一个会话。

3、并发用户数(Concurrency Level)

要注意区分这个概念和并发连接数之间的区别,一个用户可能同时会产生多个会话,也即连接数。在HTTP/1.1下,IE7支持两个并发连接,IE8支持6个并发连接,FireFox3支持4个并发连接,所以相应的,我们的并发用户数就得除以这个基数。

4、用户平均请求等待时间(Time per request)

计算公式:处理完成所有请求数所花费的时间/(总请求数/并发用户数),即:

Time per request=Time taken for tests/(Complete requests/Concurrency Level)

5、服务器平均请求等待时间(Time per request:across all concurrent requests)

计算公式:处理完成所有请求数所花费的时间/总请求数,即:

Time taken for/testsComplete requests

可以看到,它是吞吐率的倒数。

同时,它也等于用户平均请求等待时间/并发用户数,即

Time per request/Concurrency Level并发 1000 个请求测试 Nginx 性能,总共测试 10000 个请求:

$ ab -c 1000 -n 10000 http://127.0.0.1/sw3560/index.htmlThis is ApacheBench,Version 2.0.40-dev <$Revision: 1.146 $> apache-2.0

Copyright 1996 Adam Twiss,Zeus Technology Ltd,http://www.zeustech.net/

Copyright 2006 The Apache Software Foundation,http://www.apache.org/

Benchmarking 127.0.0.1 (be patient)

Completed 100 requests

Completed 200 requests

Completed 300 requests

Completed 400 requests

Completed 500 requests

Completed 600 requests

Completed 700 requests

Completed 800 requests

Completed 900 requests

Finished 1000 requests

Server Software: Apache/2.2.3

Server Hostname: 127.0.0.1

Server Port: 80

Document Path: /sw3560/index.html

Document Length: 5767 bytes

Concurrency Level: 1000 #并发的用户数

Time taken for tests: 3.85301 seconds #表示所有这些请求被处理完成所花费的时间总和Complete requests: 1000

Failed requests: 0

Write errors: 0

Total transferred: 6034000 bytes #所有请求的响应数据长度总和

HTML transferred: 5767000 bytes #所有请求的响应数据中正文数据的总和

Requests per second: 324.12 [#/sec] (mean) #重点:吞吐率,他等于Complete requests / Time taken for tests(相当于 LR 中的 每秒事务数 ,后面括号中的 mean 表示这是一个平均值)

Time per request: 3085.301 [ms] (mean) #用户平均请求等待时间,他等于Time taken for tests /(Complete requests / Concurrency Level)【相当于 LR 中的 平均事务响应时间】

Time per request: 3.085 [ms] (mean,across all concurrent requests)

#服务器平均请求处理时间他等于Time taken for tests / Complete requests (每个请求实际运行时间的平均值)

Transfer rate: 1909.70 [Kbytes/sec] received

#请求在单位时间内从服务器获取数据的长度他等于Total transferred / Time taken for tests 这个统计选项可以很好的说明服务器在处理能力达到极限时其出口带宽的需求量

Connection Times (ms)

min mean[+/-sd] median max

Connect: 0 30 16.6 30 59

Processing: 21 924 975.9 612 3027

Waiting: 20 923 976.0 612 3026

Total: 21 954 987.4 637 3084

Percentage of the requests served within a certain time (ms)

50% 637

66% 1437

75% 1455

80% 1462

90% 3068

95% 3076

98% 3081

99% 3083

100% 3084 (longest request)

#用于描述每个请求处理时间的分布情况,例如:50% 1 50%请求处理时间不超过1秒 (这里所指的处理时间是指:Time per request )说明:

通过上图,测试结果也一目了然,apache测试出的吞吐率为:Requests per second:324.12[#/sec](mean)。

Server Software表示被测试的Web服务器软件名称。

Server Hostname表示请求的URL主机名。

Server Port表示被测试的Web服务器软件的监听端口。

Document Path表示请求的URL中的根绝对路径,通过该文件的后缀名,我们一般可以了解该请求的类型。

Document Length表示HTTP响应数据的正文长度。

Concurrency Level表示并发用户数,这是我们设置的参数之一。

Time taken for tests表示所有这些请求被处理完成所花费的总时间。

Complete requests表示总请求数量,这是我们设置的参数之一。

Failed requests表示失败的请求数量,这里的失败是指请求在连接服务器、发送数据等环节发生异常,以及无响应后超时的情况。如果接收到的HTTP响应数据的头信息中含有2XX以外的状态码,则会在测试结果中显示另一个名为“Non-2xx responses”的统计项,用于统计这部分请求数,这些请求并不算在失败的请求中。

Total transferred表示所有请求的响应数据长度总和,包括每个HTTP响应数据的头信息和正文数据的长度。注意这里不包括HTTP请求数据的长度,仅仅为web服务器流向用户PC的应用层数据总长度。

TML transferred表示所有请求的响应数据中正文数据的总和,也就是减去了Total transferred中HTTP响应数据中的头信息的长度。

Requests per second吞吐率,计算公式:Complete requests/Time taken for tests

Time per request用户平均请求等待时间,计算公式:Time token for tests/(Complete requests/Concurrency Level)。

Time per requet(across all concurrent request)服务器平均请求等待时间,计算公式:Time taken for tests/Complete requests,正好是吞吐率的倒数。也可以这么统计:Time per request/Concurrency Level。

Transfer rate表示这些请求在单位时间内从服务器获取的数据长度,计算公式:Total trnasferred/ Time taken for tests,这个统计很好的说明服务器的处理能力达到极限时,其出口宽带的需求量。

Percentage of requests served within a certain time(ms)这部分数据用于描述每个请求处理时间的分布情况,比如以上测试,80%的请求处理时间都不超过6ms,这个处理时间是指前面的Time per request,即对于单个用户而言,平均每个请求的处理时间。4、dd

在磁盘测试中我们一般最关心的几个指标分别为:iops(每秒执行的IO次数)、bw(带宽,每秒的吞吐量)、lat(每次IO操作的延迟)。

当每次IO操作的block较小时,如512bytes/4k/8k等,测试的主要是iops。

当每次IO操作的block较大时,如256k/512k/1M等,测试的主要是bw。

dd是linux自带的磁盘读写工具,可用于测试顺序读写。

一般而言,磁盘读写有两种方式:BufferIO、DirectIO,DirectIO可以更好的了解纯磁盘读写的性能。

参数:

if=file:输入文件名,缺省为标准输入

of=file:输出文件名,缺省为标准输出

ibs=bytes:一次读入 bytes 个字节(即一个块大小为 bytes 个字节)

obs=bytes:一次写 bytes 个字节(即一个块大小为 bytes 个字节)

bs=bytes:同时设置读写块的大小为 bytes ,可代替 ibs 和 obs

cbs=bytes:一次转换 bytes 个字节,即转换缓冲区大小

skip=blocks:从输入文件开头跳过 blocks 个块后再开始复制

seek=blocks:从输出文件开头跳过 blocks 个块后再开始复制。(通常只有当输出文件是磁盘或磁带时才有效)

count=blocks:仅拷贝 blocks 个块,块大小等于 ibs 指定的字节数

conv=ASCII:把EBCDIC码转换为ASCIl码。

conv=ebcdic:把ASCIl码转换为EBCDIC码。

conv=ibm:把ASCIl码转换为alternate EBCDIC码。

conv=block:把变动位转换成固定字符。

conv=ublock:把固定位转换成变动位。

conv=ucase:把字母由小写转换为大写。

conv=lcase:把字母由大写转换为小写。

conv=notrunc:不截短输出文件。

conv=swab:交换每一对输入字节。

conv=noerror:出错时不停止处理。

conv=sync:把每个输入记录的大小都调到ibs的大小(用NUL填充)。

FLAGS参数说明:

append -append mode (makes sense only for output; conv=notrunc sug-gested)

direct:读写数据采用直接IO方式;

directory:读写失败除非是directory;

dsync:读写数据采用同步IO;

sync:同上,但是针对是元数据

fullblock:堆积满block(accumulate full blocks of input )(iflag only);

nonblock:读写数据采用非阻塞IO方式

noatime:读写数据不更新访问时间

注意:指定数字的地方若以下列字符结尾乘以相应的数字:b=512,c=1,k=1024,w=2,xm=number m,kB=1000,K=1024,MB=1000*1000,M=1024*1024,GB=1000*1000*1000,G=1024*1024*1024

if=xxx 从xxx读取,如if=/dev/zero,该设备无穷尽地提供0,(不产生读磁盘IO)

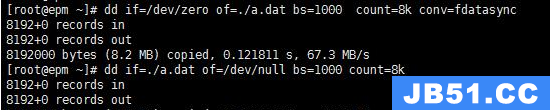

of=xxx 向xxx写出,可以写文件,可以写裸设备。如of=/dev/null,"黑洞",它等价于一个只写文件. 所有写入它的内容都会永远丢失. (不产生写磁盘IO)。

从0设备读入数据并写入zero.img 文件,最后一个参数是为了排除cache的问题:

dd if=/dev/zero of=./zero.img bs=10M count=100 oflag=dsyncdd测试DirectIO:

iops——写测试 dd if=/dev/zero of=./a.dat bs=8k count=1M oflag=direct

iops——读测试 dd if=./a.dat of=/dev/null bs=8k count=1M iflag=direct

bw——写测试 dd if=/dev/zero of=./a.dat bs=1M count=8k oflag=direct

bw——读测试 dd if=./a.dat of=/dev/null bs=1M count=8k iflag=direct

BufferIO主要出现在一些大文件读写的场景,由于使用内存做Cache所以读写性能上和DirectIO相比,通常会高很多,尤其是读,所以这个场景下我们仅关心bw即可。

用dd测试BufferIO的写时,需要增加一个conv=fdatasync,使用该参数,在完成所有读写后会调用一个sync确保数据全部刷到磁盘上(期间操作系统也有可能会主动flush),否则就是主要在测内存读写了;

另外还有一个参数是oflag=dsync 将跳过内存缓存,direct 读写数据采用直接IO方式。使用该参数也是走的BufferIO,但却是会在每次IO操作后都执行一个sync。

测试纯写入性能:

time dd if=/dev/zero of=/tmp/foo bs=4k count=10000 oflag=direct这个命令时往磁盘的文件/tmp/foo中写入一个4G大小的文件,当然文件的内容全部是空字符了,同时用/usr/bin/time来对命令的执行进行计时,命令中的bs指的是写入文件时的块大小,其实就相当于Oracle中的block大小了,count是写入的块数。采取这种方法来写入数据时只是测试的连续读磁盘的性能,而不是随机读的性能,不能采取这种方法检查一个机器的IOPS的,只能检查磁盘的吞吐率。

测试纯读取性能:

time dd if=test of=/dev/null bs=4k count=10000 iflag=direct1. time有计时作用,dd用于复制,从if读出,写到of;

2. if=/dev/zero不产生IO,因此可以用来测试纯写速度;

3. 同理of=/dev/null不产生IO,可以用来测试纯读速度;

4. 将/tmp/test拷贝到/var则同时测试了读写速度;

5. bs是每次读或写的大小,即一个块的大小,count是读写块的数量;

测试的仅仅是最大的读取性能,而不是随机IO的性能。

读写同时测试:

/usr/bin/time dd if=/tmp/foo of=/tmp/foo2 bs=4k通常conv=fdatasync更符合大文件读写的场景,所以这里以其作为参数进行测试。

dd测试BufferIO:

bw——写测试 dd if=/dev/zero of=./a.dat bs=1M count=8k conv=fdatasync

bw——读测试 dd if=./a.dat of=/dev/null bs=1M count=8k

死循环跑dd:

#!/bin/sh

while :

do

dd if=/dev/zero of=./a.dat bs=8k count=100M oflag=direct

usleep 1

done

dd if=/dev/zero of=./a.dat bs=100 count=100 oflag=sync

dd if=/dev/zero of=./a.dat bs=512 count=100 oflag=direct 测试网络IO请求

Server1使用nc监听17480端口的网络I/O请求:

[root@server1 ~]# nc -v -l -n 17480 > /dev/null

Ncat: Version 6.40 ( http://nmap.org/ncat )

Ncat: Listening on :::17480

Ncat: Listening on 0.0.0.0:17480

Ncat: Connection from 192.168.0.97.

Ncat: Connection from 192.168.0.97:39156.在Server2节点上发起网络I/O请求:

[root@server2 ~]# time dd if=/dev/zero | nc -v -n 192.168.0.99 17480

Ncat: Version 6.40 ( http://nmap.org/ncat )

Ncat: Connected to 192.168.0.99:17480.

^C记录了34434250+0 的读入

记录了34434249+0 的写出

17630335488字节(18 GB)已复制,112.903 秒,156 MB/秒

real 1m52.906s

user 1m23.308s

sys 2m22.487s注意:

dd命令用到了time命令对操作进行计时,这样才能正确的进行判断。要记住的一点是dd命令只能够提供一个大概的测试,通过这个简单的命令可以对磁盘系统的最大性能有一个大概的了解。

dd测试是运维常用来测试磁盘读写性能的,配合iostat的一起使用观察磁盘性能。dd测试是顺序写入磁盘,结果是参考值,常用标准块4K测试,根据实际需要调整bs参数。测试时一定加direct值,无缓存测试。需要和线上正常磁盘比对,否则没有参考价值。

5、fio工具

fio是专门用于测试磁盘IO的工具,与dd相比那是要强大非常多,它可以用于测试顺序读写、随机读写、顺序混合读写、随机混合读写,并且可以调整IO并发量,在测试完成后还会生成一份测试报告,相当给力。

参数:

filename=/home/test 测试文件名称,通常选择需要测试的盘的data目录。

direct=1 测试过程绕过机器自带的buffer。使测试结果更真实。

rw=randwrite 测试随机写的I/O

rw=randrw 测试随机写和读的I/O

bs=4k 单次io的块文件大小为4k

size=2g 本次的测试文件大小为2g,以每次4k的io进行测试。

numjobs=64 本次的测试线程为64.

runtime=20 测试时间为20秒,如果不写则一直将2g文件分4k每次写完为止。100%随机,100%读, 4K:

fio -filename=/dev/emcpowerb -direct=1 -iodepth 1 -thread -rw=randread -ioengine=psync -bs=4k -size=1000G -numjobs=50 -runtime=180 -group_reporting -name=rand_100read_4k

test-rand-read: (groupid=0,jobs=64): err= 0: pid=4619

read : io=72556KB,bw=3457.4KB/s,iops=864,runt= 20986msec

//随机读,带宽3457.4KB/s,iops=864100%随机,100%写, 4K:

fio -filename=/dev/emcpowerb -direct=1 -iodepth 1 -thread -rw=randwrite -ioengine=psync -bs=4k -size=1000G -numjobs=50 -runtime=180 -group_reporting -name=rand_100write_4k

test-rand-write: (groupid=0,jobs=64): err= 0: pid=4685

write: io=129264KB,bw=6432.4KB/s,iops=1608,runt= 20097msec

//随机写,带宽6432.4KB/s,iops=1608

100%顺序,100%读 ,4K:

fio -filename=/dev/emcpowerb -direct=1 -iodepth 1 -thread -rw=read -ioengine=psync -bs=4k -size=1000G -numjobs=50 -runtime=180 -group_reporting -name=sqe_100read_4k

test-read: (groupid=0,jobs=4): err= 0: pid=4752

read : io=839680KB,bw=76823KB/s,iops=75,runt= 10930msec

//顺序读,带宽76823KB/s,iops 75100%顺序,100%写 ,4K:

fio -filename=/dev/emcpowerb -direct=1 -iodepth 1 -thread -rw=write -ioengine=psync -bs=4k -size=1000G -numjobs=50 -runtime=180 -group_reporting -name=sqe_100write_4k

test-write: (groupid=0,jobs=4): err= 0: pid=4758

write: io=899072KB,bw=42854KB/s,iops=41,runt= 20980msec

//顺序写,带宽42854KB/s,iops=41100%随机,70%读,30%写 4K:

fio -filename=/dev/emcpowerb -direct=1 -iodepth 1 -thread -rw=randrw -rwmixread=70 -ioengine=psync -bs=4k -size=1000G -numjobs=50 -runtime=180 -group_reporting -name=randrw_70read_4k

6、iozone

测试文件系统性能最全面的工具iozone,可以测试不同的操作系统中文件系统的读写性能。可以测试 Read,write,re-read,re-write,read backwards,read strided,fread,fwrite,random read,pread,mmap,aio_read,aio_write 等等不同的模式下的硬盘的性能。

IO测试的定义:

Write: 测试向一个新文件写入的性能。当一个新文件被写入时,不仅仅是那些文件中的数据需要被存储,还包括那些用于定位数据存储在存储介质的具体位置的额外信息。这些额外信息被称作“元数据”。它包括目录信息,所分配的空间和一些与该文件有关但又并非该文件所含数据的其他数据。拜这些额外信息所赐,Write的性能通常会比Re-write的性能低。

Re-write: 测试向一个已存在的文件写入的性能。当一个已存在的文件被写入时,所需工作量较少,因为此时元数据已经存在。Re-write的性能通常比Write的性能高。

Read: 测试读一个已存在的文件的性能。

Re-Read: 测试读一个最近读过的文件的性能。Re-Read性能会高些,因为操作系统通常会缓存最近读过的文件数据。这个缓存可以被用于读以提高性能。

Random Read: 测试读一个文件中的随机偏移量的性能。许多因素可能影响这种情况下的系统性能,例如:操作系统缓存的大小,磁盘数量,寻道延迟和其他。

Random Write: 测试写一个文件中的随机偏移量的性能。同样,许多因素可能影响这种情况下的系统性能,例如:操作系统缓存的大小,磁盘数量,寻道延迟和其他。

Random Mix: 测试读写一个文件中的随机偏移量的性能。同样,许多因素可能影响这种情况下的系统性能,例如:操作系统缓存的大小,磁盘数量,寻道延迟和其他。这个测试只有在吞吐量测试模式下才能进行。每个线程/进程运行读或写测试。这种分布式读/写测试是基于round robin 模式的。最好使用多于一个线程/进程执行此测试。

Backwards Read: 测试使用倒序读一个文件的性能。这种读文件方法可能看起来很可笑,事实上,有些应用确实这么干。MSC Nastran是一个使用倒序读文件的应用程序的一个例子。它所读的文件都十分大(大小从G级别到T级别)。尽管许多操作系统使用一些特殊实现来优化顺序读文件的速度,很少有操作系统注意到并增强倒序读文件的性能。

Record Rewrite: 测试写与覆盖写一个文件中的特定块的性能。这个块可能会发生一些很有趣的事。如果这个块足够小(比CPU数据缓存小),测出来的性能将会非常高。如果比CPU数据缓存大而比TLB小,测出来的是另一个阶段的性能。如果比此二者都大,但比操作系统缓存小,得到的性能又是一个阶段。若大到超过操作系统缓存,又是另一番结果。

Strided Read: 测试跳跃读一个文件的性能。举例如下:在0偏移量处读4Kbytes,然后间隔200Kbytes,读4Kbytes,再间隔200Kbytes,如此反复。此时的模式是读4Kbytes,间隔200Kbytes并重复这个模式。这又是一个典型的应用行为,文件中使用了数据结构并且访问这个数据结构的特定区域的应用程序常常这样做。

许多操作系统并没注意到这种行为或者针对这种类型的访问做一些优化。同样,这种访问行为也可能导致一些有趣的性能异常。一个例子是在一个数据片化的文件系统里,应用程序的跳跃导致某一个特定的磁盘成为性能瓶颈。

Fwrite: 测试调用库函数fwrite()来写文件的性能。这是一个执行缓存与阻塞写操作的库例程。缓存在用户空间之内。如果一个应用程序想要写很小的传输块,fwrite()函数中的缓存与阻塞I/O功能能通过减少实际操作系统调用并在操作系统调用时增加传输块的大小来增强应用程序的性能。

这个测试是写一个新文件,所以元数据的写入也是要的。

Frewrite:测试调用库函数fwrite()来写文件的性能。这是一个执行缓存与阻塞写操作的库例程。缓存在用户空间之内。如果一个应用程序想要写很小的传输块,fwrite()函数中的缓存与阻塞I/O功能能通过减少实际操作系统调用并在操作系统调用时增加传输块的大小来增强应用程序的性能。

这个测试是写入一个已存在的文件,由于无元数据操作,测试的性能会高些。

Fread:测试调用库函数fread()来读文件的性能。这是一个执行缓存与阻塞读操作的库例程。缓存在用户空间之内。如果一个应用程序想要读很小的传输块,fwrite()函数中的缓存与阻塞I/O功能能通过减少实际操作系统调用并在操作系统调用时增加传输块的大小来增强应用程序的性能。

Freread: 这个测试与上面的fread 类似,除了在这个测试中被读文件是最近才刚被读过。这将导致更高的性能,因为操作系统缓存了文件数据。

几个特殊测试:

Mmap:许多操作系统支持mmap()的使用来映射一个文件到用户地址空间。映射之后,对内存的读写将同步到文件中去。这对一些希望将文件当作内存块来使用的应用程序来说很方便。一个例子是内存中的一块将同时作为一个文件保存在于文件系统中。

mmap 文件的语义和普通文件略有不同。如果发生了对内存的存储,并不是立即发生相应的文件I/O操作。使用MS_SYNC 和MS_ASYNC标志位的 msyc()函数调用将控制内存和文件的一致性。调用msync() 时将MS_SYNC置位将强制把内存里的内容写到文件中去并等待直到此操作完成才返回。而MS_ASYNC 置位则告诉操作系统使用异步机制将内存刷新到磁盘,这样应用程序可以直接返回而不用等待此操作的完成。

这个测试就是测量使用mmap()机制完成I/O的性能。

Async I/O: 许多操作系统支持的另外一种I/O机制是POSIX 标准的异步I/O。本程序使用POSIX标准异步I/O接口来完成此测试功能。

例如: aio_write(),aio_read(),aio_error()。这个测试测量POSIX异步I/O机制的性能。语法:

Usage: iozone [-s filesize_Kb] [-r record_size_Kb ] [-f [path]filename]

[-i test] [-E] [-p] [-a] [-A] [-z] [-Z] [-m] [-M] [-t children] [-h] [-o]

[-l min_number_procs] [-u max_number_procs] [-v] [-R] [-x]

[-d microseconds] [-F path1 path2...] [-V pattern] [-j stride]

[-T] [-C] [-B] [-D] [-G] [-I] [-H depth] [-k depth] [-U mount_point]

[-S cache_size] [-O] [-K] [-L line_size] [-g max_filesize_Kb]

[-n min_filesize_Kb] [-N] [-Q] [-P start_cpu] [-c] [-e] [-b filename]

[-J milliseconds] [-X filename] [-Y filename] [-w] [-W]

[-y min_recordsize_Kb] [-q max_recordsize_Kb] [-+m filename]

[-+u ] [ -+d ] [-+p percent_read] [-+r] [-+t ] [-+A #]参数:

-a

全自动模式测试。测试记录块大小从4k到16M,测试文件从64k到512M

-A

使用自动模式虽然测试比较全面,但是比较花时间。-a选项将在文件大于32MB时停止使用低于64k一下记录块,来节省时间。-A通知iozone不要节省时间,进行所有测试。注:在3.61版本以后不建议使用,用-az代替-aA

-B

使用mmap()。这将使用mmap()接口来创建并访问所有测试用的临时文件。一些应用程序倾向于将文件当作内存的一块来看待。这些应用程序对文件执行mmap()调用,然后就可以以读写内存的方式访问那个块来完成文件I/O。

-c

计算时间将close()包括进来

-C

显示吞吐量测试中每个客户端的字节数。

-D

对mmap文件使用MSYNC(MS_ASYNC)。告诉操作系统在mmap空间的所有数据需要被异步的写到磁盘上。

-e

测试时间是包含flush(fsync,fflush)

-f filename

指定用来测试临时文件,在测试完成后将被自动删除

-F filename filename ...

指定测试中每个临时文件名,文件名的数量应该和指定的进程或线程数相同

-g #

在自动模式下设置文件最大值,可以使用#k #m #g分别表示kb,mb,gb

-G

对mmap文件使用msync(MS_SYNC)。告诉操作系统在mmap空间的所有数据需要被同步的写到磁盘上

-h

显示帮助

-i #

指定运行于哪种模式测试。可以使用-i # -i # -i #进行多个测试

0=write/rewrite

1=read/re-read

2=random read/random write

3=backwards read

4=re-write-record

5=stride-read

6=fwirte/re-fwrite

7=fread/re-fread

8=random mix

9=pwrite/re-pwrite

10=pread/re-pread

11=pwritev/re-pwritev

12=preadv/re-preadv

-I

对所有文件操作使用DIRECT I/O。通知文件系统所有操作跳过缓存直接在磁盘上操作

-j #

设置访问文件的跨度为(# * 块)。stride read测试将使用这个跨度来读块

-J #(毫秒)

在每个I/O操作之前产生指定毫秒的计算延迟。看-X和-Y获取控制计算延迟的其他参数

-l #

设置程序最小进程数。在测试过程允许用户设置的最小进程或线程数。需要配合-u选项使用。

-L #

设置处理器交换信息的单位量为#(bytes)。可以加速测试。

-m

iozone将在内部使用多个缓存。一些程序反复复写一块缓存,还有就是设置多个缓存块。此参数将允许使用这两种模式。iozone默认行为是重复使用内部一个缓存。此选项将允许在内部使用多个缓存块。

-M

调用uname(),将返回字符串放在输出文件中

-n #

设置自动模式下测试文件的最小值

-N

报告结果以毫秒每操作的方式显示

-o

写方式是同步写到磁盘上

-O

报告结果以操作每秒方式显示

-q #

在自动模式下设置记录块的最大值,可以使用#k(kb),#m(mb),#g(gb)。使用-y可以设置最小值

-r #

设置记录块大小为#

-R

使用Excel显示结果

-s #

设置测试文件大小

-S #

设置处理器的缓存大小

-t #

设置测试程序的线程或进程数

-T

使用POSIX的pthreads进行测试

-u #

设置最大进程或线程数,需要配合-l参数使用

-U mountpoint

在测试开始之前,iozone将unmount和remount挂载点。这将保证测试中缓存不包含任何文件

-w

在测试结束后不要删除临时文件。临时文件将在测试过后保存下来

-W

在测试过程中,当读或写文件时锁住文件

-y #

设置记录块最小值

-z

同-a一起使用,进行全部测试

-Z

允许mmap I/O和file I/O混合使用常用的参数说明:

-n -g 用于指定测试的filesize的范围,相对应的-s指定一个确定值;

-y -q 用于指定每次读写的blocksize范围,相对应的-r指定一个定值;

-l -u用于指定使用的用户数从多少到多少;

-a 如果你指定了范围类的参数,那么不加-a,最后的结果只有第一列有数据;

-i 指定测试那种类型的读写,1-12可供选择;

-I 跳过缓存直接读写磁盘;

-f 指定输入文件的具体位置,这个文件一定要在你要测的那个磁盘上;

-F 如果你用了 -l -u 的话,那么里面有多少个用户,就要用这个参数指定多少个文件,文件之间用空格分隔,如:-F tmp.1 tmp.2 tmp.3;

-w 测试之后不删除测试文件;

-R 产生Excel到标准输出

-b 指定输出到指定文件上. 比如 -Rb ttt.xls

-Rb filename.xls 将结果写到Excel表格中;测试的时候请注意,设置的测试文件的大小一定要大过你的内存(最佳为内存的两倍大小),不然linux会给你的读写的内容进行缓存。会使数值非常不真实。

iozone -i 0 -i 2 -Rc -a -q 500k -g 1m -n 100k -b test_result.xls

参数说明如下:

- -i 代表测试场景,0 代表运行顺序写测试,1代表运行随机读写测试。还有很多场景可选,具体可见iozone -h说明

- -R 代表生成Excel报告文件。

- -c 代表每次读写测试完毕都发送关闭连接的命令,主要用于测试NFS系统。

- -a 代表自动模式。

- -q 代表最大的记录大小。

- -g 代表最大的文件大小。

- -n 代表最小的文件大小。

- -b 输出的生成的Excel报告文件名字。

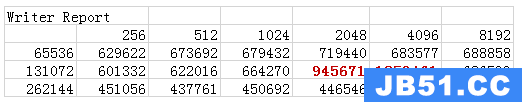

生成报告如下:

自动模式开启,以4k到16M为记录块,读写从64k到512M大小的文件的读写速度(默认以KB为单位)。

./iozone -aR如果想以图表形式显示测试结果,可以使用,iozone将测试结果放在Excel中:

./iozone -a -i 0 -i 1 -i 2 -i 6 -i 7 -i 8 -n 64m -g 256m -y 256 -q 8192 -I -f /mnt/mfs/1m.tmp -w -Rb ./xls/mfs_i.xls 结果的片段如下:

第一行,就是-i指定的那个参数,比如:表中使Writer Report,那么参数中就有 -i 2,当然也有可能是-a自动加的;

第二行,各列值就是由"-y 256 -q 8192"指定的,单位是K,表示每次读写多大,当然在指定的时候也可以写M、G但是B是不起作用的;

第一列,各行就是由"-n 64m -g 256m"指定的,表示读写的文件依次从64m到256m,以2倍的形式增长;

中间的数据单位都是Kb/s表示读写速度;

另外可以看见标红色字体的部分,就是由于指定了"-I"参数,说明磁盘很希望你用每次读2048K的大小读取128M的文件。

如果内存大于512MB,则测试文件需要更大;最好测试文件是内存的两倍。例如内存为1G,将测试文件设置最大为2G:

./iozone -Ra -g 2g如果我们只关心文件磁盘的read/write性能,而不必花费时间在其他模式上测试,则我们需要指定测试模式:

./iozone -Ra -g 2g -i 0 -i 1只进行read/write测试,测试文件大小是4G,记录块从2k到8m,并将测试数据输出到Excel文件中:

./iozone -a -s 4g -i 0 -i 1 -f /tmp/testfile -y 2k -q 8m -Rb output.xls如果我们测试的NFS,将使用-c,这通知iozone在测试过程中执行close()函数。使用close()将减少NFS客户端缓存的影响。但是如果测试文件比内存大,就没有必要使用参数-c:

./iozone -Rac 多线程下的同步I/O读写测试

分别针对128K,16M,256M,2G文件大小和8进程,64进程,128进程数进行测试。

主要测试文件写和重复写、读和重复读、随即读写、后向读、文件内随即点写、大间隔文件点读、文件内的随即点读写等测试项,记录大小1M cpu cache 2048kbyte。

128k 文件性能测试:

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -G -o -B -Rb iozone.xls

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -G -o -B -Rb iozone.xls

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -G -o -B -Rb iozone.xls16M文件性能测试:

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -G -o -B -Rb iozone.xls

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -G -o -B -Rb iozone.xls

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -G -o -B -Rb iozone.xls256M文件性能测试:

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -G -o -B -Rb iozone.xls

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -G -o -B -Rb iozone.xls

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -G -o -B -Rb iozone.xls2G文件性能测试:

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -G -o -B -Rb iozone.xls

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -G -o -B -Rb iozone.xls

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -G -o -B -Rb iozone.xls多线程下的异步I/O读写测试

分别针对128K,16M,256M,2G文件大小和8进程,64进程,128进程数进行测试。

主要测试文件写和重复写、读和重复读、随即读写、后向读、文件内随即点写、大间隔文件点读、文件内的随即点读写等测试项。

128k 文件性能测试:

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -D -o -B -Rb iozone.xls

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -D -o -B -Rb iozone.xls

iozone -s 128k -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -D -o -B -Rb iozone.xls16M文件性能测试:

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -D -o -B -Rb iozone.xls

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -D -o -B -Rb iozone.xls

iozone -s 16M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -D -o -B -Rb iozone.xls256M文件性能测试:

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -D -o -B -Rb iozone.xls

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -D -o -B -Rb iozone.xls

iozone -s 256M -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -D -o -B -Rb iozone.xls2G文件性能测试:

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 8 -D -o -B -Rb iozone.xls

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 64 -D -o -B -Rb iozone.xls

iozone -s 2G -i 0 -i 1 -i 2 -i 3 -i 4 -i 5 -i 8 -t 128 -D -o -B -Rb iozone.xls7、Iperf

Iperf是一个网络性能测试工具,Iperf可以测试TCP和UDP带宽质量。

Iperf可以测量最大TCP带宽,具有多种参数和UDP特性。Iperf可以报告带宽,延迟抖动和数据包丢失。

参数:

-s 以server模式启动,eg:iperf -s

-c host以client模式启动,host是server端地址,eg:iperf -c 222.35.11.23

通用参数

-f [k|m|K|M] 分别表示以Kbits,Mbits,KBytes,MBytes显示报告,默认以Mbits为单位,eg:iperf -c 222.35.11.23 -f K

-i sec 以秒为单位显示报告间隔,eg:iperf -c 222.35.11.23 -i 2

-l 缓冲区大小,默认是8KB,eg:iperf -c 222.35.11.23 -l 16

-m 显示tcp最大mtu值

-o 将报告和错误信息输出到文件eg:iperf -c 222.35.11.23 -o c:\iperflog.txt

-p 指定服务器端使用的端口或客户端所连接的端口eg:iperf -s -p 9999;iperf -c 222.35.11.23 -p 9999

-u 使用udp协议

-w 指定TCP窗口大小,默认是8KB

-B 绑定一个主机地址或接口(当主机有多个地址或接口时使用该参数)

-C 兼容旧版本(当server端和client端版本不一样时使用)

-M 设定TCP数据包的最大mtu值

-N 设定TCP不延时

-V 传输ipv6数据包

server专用参数

-D 以服务方式运行ipserf,eg:iperf -s -D

-R 停止iperf服务,针对-D,eg:iperf -s -R

client端专用参数

-d 同时进行双向传输测试

-n 指定传输的字节数,eg:iperf -c 222.35.11.23 -n 100000

-r 单独进行双向传输测试

-t 测试时间,默认10秒,eg:iperf -c 222.35.11.23 -t 5

-F 指定需要传输的文件

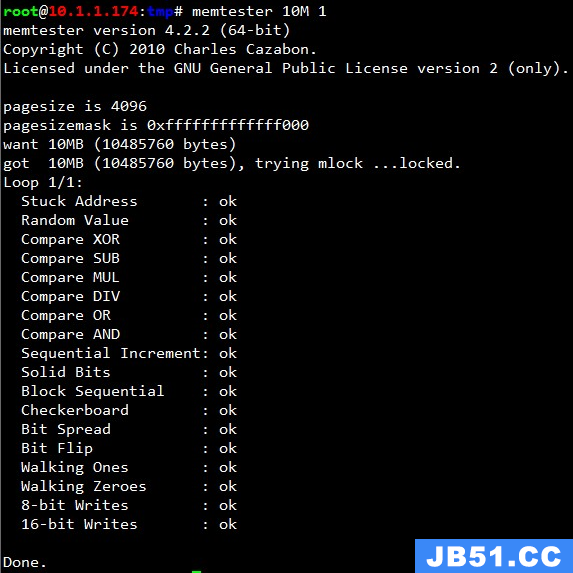

-T 指定ttl值8、memtester

Memtester 主要是捕获内存错误和一直处于很高或者很低的坏位,其测试的主要项目有随机值,异或比较,减法,乘法,除法,与或运算等等。通过给定测试内存的大小和次数,可以对系统现有的内存进行压力测试。

官网:https://pyropus.ca./software/memtester/

语法:

memtester [-p PHYSADDR] <MEMORY> [ITERATIONS]

MEMORY 申请测试内存的数量,单位默认是 megabytes (兆),也可以是 B K M G

ITERATIONS 测试的次数,默认是无限申请 10M 内存:

对内存进行压力测试,申请大内存,放入后台无限测试:

nohup memtester 2G > /tmp/memtest.log &9、消耗CPU脚本

让CPU使用率达到100%

方法一:

for i in `seq 1 $(cat /proc/cpuinfo |grep "physical id" |wc -l)`; do dd if=/dev/zero of=/dev/null & done说明:

cat /proc/cpuinfo |grep "physical id" | wc -l 可以获得CPU的个数, 我们将其表示为N;

seq 1 N 用来生成1到N之间的数字;

for i in `seq 1 N`; 就是循环执行命令,从1到N;

dd if=/dev/zero of=/dev/null 执行dd命令, 输出到/dev/null,实际上只占用CPU,没有IO操作;

由于连续执行N个(N是CPU个数)的dd 命令,且使用率为100%,这时调度器会调度每个dd命令在不同的CPU上处理;

最终就实现所有CPU占用率100%。

另外,上述程序的结束可以使用:

1. fg 后按 ctrl + C (因为该命令是放在后台执行)

2. pkill -9 dd

3. kill -9 <Top最高的那个名字为dd的进程>

脚本方式运行:

vim killCPU.sh

#/bin/bash

for i in `seq 1 $(cat /proc/cpuinfo |grep "physical id" |wc -l)`; do dd if=/dev/zero of=/dev/null & donevim highCPU.sh

#/bin/bash

while true; do sh killCPU.sh $1 ; sleep 2; done可以使用top命令查看效果,预计效果如下所示:

top - 18:19:48 up 14 days,3:48,3 users,load average: 0.31,0.43,0.46

Tasks: 121 total,3 running,118 sleeping,0 stopped,0 zombie

%Cpu(s): 21.5 us,78.1 sy,0.0 id,0.3 si,0.0 st

KiB Mem : 1883884 total,129612 free,1266472 used,487800 buff/cache

KiB Swap: 2097148 total,2064212 free,32936 used. 420084 avail Mem

PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

17133 root 20 0 107948 612 516 R 99.0 0.0 0:08.38 dd

1806 cpic 20 0 4022952 1.125g 12148 S 1.0 62.6 148:11.10 java

401 root 20 0 0 0 0 S 0.3 0.0 6:07.16 xfsaild/dm-0

1 root 20 0 129124 4196 2180 S 0.0 0.2 0:20.00 systemd方法二:

Super PI是利用CPU的浮点运算能力来计算出π(圆周率),所以目前普遍被超频玩家用做测试系统稳定性和测试CPU计算完后特定位数圆周率所需的时间。

官方网站:The domain name super-computing.org is for sale

wget ftp://pi.super-computing.org/Linux/super_pi.tar.gz

tar -xzvf super_pi.tar.gz

./super_pi 2020为位数。表示要算2的多少次方位,如通常要算小数点后1M位。

通过bc命令计算特别函数:

cat a.sh

while :

do

echo 2^2^20|bc &>/dev/null

doneecho "scale=5000; 4*a(1)" | bc -l -q函数说明:

s (x) The sine of x, x is in radians. 正玄函数

c (x) The cosine of x, x is in radians. 余玄函数

a (x) The arctangent of x, arctangent returns radians. 反正切函数

l (x) The natural logarithm of x. log函数(以2为底)

e (x) The exponential function of raising e to the value x. e的指数函数

j (n,x) The bessel function of integer order n of x. 贝塞尔函数

方法三:

使用死循环消耗CPU资源,如果服务器是有多颗CPU,可以选择消耗多少颗CPU的资源:

vim eatcpu.sh

#! /bin/sh

# filename killcpu.sh

if [ $# != 1 ] ; then

echo "USAGE: $0 <CPUs>"

exit 1;

fi

for i in `seq $1`

do

echo -ne "

i=0;

while true

do

i=i+1;

done" | /bin/sh &

pid_array[$i]=$! ;

done

time=$(date "+%Y-%m-%d %H:%M:%S")

echo "${time}"

for i in "${pid_array[@]}"; do

echo 'kill ' $i ';';

done

sleep 60

for i in "${pid_array[@]}"; do

kill $i;

done 消耗3颗cpu,持续60s(可自己设置):

./eatcpu.sh 3

kill 30104 ;

kill 30106 ;

kill 30108 ;

[root@test02 ~]# top

top - 15:27:31 up 264 days,23:39,4 users,load average: 0.86,0.25,0.19

Tasks: 185 total,5 running,180 sleeping,0 zombie

Cpu0 : 100.0% us,0.0% sy,0.0% ni,0.0% id,0.0% wa,0.0% hi,0.0% si

Cpu1 : 0.0% us,100.0% id,0.0% si

Cpu2 : 100.0% us,0.0% si

Cpu3 : 100.0% us,0.0% si

Mem: 8165004k total,8095880k used,69124k free,53672k buffers

Swap: 2031608k total,103548k used,1928060k free,6801364k cached使用方法很简单,参数3表示消耗3颗CPU的资源,运行后,会有一堆 kill 命令,方便 kill 进程。

交互式脚本改进:

#! /bin/sh

# filename killcpu.sh

if [ $# != 1 ] ; then

echo "USAGE: $0 <CPUs>"

exit 1;

fi

for i in `seq $1`

do

echo -ne "

i=0;

while true

do

i=i+1;

done" | /bin/sh &

pid_array[$i]=$! ;

done

for i in "${pid_array[@]}"; do

echo 'kill ' $i ';';

done10、消耗内存脚本

方法一:

占用1GB内存1个小时. 注意需要可以mount的权限:

#!/bin/bash

mkdir /tmp/memory

mount -t tmpfs -o size=1024M tmpfs /tmp/memory

dd if=/dev/zero of=/tmp/memory/block

sleep 3600

rm /tmp/memory/block

umount /tmp/memory

rmdir /tmp/memory方法二:

备份大数据:

#!/bin/bash

################################################################

# mem used script

# eg. ./mem.sh 60G & to start testing

# eg. ./mem.sh stop to stop testing and clear env

# update: 2019-1-22 pansaky

################################################################

num=$1

user=`root`

start()

{

if [ -d /tmp/memory ];then

echo "the dir "/tmp/memory" is already exist!,use it." >> mem.log

else

sudo mkdir /tmp/memory

mount -t tmpfs -o size=$num tmpfs /tmp/memory

fi

dd if=/dev/zero of=/tmp/memory/block >> mem.log 2>&1

}

stop()

{

rm -rf /tmp/memory/block

umount /tmp/memory

rmdir /tmp/memory

if [ -d /tmp/memory ];then

echo "Do not remove the dir \"/tmp/memory\",please check "

else

echo "clear env is done!"

fi

}

main()

{

if [ $num == 'stop' ];then

stop

elif [ $user != "root" ];then

echo "please use the \"root\" excute script!"

exit 1

else

start

fi

}

if [ $# = 2 -o $# = 1 ];then

main

else

echo 'Usage: <./mem.sh 60G &> to start or <./mem.sh stop> to clear env'

fi说明:

1: mkdir -p

创建多级目录

2: mount -t tmpfs -o size

t 表示类型,也就是挂载文件系统的类型,表面你是挂载tmpfs文件系统;

O 表示选项: 选项里的size=10240M表示10G.挂载10G到/tmp/skyfans/memory

3: dd if=/dev/zero of=/tmp/memory/block

表示将/dev/zero 全盘数据备份到指定路径的block文件

dd:用指定大小的块拷贝一个文件,并在拷贝的同时进行指定的转换。

注意:指定数字的地方若以下列字符结尾,则乘以相应的数字:b=512;c=1;k=1024;w=2

if=文件名,输入文件名,缺省为标准输入。即指定源文件。< if=input file >

of=文件名:输出文件名,缺省为标准输出。即指定目的文件。< of=output file >

4:umount /tmp/memory

卸载挂载点

5:rmdir /tmp/memory

删除多级目录脚本执行:

./mem_test.sh 3G &内存测试,每间隔10秒采集一次,共计采集10次:

方法三:

c脚本消耗内存

1)在your_directory目录下,创建文件eatmem.c ,输入以下内容:

#include <unistd.h>

#include <errno.h>

#include <stdlib.h>

#include <stdio.h>

#include <string.h>

// Destription : release memory

// 1.parameters# gcc test_eatMem.c -o test_eatMem

// 2.parameters# ./test_eatMem

// Date : 2015-1-12

#define block 4 // eat times 4 block=1G

void eatMem()

{

int i =0; int j = 0;

int cell = 256 * 1024 * 1024; //256M

char * pMem[block]={0}; // init all pointer to NULL.

for(i = 0; i < block; i++)

{

pMem[i] = (char*)malloc(cell); // eat...

if(NULL == pMem[i]) // failed to eat.

{

printf("Insufficient memory avalible,Cell %d Failure\n",i);

break;

}

memset(pMem[i],cell);

printf("[%d]%d Bytes.\n",i,cell);

fflush(stdout);

sleep(1);

}

//Read&Write 10 次,维持内存消耗的时间 可自己设置

int nTimes = 0;

for(nTimes = 0; nTimes < 10; nTimes++)

{

for(i=0; i<block; i++)

{

printf("Read&Write [%d] cell.\n",i);

if(NULL == pMem[i])

{

continue;

}

char ch=0;

int j=0;

for(j=0; j<cell; j+=1024)

{

ch = pMem[i][j];

pMem[i][j] = 'a';

}

memset(pMem[i],cell);

fflush(stdout);

sleep(5);

}

sleep(5);

}

printf("Done! Start to release memory.\n");

//释放内存核心代码:

for(i = 0; i < block; i++)

{

printf("free[%d]\n",i);

if(NULL != pMem[i])

{

free(pMem[i]);

pMem[i] = NULL;

}

fflush(stdout);

sleep(2);

}

printf("Operation successfully!\n");

fflush(stdout);

}

int main(int argc,char * args[])

{

eatMem();

}2)编译:

gcc eatmem.c -o eatmem3) 创建定时任务,每15分钟执行:crontab -e 输入:

*/15 * * * * /your_directory/eatmem >> /your_directory/memcron.log#include <stdlib.h>

#include <stdio.h>

#include <unistd.h>

#define UNIT (1024*1024)

int main(int argc,char *argv[])

{

long long i = 0;

int size = 0;

if (argc != 2) {

printf(" === argc must 2\n");

return 1;

}

size = strtoull(argv[1],NULL,10);

if (size == 0) {

printf(" argv[1]=%s not good\n",argv[1]);

return 1;

}

char *buff = (char *) malloc(size * UNIT);

if (buff)

printf(" we malloced %d Mb\n",size);

buff[0] = 1;

for (i = 1; i < (size * UNIT); i++) {

if (i%1024 == 0)

buff[i] = buff[i-1]/8;

else

buff[i] = i/2;

}

pause();

}使用:gcc mem.c -o mem.out 后使用./mem.out 100 & 消耗对应数字MB单位的内存,释放时杀掉对应进程即可。

11、编程实现cpu、内存、硬盘、jvm使用率动态获取

1)C语言实现

通过程序将cpu使用率、内存使用情况保存到文件中:

// test.cpp

#include <stdio.h>

#include <unistd.h>

#include <stdlib.h>

int main()

{

system("top -n 1 |grep Cpu | cut -d \",\" -f 1 | cut -d \":\" -f 2 >cpu.txt");

system("top -n 1 |grep Cpu | cut -d \",\" -f 2 >>cpu.txt");

system("top -n 1 |grep Mem | cut -d \",\" -f 1 | cut -d \":\" -f 2 >>cpu.txt");

system("top -n 1 |grep Mem | cut -d \",\" -f 2 >>cpu.txt");

return 0;

}编译、运行:

[root@localhost study]# g++ test.cpp

[root@localhost study]# ./a.out

[root@localhost study]# cat cpu.txt

2.1%us

1.5%sy

2066240k total

1619784k used脚本说明:

[root@localhost utx86]# top -n 1

top - 14:23:20 up 5:14,14 users,load average: 0.00,0.04,0.01

Tasks: 183 total,1 running,181 sleeping,1 stopped,0 zombie

Cpu(s): 1.8%us,1.4%sy,0.0%ni,95.8%id,0.7%wa,0.1%hi,0.2%si,0.0%st

Mem: 2066240k total,1507316k used,558924k free,190472k buffers

Swap: 2031608k total,88k used,2031520k free,1087184k cached

1、获取cpu占用情况

[root@localhost utx86]# top -n 1 |grep Cpu

Cpu(s): 1.9%us,1.3%sy,95.9%id,0.6%wa,0.0%st

解释:

1.9%us是用户占用cpu情况

1.3%sy,是系统占用cpu情况

得到具体列的值:

[root@localhost utx86]# top -n 1 |grep Cpu | cut -d "," -f 1 | cut -d ":" -f 2

1.9%us

[root@localhost utx86]# top -n 1 |grep Cpu | cut -d "," -f 2

1.3%sy

2、获得内存占用情况

[root@localhost utx86]# top -n 1 |grep Mem

Mem: 2066240k total,1515784k used,550456k free,195336k buffers

获得内存情况指定列:

[root@localhost c++_zp]# top -n 1 |grep Mem | cut -d "," -f 1 | cut -d ":" -f 2

2066240k total

[root@localhost c++_zp]# top -n 1 |grep Mem | cut -d "," -f 2

1585676k used使用ps查看进程的资源占用:

ps -aux

查看进程信息时,第三列就是CPU占用。

[root@localhost utx86]# ps -aux | grep my_process

Warning: bad syntax,perhaps a bogus '-'? See /usr/share/doc/procps-3.2.7/FAQ

root 14415 3.4 0.9 37436 20328 pts/12 SL+ 14:18 0:05 ./my_process

root 14464 0.0 0.0 3852 572 pts/3 S+ 14:20 0:00 grep my_process

每一列含义如下

USER PID %CPU %MEM VSZ RSS TTY STAT START TIME COMMAND

即my_process进程当前占用cpu 3.4%,内存0.9%2)Java实现

linux下cpu 内存 磁盘 jvm的使用监控:

import java.io.*;

public class TT {

/**

* 获取cpu使用情况

* @return

* @throws Exception

*/

public double getCpuUsage() throws Exception {

double cpuUsed = 0;

Runtime rt = Runtime.getRuntime();

Process p = rt.exec("top -b -n 1");// 调用系统的“top"命令

BufferedReader in = null;

try {

in = new BufferedReader(new InputStreamReader(p.getInputStream()));

String str = null;

String[] strArray = null;

while ((str = in.readLine()) != null) {

int m = 0;

if (str.indexOf(" R ") != -1) {// 只分析正在运行的进程,top进程本身除外 &&

strArray = str.split(" ");

for (String tmp : strArray) {

if (tmp.trim().length() == 0)

continue;

if (++m == 9) { // 第9列为CPU的使用百分比(RedHat

cpuUsed += Double.parseDouble(tmp);

}

}

}

}

} catch (Exception e) {

e.printStackTrace();

} finally {

in.close();

}

return cpuUsed;

}

/**

* 内存监控

* @return

* @throws Exception

*/

public double getMemUsage() throws Exception {

double menUsed = 0;

Runtime rt = Runtime.getRuntime();

Process p = rt.exec("top -b -n 1");// 调用系统的“top"命令

BufferedReader in = null;

try {

in = new BufferedReader(new InputStreamReader(p.getInputStream()));

String str = null;

String[] strArray = null;

while ((str = in.readLine()) != null) {

int m = 0;

if (str.indexOf(" R ") != -1) {// 只分析正在运行的进程,top进程本身除外 &&

//

// System.out.println("------------------3-----------------");

strArray = str.split(" ");

for (String tmp : strArray) {

if (tmp.trim().length() == 0)

continue;

if (++m == 10) { //第10列为mem的使用百分比(RedHat 9)

menUsed += Double.parseDouble(tmp);

}

}

}

}

} catch (Exception e) {

e.printStackTrace();

} finally {

in.close();

}

return menUsed;

}

/**

* 获取磁盘空间大小

*

* @return

* @throws Exception

*/

public double getDeskUsage() throws Exception {

double totalHD = 0;

double usedHD = 0;

Runtime rt = Runtime.getRuntime();

Process p = rt.exec("df -hl");//df -hl 查看硬盘空间

BufferedReader in = null;

try {

in = new BufferedReader(new InputStreamReader(p.getInputStream()));

String str = null;

String[] strArray = null;

int flag = 0;

while ((str = in.readLine()) != null) {

int m = 0;

//if (flag > 0) {

//flag++;

strArray = str.split(" ");

for (String tmp : strArray) {

if (tmp.trim().length() == 0)

continue;

++m;

//System.out.println("----tmp----" + tmp);

if (tmp.indexOf("G") != -1) {

if (m == 2) {

//System.out.println("---G----" + tmp);

if (!tmp.equals("") && !tmp.equals("0"))

totalHD += Double.parseDouble(tmp.substring(0,tmp.length() - 1)) * 1024;

}

if (m == 3) {

//System.out.println("---G----" + tmp);

if (!tmp.equals("none") && !tmp.equals("0"))

usedHD += Double.parseDouble(tmp.substring(0,tmp.length() - 1)) * 1024;

}

}

if (tmp.indexOf("M") != -1) {

if (m == 2) {

// System.out.println("---M---" + tmp);

if (!tmp.equals("") && !tmp.equals("0"))

totalHD += Double.parseDouble(tmp.substring(0,tmp.length() - 1));

}

if (m == 3) {

//System.out.println("---M---" + tmp);

if (!tmp.equals("none") && !tmp.equals("0"))

usedHD += Double.parseDouble(tmp.substring(

0,tmp.length() - 1));

// System.out.println("----3----" + usedHD);

}

}

}

// }

}

} catch (Exception e) {

e.printStackTrace();

} finally {

in.close();

}

return (usedHD / totalHD) * 100;

}

public static void main(String[] args) throws Exception {

TT cpu = new TT();

System.out.println("---------------cpu used:" + cpu.getCpuUsage() + "%");

System.out.println("---------------mem used:" + cpu.getMemUsage() + "%");

System.out.println("---------------HD used:" + cpu.getDeskUsage() + "%");

System.out.println("------------jvm监控----------------------");

Runtime lRuntime = Runtime.getRuntime();