前言

今天带大家采集一个二次元图片网站, 里面漂亮的小姐姐层出不穷,图片的数据量也是比较大的, 来一睹为快吧! !

开发环境介绍:

python 3.6pycharm

requests

parsel

os

爬虫案例数据采集一般步骤:

找数据对应的链接地址代码发送地址的请求数据解析<解析我们要的数据>数据保存(本地)干货主要有:

① 200 多本 Python 电子书(和经典的书籍)应该有② Python标准库资料(最全中文版)

③ 项目源码(四五十个有趣且可靠的练手项目及源码)

④ Python基础入门、爬虫、网络开发、大数据分析方面的视频(适合小白学习)

⑤ Python学习路线图(告别不入流的学习)

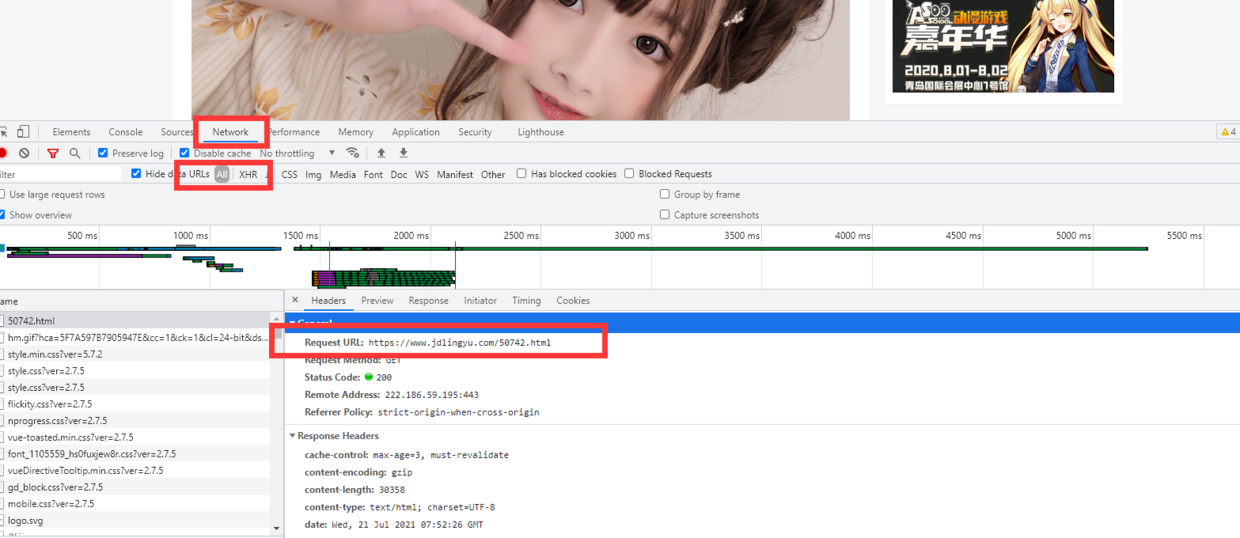

1. 首先第一步,找到对应的链接地址

因为是静态网页,所以数据很容易就找到了

# url编码: 中文在请求和响应的时候转码, http协议默认不支持中文, 由 % 字母 数字

request_address = f'https://www.jdlingyu.com/tag/%e5%b0%91%e5%a5%b3/page/{page}'

# 代表浏览器身份标识

headers = {'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

2. 代码发送地址的请求

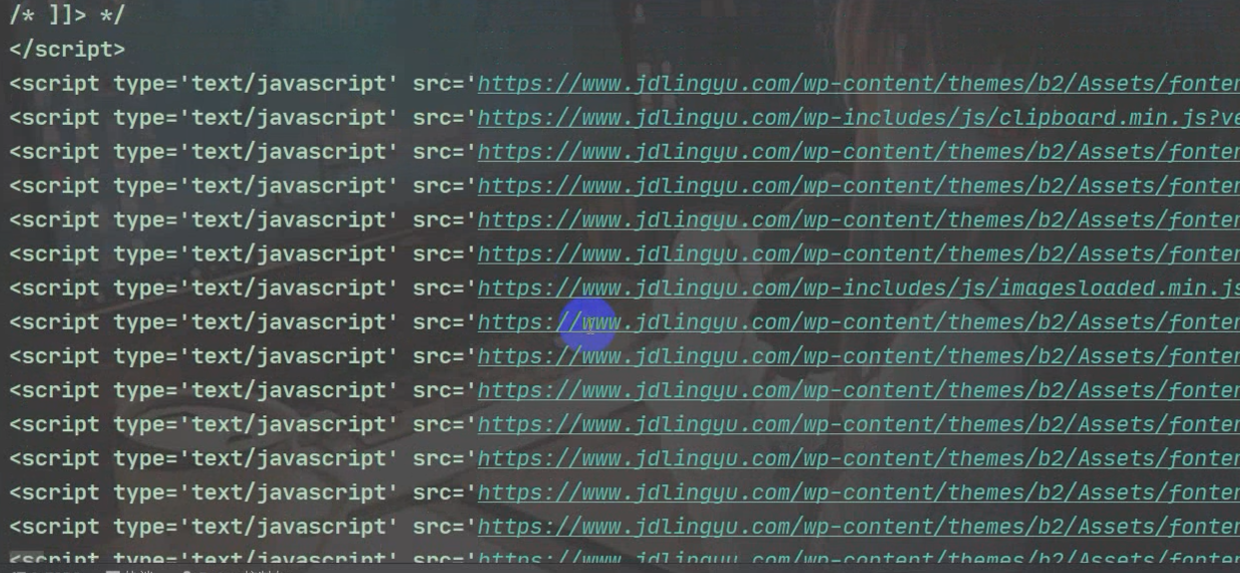

response = requests.get(url=request_address, headers=headers)html_data = response.text # 字符串 -- 正则

print(html_data)请求一下,看看对不对

3. 数据解析<解析我们要的数据> html数据, xpath

selector = parsel.Selector(html_data) # 转换数据类型lis = selector.xpath('//div[@id="post-list"]/ul/li') # 所有相册的标签

pic_title = li.xpath('.//h2/a/text()').get() # 相册标题

pic_href = li.xpath('.//h2/a/@href').get() # 相册地址

print(pic_title, pic_href)

4. 保存数据

with open(f'img{pic_title}{pic_name}', mode='wb') as f:f.write(img_data)

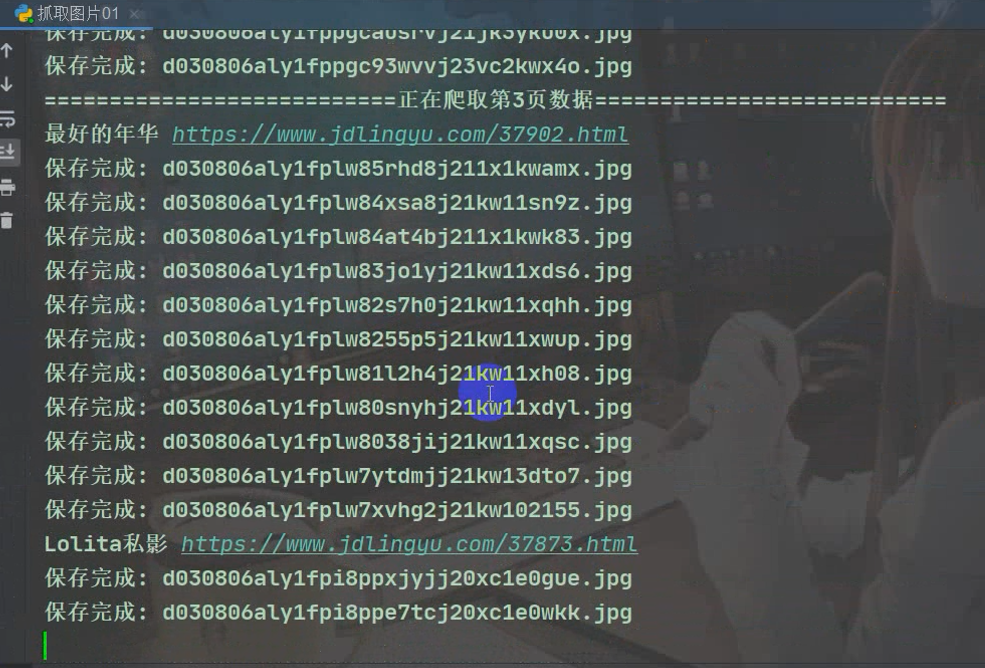

print('保存完成:', pic_name)

运行完整代码