我已经成功安装了NLTK for python(似乎是一个很棒的软件)。但是,我无法理解如何用来完成任务。

这是我的任务:

>我从一个长的数据开始(让他们从网络服务中说出关于英国选举的几百个推文)

>我想把它分解成句子(或信息不超过100个字符)(我想我可以在python中这样做)

>然后搜索该句子内的特定实例的所有句子。 “戴维·卡梅隆”

>然后我想检查每个句子中的正/负情绪,并相应计数

注意:我不太在乎准确性,因为我的数据集很大,也不用担心讽刺。

这是我遇到的麻烦:

>我可以找到的所有数据集NLTK附带的语料库电影审查数据不是webservice格式。看来这已经做了一些处理。据我看到,加工(由斯坦福德)是用WEKA完成的。 NLTK不可能自己做所有这些?这里所有的数据集已经被组织成正/负已经例如。极性数据集http://www.cs.cornell.edu/People/pabo/movie-review-data/怎么做? (通过情绪组织句子,肯定是WEKA还是别的?)

>我不知道我明白为什么WEKA和NLTK会一起使用。似乎他们做的事情也是一样的。如果用WEKA处理数据,首先要找出情绪,为什么需要NLTK?是否可以解释为什么这可能是必要的?

我发现几个脚本有点接近这个任务,但都使用相同的预处理数据。不能自己处理这些数据以发现句子中的情绪,而不是使用链接中给出的数据样本?

任何帮助是非常感激,将救我多头发!

干杯柯

解决方法

有关使用朴素贝叶斯进行情感分析与NLTK:http://streamhacker.com/2010/05/10/text-classification-sentiment-analysis-naive-bayes-classifier/的说明

然后在该代码中,而不是使用电影语料库,使用您自己的数据来计算字数(在word_feats方法中)。

Newtonsoft.JsonNewtonsoft.Json是.Net平台操作Json的工具...

Newtonsoft.JsonNewtonsoft.Json是.Net平台操作Json的工具... NLP(NaturalLanguageProcessing)自然语言处理是人工智能的一...

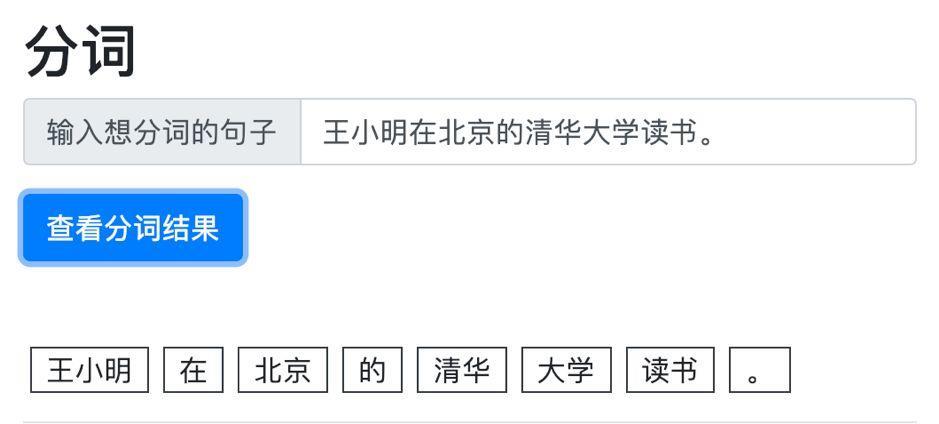

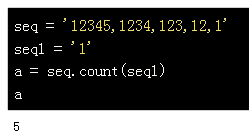

NLP(NaturalLanguageProcessing)自然语言处理是人工智能的一... 做一个中文文本分类任务,首先要做的是文本的预处理,对文本...

做一个中文文本分类任务,首先要做的是文本的预处理,对文本...