监督学习是从标注数据中学习模型的机器学习问题,是统计学习或机器学习的重要组成部分。赫尔伯特·西蒙(Herbert A. Simon)曾对“学习”给出以下定义:“如果一个系统能够通过执行某个过程改进它的性能,这就是学习。”按照这一观点,统计学习就是计算机系统通过运用数据及统计方法提高系统性能的机器学习。统计学习的方法是基于数据构建概率统计模型从而对数据进行预测与分析,一般包括监督学习、无监督学习、强化学习。

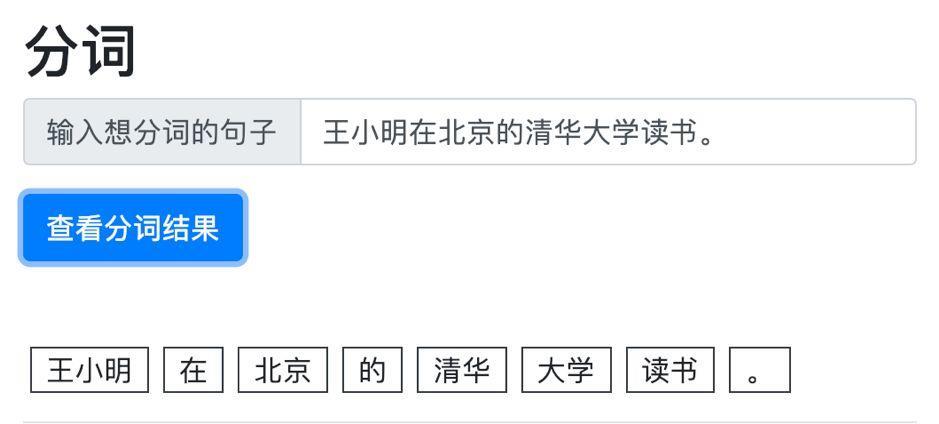

1、监督学习

监督学习(supervised learning)是指从标注数据中学习预测模型的机器学习问题。标注数据表示输入输出的对应关系,预测模型对给定的输入产生相应的输出。监督学习的本质是学习输入到输出的映射统计规律。

(1) 输入空间、特征空间与输出空间

在监督学习中,将输入与输出所有可能取值的集合分别称为输入空间(input space)与输出空间(output space)。输入与输出空间可以是有限元素的集合,也可以是整个欧式空间。输入空间与输出空间可以是同一空间,也可以是不同的空间;但通常输出空间远远小于输入空间。

每个具体的输入是一个实例(instance),通常由特征向量(feature vector)表示。这时,所有特征向量存在的空间称为特征空间(feature space)。特征空间的每一维对应于一个特征。有时假设输入空间与特征空间为相同的空间,对他们不予区分;有时假设输入空间与特征空间为不同的空间,将实例从输入空间映射到特征空间。模型实际上都是定义在特征空间上的。

在监督学习过程中,将输入与输出看作是定义在输入空间与输出空间上的随机变量的取值。输入、输出变量用大写字母表示,输入变量写作X,输出变量写作Y。输入、输出变量所取得值用小写字母表示,输入变量的取值写作x,输出变量的取值写作y。变量可以是标量或者变量,输出实例x的特征向量记作

x = (x(1),x(2),···,x(i),···,x(n))T

x(i)表示x的第i个特征。xi表示多个输入变量中的第i个变量,即

xi = (xi(1),xi(1),···,xi(1))T

监督学习从训练数据(training data)集合中学习模型,对测试数据(test data)进行预测。训练数据由输入与输出对组成,训练集通常表示为:

T = {(x1,y1),(x2,y2),···,(xN,yN)}

测试数据也由输入与输出对组成。输入与输出对又称为样本(sample)或样本点。

(2)联合概率分布

监督学习假设输入与输出的随机变量X和Y遵循联合概率分布P(X,Y)。P(X,Y)表示分布函数,或分布密度函数。训练数据与测试数据被看作是依联合概率分布P(X,Y)独立同分布产生的。统计学习假设数据存在一定的统计规律,X和Y具有联合概率分布的假设就是监督学习关于数据的基本假设。

(3) 假设空间

监督学习的目的在于学习一个由输入到输出的映射,这一映射由模型来表示。换句话说,学习的目的就在于找到最好的这样的模型。模型属于由输入空间到输出空间的映射的集合,这个集合就是假设空间(hypothesis space)。假设空间的确定意味着学习范围的确定。

监督学习的模型可以是概率模型或非概率模型,由条件概率分布P(X|Y)或决策函数(decision function) Y=f(X)表示,随具体学习方法而定。对具体的输入进行相应的输出预测时,写作P(y|x)或y=f(x)。

(4)问题的形式化

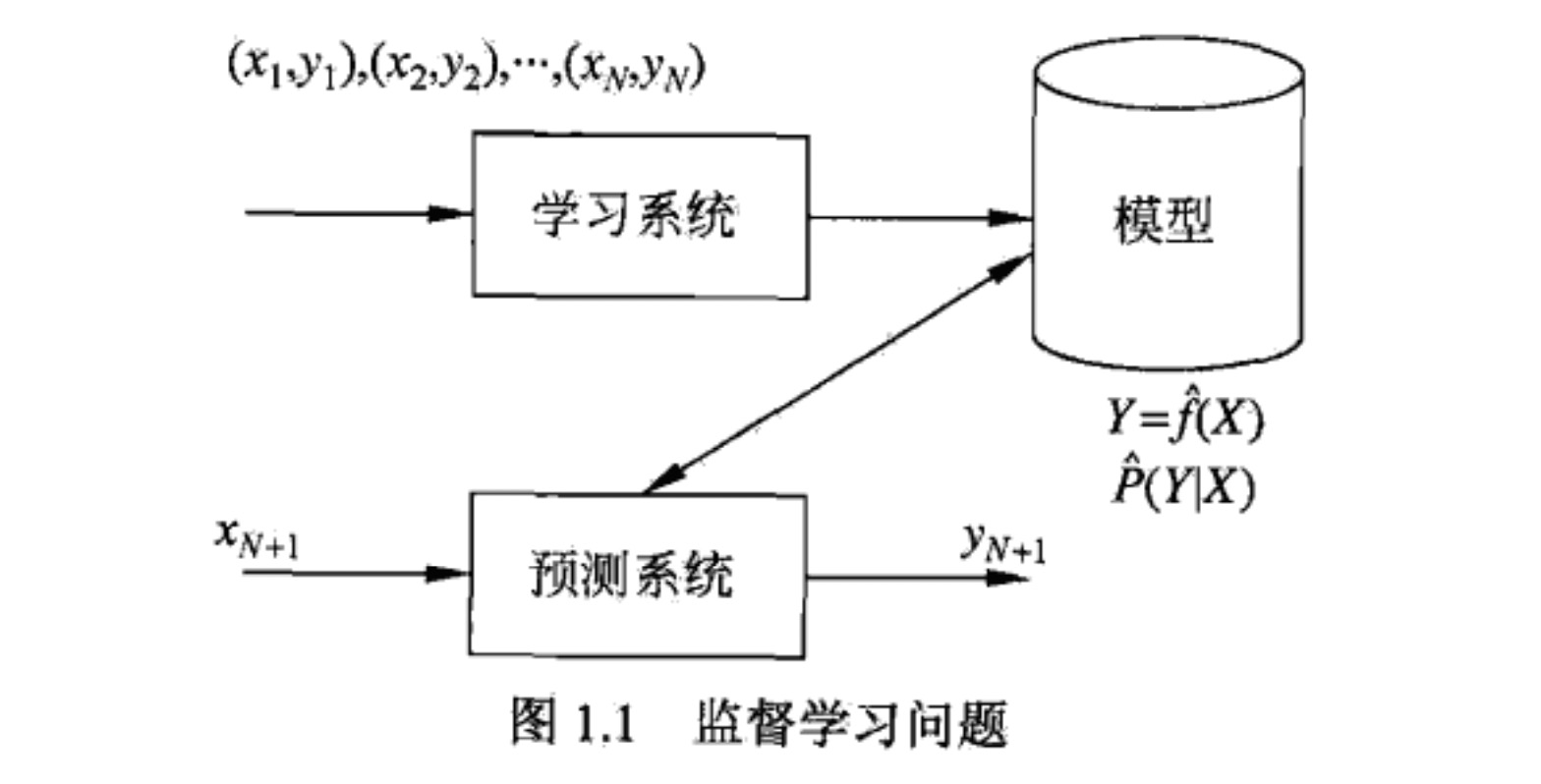

监督学习利用训练数据集学习一个模型,再用模型对测试样本集进行预测(prediction)。由于在这个过程中需要训练数据集,而训练数据集往往是人工给出的,所以称为监督学习。监督学习分为学习和预测两个过程,由学习系统与预测系统完成,可用图1.1来描述。

监督学习中,假设训练数据与测试数据是依联合概率分布P(X,Y)独立分布产生的。

在学习过程中,学习系统利用给定的训练数据集,通过学习(或训练)得到一个模型,表示为条件概率分布$\widehat{P}(Y|X)$。条件概率分布$\widehat{P}(Y|X)$描述输入与输出随机变量之间的映射关系。在预测过程中,预测系统对于给定的测试样本集中的输入xN+1,由模型$^y{_{N+1}}=\widehat{f}(x_{_{N+1}})$给出相应的输出yn+1。

学习系统(也就是学习算法)试图通过训练数据集中的样本(xi,yi)带来的信息学习模型。具体得说,对输入xi,一个具体的模型y=f(x)可以产生一个输出f(xi),而训练数据集中对应的输出是yi,如果这个模型有很好的预测能力,训练样本输出yi和模型输出f(xi)之间的差就应该足够小。学习系统通过不断的尝试,选取最好的模型,以便对训练数据集有足够好的预测,同时对未知的测试数据集的预测也有尽可能好的推广。

2、无监督学习

无监督学习(unsupervised learning)是指从无标注数据中学习预测模型的机器学习问题。无标注数据是自然得到的数据,预测模型表示数据的类别、转换或概率。无监督学习的本质是学习数据中的统计规律或潜在结构。

无监督学习旨在从假设空间中选出在给定评价标准下的最优模型。无监督学习通过使用大量的无标注数据学习或训练,每一个样本是一个实例。训练数据表示为U = {x1,x2,···,xN},其中xi,i=1,2,···,N,是样本。无监督学习可以用于对已有数据的分析,也可以用于对未来数据的预测,分别由学习系统与分析系统完成,如图1.2所示。在学习过程中,学习系统从训练数据集学习,得到一个最优模型,表示为函数$z=\widehat{g}(x)$,条件概率分布$\widehat{P}(z|x)$或者条件概率分布$\widehat{P}(x|z)$。在预测过程中,预测系统对于给定的输入xN+1,由模型$z_{N+1}=\widehat{g}(x_{N+1})$给出相应的输出zN+1,进行聚类或降纬,或者由模型$\widehat{P}(x|z)$给出输入的概率$\widehat{P}(x_{N+1}|z_{N+1})$,进行概率估计。

3、强化学习

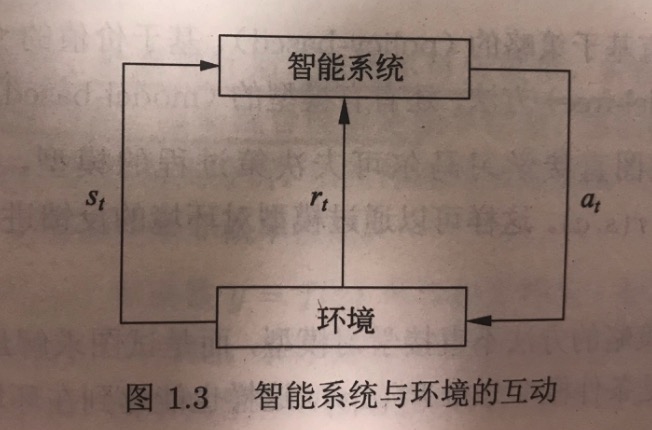

强化学习(reinforcement learning)是指智能系统在与环境的连续互动中学习最优行为策略的机器学习问题。假设智能系统与环境的互动基于马尔科夫决策过程(Markov decision process),智能系统能观测到的是与环境互动得到的数据序列。强化学习的本质是学习最优的序贯决策。

智能系统与环境的互动如图1.3所示。在每一步t,智能系统从环境中观测到一个状态(state)st与一个奖励(reward)rt,采取一个动作(action)at。环境根据职能系统选择的动作,决定下一步t+1的状态st+1与奖励rt+1。要学习的策略表示为给定的状态下采取的动作。智能系统的目标不是短期奖励的最大化,而是长期积累奖励的最大化。强化学习过程中,系统不断试错(trail and error),已达到学习最优策略的目的。

鸣谢