隐马尔可夫模型(Hidden Markov Model,HMM)是可用于标注问题的统计学习模型,描述由隐藏的马尔可夫链随机生成观测序列的过程,属于生成模型。HMM在语音识别、自然语言处理、生物信息、模式识别等领域都有着广泛的应用。

一、 HMM模型的定义

HMM模型是关于时序的概率模型,描述由一个隐藏的马尔可夫链随机生成不可观测的状态随机序列,再由各个状态生成一个观测而产生观测随机序列的过程。隐藏的马尔可夫链随机生成的状态的序列称为状态序列(state sequence);每个状态生成一个观测,再由此产生的观测的随机序列,称为观测序列(observation sequence。序列的每一个位置可以看作是一个时刻。

HMM模型由初始概率分布、状态转移概率分布、观测概率分布确定。设$Q$是所有可能的状态的集合,$V$是所有可能的观测的集合,即:

$Q=\left\{q_{1},q_{2},\cdots,q_{N}\right\},\quad V=\left\{v_{1},v_{2},v_{M}\right\}$

其中,$N$是可能的状态数,$M$是可能的观测数。记$I$是长度为$T$的状态序列,$O$是对应的观测序列,即:

$I=\left(i_{1},i_{2},i_{T}\right),\quad O=\left(o_{1},o_{2},o_{T}\right)$

Newtonsoft.JsonNewtonsoft.Json是.Net平台操作Json的工具...

Newtonsoft.JsonNewtonsoft.Json是.Net平台操作Json的工具... NLP(NaturalLanguageProcessing)自然语言处理是人工智能的一...

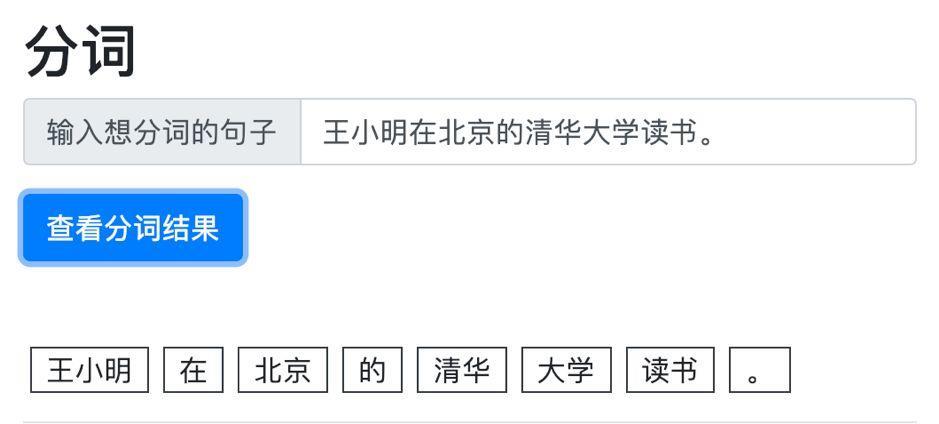

NLP(NaturalLanguageProcessing)自然语言处理是人工智能的一... 做一个中文文本分类任务,首先要做的是文本的预处理,对文本...

做一个中文文本分类任务,首先要做的是文本的预处理,对文本...