memcachedb使用的BerkeleyDB的数据库,但每10M生成一个log文件:

[root@aslibra db]# ll -h

total 26G

-rw-r--r-- 1 root root 25G Jun 22 00:12 data.db

-rw-r----- 1 root root 24K Jun 20 19:33 __db.001

-rw-r----- 1 root root 3.8M Jun 20 19:33 __db.002

-rw-r----- 1 root root 81M Jun 20 19:33 __db.003

-rw-r----- 1 root root 96K Jun 20 19:33 __db.004

-rw-r----- 1 root root 11M Jun 20 19:33 __db.005

-rw-r----- 1 root root 48K Jun 20 19:33 __db.006

-rw-r----- 1 root root 10M Jun 21 22:47 log.0000002271

-rw-r----- 1 root root 10M Jun 21 22:47 log.0000002272

-rw-r----- 1 root root 10M Jun 21 22:48 log.0000002273

-rw-r----- 1 root root 10M Jun 21 22:49 log.0000002274

.....

total 26G

-rw-r--r-- 1 root root 25G Jun 22 00:12 data.db

-rw-r----- 1 root root 24K Jun 20 19:33 __db.001

-rw-r----- 1 root root 3.8M Jun 20 19:33 __db.002

-rw-r----- 1 root root 81M Jun 20 19:33 __db.003

-rw-r----- 1 root root 96K Jun 20 19:33 __db.004

-rw-r----- 1 root root 11M Jun 20 19:33 __db.005

-rw-r----- 1 root root 48K Jun 20 19:33 __db.006

-rw-r----- 1 root root 10M Jun 21 22:47 log.0000002271

-rw-r----- 1 root root 10M Jun 21 22:47 log.0000002272

-rw-r----- 1 root root 10M Jun 21 22:48 log.0000002273

-rw-r----- 1 root root 10M Jun 21 22:49 log.0000002274

.....

定期清理为好,否则就要有两倍数据的空间了,以前写的是定期清理某个时间修改的日志:

find /BerkeleyDB/aslibra.com/db/ -maxdepth 1 -type f -name 'log.*' -mmin +100 | xargs -i rm -f {}

清理100分钟前的文件,导致了一个文件,如果停用或者100分钟内没有更新动作,将删掉了所有日志,吃亏了,导致启动失败了,当然,可能可以修复,只是糊涂的话就没法再启用了。

稳当点,就删除所有的日志文件,保留最新的100个:

#!/bin/sh

cd /BerkeleyDB/aslibra.com/db/

ls -t log.* | awk '{ if(NR>100)print $0}'|xargs -i -t rm -f {}

cd /BerkeleyDB/aslibra.com/db/

ls -t log.* | awk '{ if(NR>100)print $0}'|xargs -i -t rm -f {}

简单解析一下脚本意思:

ls -t log.* 是列出所有log开头的日志文件,按时间排序,也就是最新的排前面

awk里面NR代表当前行数,NR>100则是100行后的才输出

xargs就是接收到awk输出的文件才转给rm删除

参考资料:awk手册

原文:http://www.aslibra.com/blog/post/memcachedb_clear_log_awk.php

文章浏览阅读3.7k次,点赞2次,收藏5次。Nginx学习笔记一、N...

文章浏览阅读3.7k次,点赞2次,收藏5次。Nginx学习笔记一、N... 文章浏览阅读1.7w次,点赞14次,收藏61次。我们在使用容器的...

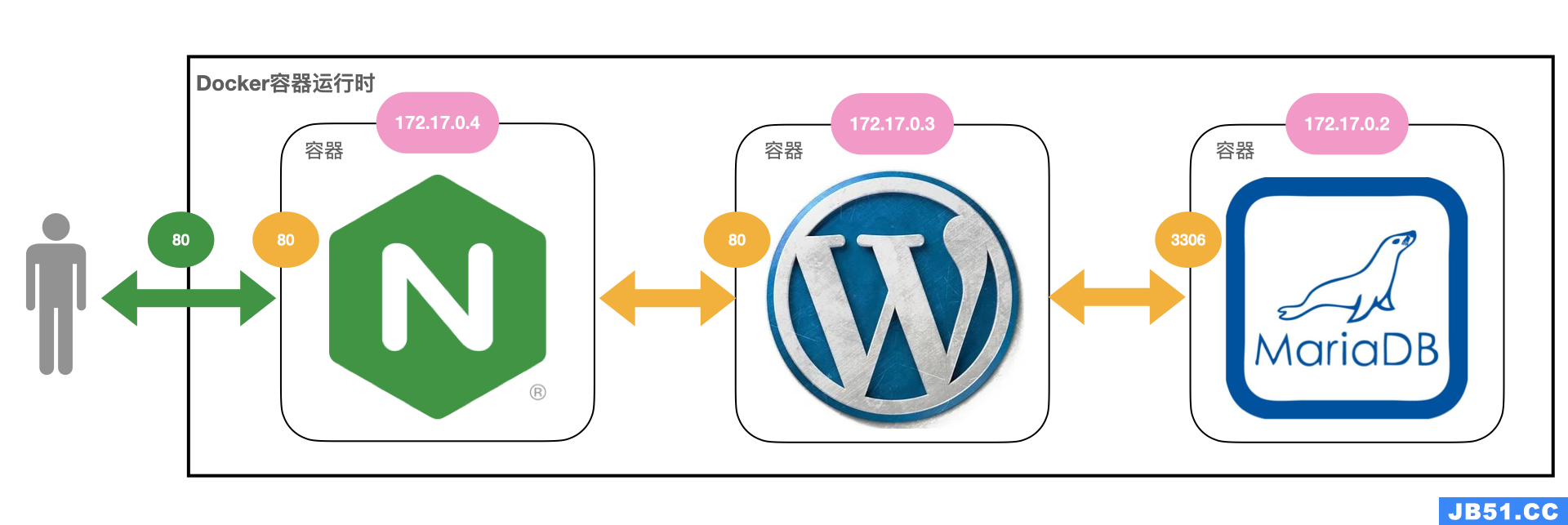

文章浏览阅读1.7w次,点赞14次,收藏61次。我们在使用容器的... 文章浏览阅读2.7k次。docker 和 docker-compose 部署 nginx+...

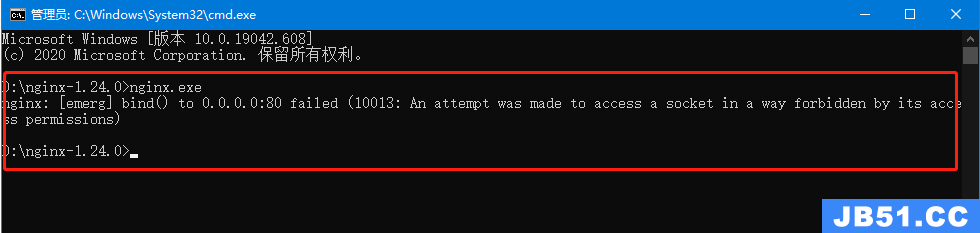

文章浏览阅读2.7k次。docker 和 docker-compose 部署 nginx+... 文章浏览阅读1.3k次。5:再次启动nginx,可以正常启动,可以...

文章浏览阅读1.3k次。5:再次启动nginx,可以正常启动,可以... 文章浏览阅读3.1w次,点赞105次,收藏182次。高性能:Nginx ...

文章浏览阅读3.1w次,点赞105次,收藏182次。高性能:Nginx ...