我有大量的相对论小数据文件,但它们占用大约50 GB,我需要将它们转移到另一台机器上.我试图想出最有效的方法来做到这一点.

我的想法是gzip整个事情然后rsync和解压缩,依赖rsync -z进行压缩,gzip然后使用rsync -z.我不确定哪个最有效,因为我不确定rsync -z是如何实现的.关于哪个选项最快的任何想法?

解决方法

你不能“gzip整个事情”,因为gzip只压缩一个文件,你可以创建一个tar文件并将其gzip为“gzip整个东西”但你会松开复制仅修改文件的rsync功能.

所以问题是:存储文件需要rsync gziped还是依赖rsync的-z选项更好.

答案可能是您不希望文件在服务器上解压缩?我想是的,所以我没有看到你在做rsync之前如何设法gzip文件.

可能是您不需要复制仅修改文件的rsync功能?在这种情况下,为什么使用rsync而不是做包含你的东西的tar.gz文件的scp?

无论如何回答这个问题,rsync gzip的效率会比使用gzip的gziping文件低一点.为什么?因为rsync会按块来gzip数据块,所以一小部分数据将用于创建gzip用来进行压缩的表,一组更大的数据(gzip会立即使用整个文件)给出更好的压缩表.但在大多数情况下,差异将非常小,但在非常罕见的情况下差异可能更重要(如果你有一个非常大的文件,非常长的partern在文件上重复很多时间但彼此相距很远)(这是一个非常简单的例子)

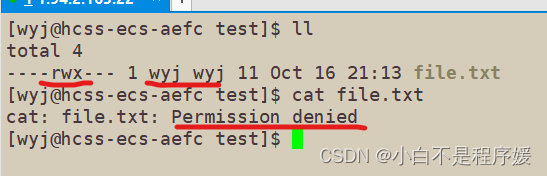

文章浏览阅读1.8k次,点赞63次,收藏54次。Linux下的目录权限...

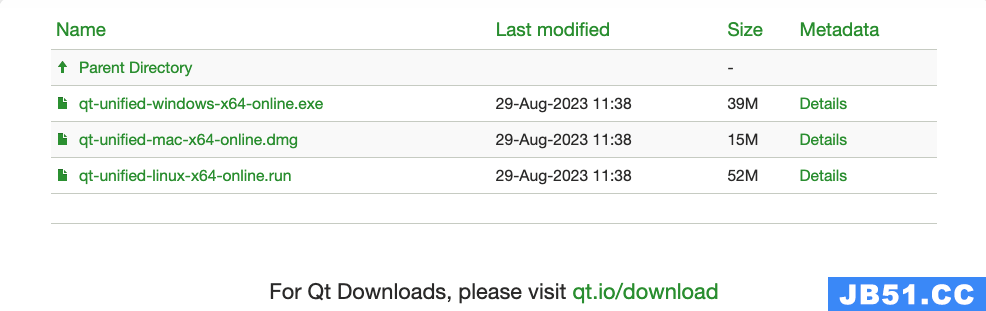

文章浏览阅读1.8k次,点赞63次,收藏54次。Linux下的目录权限... 文章浏览阅读1.6k次,点赞44次,收藏38次。关于Qt的安装、Wi...

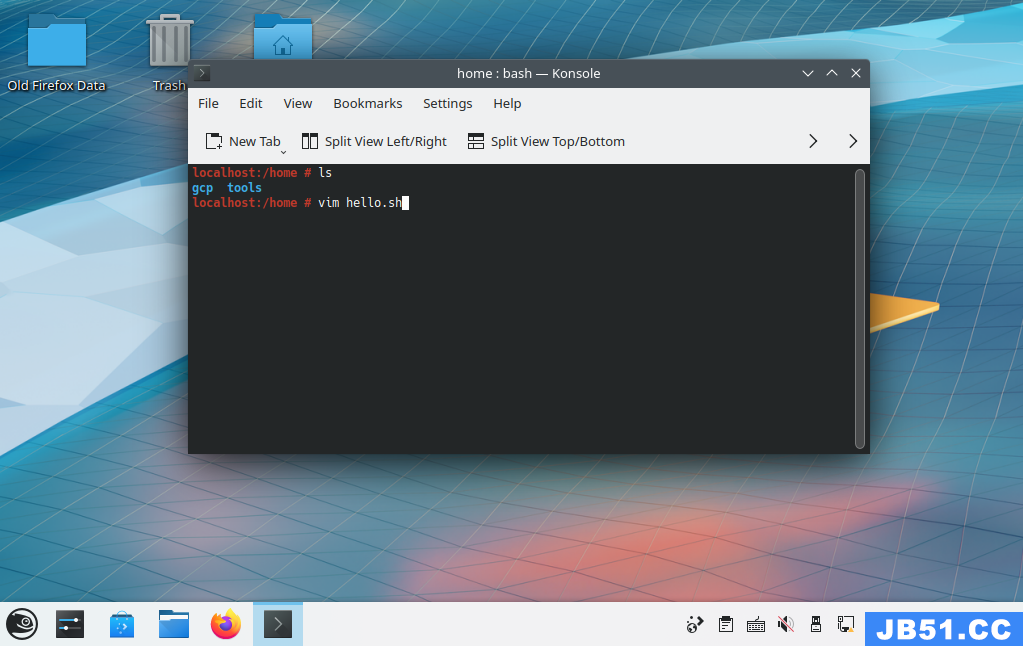

文章浏览阅读1.6k次,点赞44次,收藏38次。关于Qt的安装、Wi... 本文介绍了使用shell脚本编写一个 Hello

本文介绍了使用shell脚本编写一个 Hello 文章浏览阅读1.5k次,点赞37次,收藏43次。【Linux】初识Lin...

文章浏览阅读1.5k次,点赞37次,收藏43次。【Linux】初识Lin... 文章浏览阅读3k次,点赞34次,收藏156次。Linux超详细笔记,...

文章浏览阅读3k次,点赞34次,收藏156次。Linux超详细笔记,... 文章浏览阅读6.8k次,点赞109次,收藏114次。【Linux】 Open...

文章浏览阅读6.8k次,点赞109次,收藏114次。【Linux】 Open...