我写了一个在我的每个docker容器中运行的golang应用程序.它通过tcp和udp使用protobufs相互通信,我使用Hashicorp的成员列表库来发现我网络中的每个容器.

在docker stats上我看到内存使用量呈线性增长,所以我试图在我的应用程序中找到任何泄漏.

由于它是一个持续运行的应用程序,我使用http pprof来检查任何一个容器中的实时应用程序.

我看到即使docker stats线性增加,runtime.MemStats.sys也是常量.

我的–inuse_space大约是1MB而且–alloc_space ofcourse随着时间的推移不断增加.以下是alloc_space的示例:

root@n3:/app# go tool pprof --alloc_space main http://localhost:8080/debug/pprof/heap

Fetching profile from http://localhost:8080/debug/pprof/heap

Saved profile in /root/pprof/pprof.main.localhost:8080.alloc_objects.alloc_space.005.pb.gz

Entering interactive mode (type "help" for commands)

(pprof) top --cum

1024.11kB of 10298.19kB total ( 9.94%)

Dropped 8 nodes (cum <= 51.49kB)

Showing top 10 nodes out of 34 (cum >= 1536.07kB)

flat flat% sum% cum cum%

0 0% 0% 10298.19kB 100% runtime.goexit

0 0% 0% 6144.48kB 59.67% main.Listener

0 0% 0% 3072.20kB 29.83% github.com/golang/protobuf/proto.Unmarshal

512.10kB 4.97% 4.97% 3072.20kB 29.83% github.com/golang/protobuf/proto.UnmarshalMerge

0 0% 4.97% 2560.17kB 24.86% github.com/hashicorp/memberlist.(*Memberlist).triggerFunc

0 0% 4.97% 2560.10kB 24.86% github.com/golang/protobuf/proto.(*Buffer).Unmarshal

0 0% 4.97% 2560.10kB 24.86% github.com/golang/protobuf/proto.(*Buffer).dec_struct_message

0 0% 4.97% 2560.10kB 24.86% github.com/golang/protobuf/proto.(*Buffer).unmarshalType

512.01kB 4.97% 9.94% 2048.23kB 19.89% main.SaveAsFile

0 0% 9.94% 1536.07kB 14.92% reflect.New

(pprof) list main.Listener

Total: 10.06MB

ROUTINE ======================== main.Listener in /app/listener.go

0 6MB (flat,cum) 59.67% of Total

. . 24: l.SetReadBuffer(MaxDatagramSize)

. . 25: defer l.Close()

. . 26: m := new(NewMsg)

. . 27: b := make([]byte,MaxDatagramSize)

. . 28: for {

. 512.02kB 29: n,src,err := l.ReadFromUDP(b)

. . 30: if err != nil {

. . 31: log.Fatal("ReadFromUDP failed:",err)

. . 32: }

. 512.02kB 33: log.Println(n,"bytes read from",src)

. . 34: //TODO remove later. For testing Fetcher only

. . 35: if rand.Intn(100) < MCastDropPercent {

. . 36: continue

. . 37: }

. 3MB 38: err = proto.Unmarshal(b[:n],m)

. . 39: if err != nil {

. . 40: log.Fatal("protobuf Unmarshal failed",err)

. . 41: }

. . 42: id := m.GetHead().GetMsgId()

. . 43: log.Println("CONFIG-UPDATE-RECEIVED { \"update_id\" =",id,"}")

. . 44: //TODO check whether value already exists in store?

. . 45: store.Add(id)

. 2MB 46: SaveAsFile(id,b[:n],StoreDir)

. . 47: m.Reset()

. . 48: }

. . 49:}

(pprof)

我已经能够使用http://:8080 / debug / pprof / goroutine验证没有发生goroutine泄漏?debug = 1

请评论为什么docker stats显示不同的图片(线性增加内存)

CONTAINER CPU % MEM USAGE / LIMIT MEM % NET I/O BLOCK I/O PIDS

n3 0.13% 19.73 MiB / 31.36 GiB 0.06% 595 kB / 806 B 0 B / 73.73 kB 14

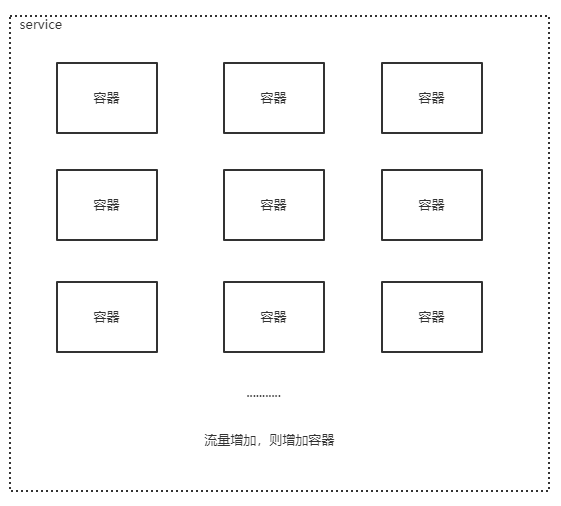

如果我运行它过夜,这个内存膨胀到250MB左右.我没有比这更长时间运行,但我觉得这应该达到一个平台,而不是线性增加

如果您阅读“过时但有用”的文档(https://www.kernel.org/doc/Documentation/cgroup-v1/memory.txt),它说

5.5 usage_in_bytes

For efficiency,as other kernel components,memory cgroup uses some

optimization to avoid unnecessary cacheline false sharing.

usage_in_bytes is affected by the method and doesn’t show ‘exact’

value of memory (and swap) usage,it’s a fuzz value for efficient

access. (Of course,when necessary,it’s synchronized.) If you want to

know more exact memory usage,you should use RSS+CACHE(+SWAP) value in

memory.stat(see 5.2).

页面缓存和RES包含在内存usage_in_bytes编号中.因此,如果容器具有文件I / O,则内存使用情况统计信息将增加.但是,对于容器,如果使用量达到最大限制,则它会回收一些未使用的内存.因此,当我向容器添加内存限制时,我可以观察到内存被回收并在达到限制时使用.除非没有内存要回收并且发生OOM错误,否则不会杀死容器进程.对于任何关注docker stats中显示的数字的人来说,最简单的方法是检查路径中cgroups中可用的详细统计信息:/ sys / fs / cgroup / memory / docker //

这将在memory.stats或其他内存.*文件中详细显示所有内存指标.

如果要在“docker run”命令中限制docker容器使用的资源,可以按照以下引用进行操作:https://docs.docker.com/engine/admin/resource_constraints/

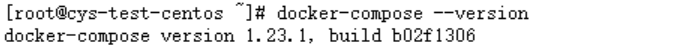

由于我使用的是docker-compose,我是通过在我想要限制的服务下的docker-compose.yml文件中添加一行来完成的:

mem_limit: 32m

其中m代表兆字节.

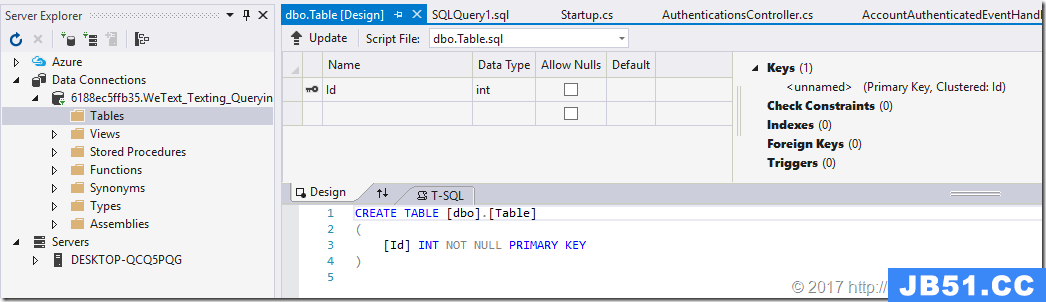

最近一直在开发Apworks框架的案例代码,同时也在一起修复Apw...

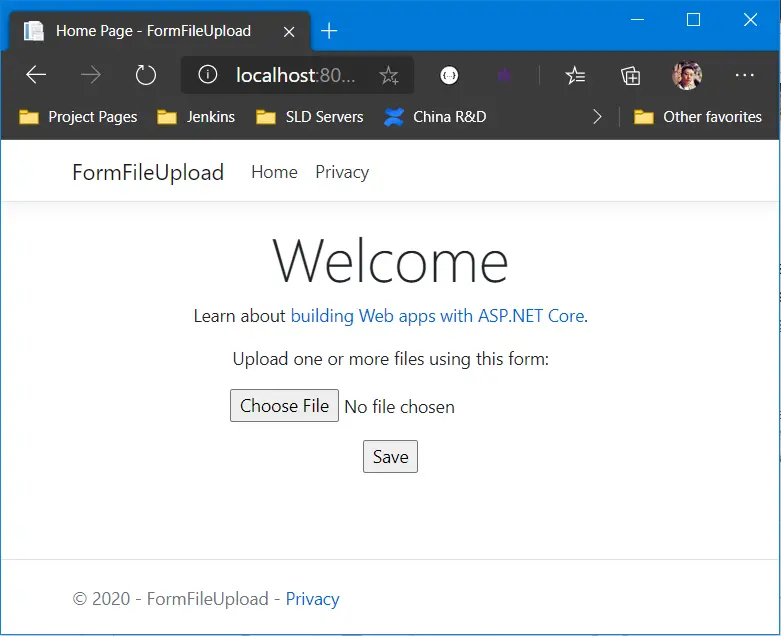

最近一直在开发Apworks框架的案例代码,同时也在一起修复Apw... 最近每天都在空闲时间努力编写Apworks框架的案例代码WeText。...

最近每天都在空闲时间努力编写Apworks框架的案例代码WeText。... 在《Kubernetes中分布式存储Rook-Ceph部署快速演练》文章中,...

在《Kubernetes中分布式存储Rook-Ceph部署快速演练》文章中,... CentOS下Docker与.netcore(一) 之 安装 CentOS下Docker与.ne...

CentOS下Docker与.netcore(一) 之 安装 CentOS下Docker与.ne... CentOS下Docker与.netcore(一) 之 安装 CentOS下Docker与.ne...

CentOS下Docker与.netcore(一) 之 安装 CentOS下Docker与.ne...