目 录

一、 第一部分:云计算 IV

- 什么是云计算? IV

- 云计算的服务类型 V

- 为什么要用云计算 V

- 云计算的基础KVM虚拟化 VI

- kvm管理平台 XVII

二、 第二部分 docker容器 XIX - 什么是容器 XIX

- 容器和虚拟机的区别 XIX

- docker-ce的安装 XX

- docker主要内容 XX

- docker镜像常用命令 XXI

- docker容器的常用命令 XXII

- docker端口映射 XXV

- docker数据卷 XXV

- 手动制作docker镜像 XXVI

- 自动制作docker镜像 XXIX

- docker镜像的分层(复用,节省空间) XXXII

- dockerfile的优化 XXXII

- 容器间的互联 XXXIII

- 单机版的容器编排 XXXIV

- 私有仓库docker-registry XXXVI

- 企业级私有仓库harbor(docker-compose) XXXVII

- docker基础网络 XLI

- 跨宿主机容器间的通讯之macvlan XLII

- 跨宿主机容器间的通讯之overlay XLIII

- docker容器的监控 XLIII

三、 第三部分:k8s LVI - k8s集群的安装 LVI

- 什么是k8s,k8s有什么功能? 5

- k8s常用的资源 9

- k8s的常用资源(二进制) 23

- k8s常用服务(二进制) 34

- k8s的网络访问(二进制) 48

- K8s的附加组件 63

- k8s弹性伸缩 70

8.1 使用heapster实现弹性伸缩 70 - 使用kubeadm初始化k8s集群 73

9.1 环境要求: 74

9.2 安装指定版本docker 74

9.3 安装kubeadm 74

9.4 使用kubeadm初始化k8s集群 75

9.5 给k8s集群加入node节点: 75

9.6 为k8s集群配置网络插件 75

9.7 为k8s集群配置dashboard服务 76

9.8 使用metric-server实现弹性伸缩 77 - 持久化存储 85

10.1 emptyDir: 85

10.2 HostPath:[不能跨宿主机做数据共享] 85

10.3 Nfs(网络文件共享) 86

10.4 pv和pvc: 86

10.5 分布式存储ceph 88 - 使用jenkins实现k8s持续更新 95

11.1 安装gitlab并上传代码 96

11.2 安装jenkins,并自动构建docker镜像 97 - k8s高可用 101

- 基于nfs实现动态存储(二进制) 104

- Helm k8s包管理工具 107

14.1 helm介绍: [部署应用变得更简单、高效] 107

14.2 helm安装 107

14.3 helm初始化 108

14.4 自定义helm 110 - statsfulset资源 116

- job资源和cron.job资源 117

- kubesphere管理平台 118

- 阿里云k8s 120

四、 第四部分:阿里云 122 - 云计算回顾 122

- 阿里云的发展历程: 123

- 阿里云的控制台 123

- ECS资源(弹性计算)-快照-镜像-云硬盘 123

一、 第一部分:云计算

-

什么是云计算?

云计算是一种按量付费的模式!云计算的底层是通过虚拟化技术来实现的! -

云计算的服务类型

IAAS 基础设施即服务(infrastructure as an service) 虚拟机 ecs云主机

PAAS 平台即服务(platform as an service ) PHP,java 容器

SAAS 软件即服务(software as an service ) 企业邮箱服务 cdn服务 rds数据库 -

为什么要用云计算

小公司:10台 20w+ idc 5w + 100M 10W, 10台云主机,前期投入小,扩展灵活,风险小

大公司:闲置服务器计算资源,虚拟机,出租(超卖)

64G 服务器 64台1G 320台1G 64台 大公司自己的业务 264台 租出去

国企,银行

公有云: 谁都可以租

私有云: 只有公司内部使用

混合云: 有自己的私有云 + 租的公有云 -

云计算的基础KVM虚拟化

宿主机:内存4G+ 纯净的系统CentOS-7(关闭selinux,firewalld和NetworkManager)

4.1 什么是虚拟化?

虚拟化,通过模拟计算机的硬件,来实现在同一台计算机上同时运行多个不同的操作系统的技术。

4.2 linux虚拟化软件的差别

linux虚拟化软件: qemu 软件纯模拟全虚拟化软件,特别慢!兼容性好! xen(半) 性能特别好,需要使用专门修改之后的内核,兼容性差! redhat 5.5 xen kvm KVM(linux) 全虚拟机,它有硬件支持cpu,内置在linux内核模块,而且不需要使用专门的内核 centos6 kvm 性能较好,兼容较好

vmware workstations: 图形界面

virtual Box: 图形界面 Oracle

4.3 安装kvm虚拟化管理工具

主机名 ip地址 内存 虚拟机

kvm01 10.0.0.11 4G(后期调整到2G) cpu开启vt虚拟化

kvm02 10.0.0.12 2G cpu开启vt虚拟化

yum install libvirt virt-install qemu-kvm -y

KVM:Kernel-based Virtual Machine

libvirt 作用:虚拟机的管理软件 libvirt: kvm,xen,qemu,lxc…

virt virt-install virt-clone 作用:虚拟机的安装工具和克隆工具 qemu-kvm qemu-img (qcow2,raw)作用:管理虚拟机的虚拟磁盘

环境要求:

centos 7.4 7.6 7.8(不要使用7.5)

vmware 宿主机 kvm虚拟机

内存4G,cpu开启虚拟化

IP:10.0.0.11

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

安装软件包

yum install libvirt virt-install qemu-kvm -y

4.4 安装一台kvm虚拟机

VNC-Viewer-6.19.325

微软的远程桌面

vnc:远程的桌面管理工具 向日葵 微软的远程桌面

systemctl start libvirtd.service systemctl status libvirtd.service

10.0.0.11 宿主机

建议虚拟机内存不要低于1024M,否则安装系统特别慢!

virt-install --virt-type kvm --os-type=linux --os-variant rhel7 --name centos7 --memory 1024 --vcpus 1 --disk /opt/centos2.raw,format=raw,size=10 --cdrom /opt/CentOS-7-x86_64-DVD-1708.iso --network network=default --graphics vnc,listen=0.0.0.0 --noautoconsole

vnc:10.0.0.11:5900

–virt-type kvm 虚拟化的类型(qemu) --os-type=linux 系统类型 --os-variant rhel7 系统版本 --name centos7 虚拟机的名字 (必须唯一) --memory 1024 虚拟机的内存 --vcpus 1 虚拟cpu的核数 --disk /opt/centos2.raw,format=raw,size=10(必须唯一) --cdrom /opt/CentOS-7-x86_64-DVD-1708.iso --network network=default 使用默认NAT的网络 --graphics vnc,listen=0.0.0.0 --noautoconsole (可有可无)

云主机都没有swap分区

4.5 kvm虚拟机的virsh日常管理和配置

列表list(–all) 开机start 关机shutdown(虚拟机有系统) 拔电源关机destroy 重启reboot(虚拟机有系统)

导出配置dumpxml 例子:virsh dumpxml centos7 >centos7-off.xml 删除undefine 推荐:先destroy,在undefine 导入配置define 修改配置edit(自带语法检查) 重命名domrename (低版本不支持)

挂起suspend 恢复resume 查询vnc端口号vncdisplay

kvm虚拟机开机启动 kvm运行业务程序 开机启动autostart,前提:systemctl enable libvirtd; 取消开机启动autostart --disable

console 控制台 登录

centos7的kvm虚拟机:

grubby --update-kernel=ALL --args=“console=ttyS0,115200n8”

reboot

作业1:安装一台centos6的kvm虚拟机,实现console登录 安装一台centos6的kvm虚拟机,在安装的过程中.内核参数selinux=0

4.6 kvm虚拟机虚拟磁盘管理和快照管理

raw: 俗称裸格式,占用空间比较大,不支持快照功能,不方便传输 ,读写性能较好 总50G,用1G,传输50G qcow2: qcow(copy on write)占用空间小,支持快照,性能比raw差一点,方便传输 总50G,用1G,传输1G

virt-install --virt-type kvm --os-type=linux --os-variant rhel7 --name centos7 --memory 1024 --vcpus 1 --disk /opt/centos2.raw,format=raw,size=10 --cdrom /opt/CentOS-7-x86_64-DVD-1708.iso --network network=default --graphics vnc,listen=0.0.0.0 --noautoconsole

virt-install --virt-type kvm --os-type=linux --os-variant rhel7 --name centos7 --memory 1024 --vcpus 1 --disk /opt/oldboy.qcow2,format=qcow2,size=10 --cdrom /data/CentOS-7.2-x86_64-DVD-1511.iso --network network=default --graphics vnc,listen=0.0.0.0 --noautoconsole

4.6.1 磁盘工具的常用命令

qemu-img info,create,resize,convert

查看虚拟磁盘信息 qemu-img info test.qcow2

创建一块qcow2格式的虚拟硬盘: qemu-img create -f qcow2 test.qcow2 2G

调整磁盘磁盘容量 qemu-img resize test.qcow2 +20G

raw转qcow2:qemu-img convert -f raw -O qcow2 oldboy.raw oldboy.qcow2 -c 压缩 virsh edit web01:

virsh destroy web01 virsh start web01

4.6.2 快照管理

创建快照virsh snapshot-create-as centos7 --name install_ok 查看快照virsh snapshot-list centos7

还原快照virsh snapshot-revert centos7 --snapshotname 1516574134 删除快照virsh snapshot-delete centos7 --snapshotname 1516636570

raw不支持做快照,qcow2支持快照,并且快照就保存在qcow2的磁盘文件中

4.7 kvm虚拟机克隆

4.7.1 完整克隆

自动挡:

virt-clone --auto-clone -o web01 -n web02 (完整克隆)

手动挡:

qemu-img convert -f qcow2 -O qcow2 -c web01.qcow2 web03.qcow2

virsh dumpxml web01 >web02.xml

vim web02.xml

#修改虚拟机的名字

#删除虚拟机uuid

#删除mac地址mac add

#修改磁盘路径disk

virsh define web02.xml

virsh start web02

4.7.2 链接克隆

a:生成虚拟机磁盘文件

qemu-img create -f qcow2 -b web03.qcow2 web04.qcow2

b:生成虚拟机的配置文件

virsh dumpxml web01 >web03.xml

vim web03.xml

#修改虚拟机的名字

web03

#删除虚拟机uuid

8e505e25-5175-46ab-a9f6-feaa096daaa4

#删除mac地址

#修改磁盘路径

c:导入虚拟机并进行启动测试

virsh define web03.xml virsh start web03

全自动链接克隆脚本:

[root@kvm01 scripts]# cat link_clone.sh

#!/bin/bash

old_vm=$1

new_vm=$2

#a:生成虚拟机磁盘文件

old_disk=

virsh dumpxml $old_vm|grep "<source file"|awk -F"'" '{print $2}'disk_tmp=

dirname $old_diskqemu-img create -f qcow2 -b $old_disk d i s k t m p / {disk_tmp}/ disktmp/{new_vm}.qcow2

#b:生成虚拟机的配置文件

virsh dumpxml o l d v m > / t m p / old_vm >/tmp/ oldvm>/tmp/{new_vm}.xml

#修改虚拟机的名字

sed -ri "s#()(.*)()#\1KaTeX parse error: Undefined control sequence: \3 at position 9: {new_vm}\̲3̲#g" /tmp/{new_vm}.xml

#删除虚拟机uuid

sed -i ‘//d’ /tmp/KaTeX parse error: Expected 'EOF', got '#' at position 14: {new_vm}.xml #̲删除mac地址 sed -i…{new_vm}.xml

#修改磁盘路径

sed -ri “s#()#\1 d i s k t m p / {disk_tmp}/ disktmp/{new_vm}.qcow2\3#g” /tmp/KaTeX parse error: Expected 'EOF', got '#' at position 14: {new_vm}.xml #̲c:导入虚拟机并进行启动测试 …{new_vm}.xml

virsh start ${new_vm}

4.8 kvm虚拟机的桥接网络

默认的虚拟机网络是NAT模式,网段192.168.122.0/24

4.8.1 创建桥接网卡

创建桥接网卡命令 virsh iface-bridge eth0 br0 取消桥接网卡命令 virsh iface-unbridge br0

4.8.2 新虚拟机使用桥接模式

默认NAT模式

virt-install --virt-type kvm --os-type=linux --os-variant rhel7 --name web04 --memory 1024 --vcpus 1 --disk /opt/web04.qcow2 --boot hd --network network=default --graphics vnc,listen=0.0.0.0 --noautoconsole

桥接模式

virt-install --virt-type kvm --os-type=linux --os-variant rhel7 --name web04 --memory 1024 --vcpus 1 --disk /data/web04.qcow2 --boot hd --network bridge=br0 --graphics vnc,listen=0.0.0.0 --noautoconsole

问题1:

如果虚拟机获取不到ip地址:

4.8.3 将已有虚拟机网络修改为桥接模式

a:关机状态下修改虚拟机配置文件:

例如:virsh edit centos7

虚拟机开机之后,修改ip地址为10.0.0.11

上传脚本openstack-mitaka-autoinstall.sh到/root目录

上传镜像:cirros-0.3.4-x86_64-disk.img到/root目录

上传配置文件:local_settings到/root目录

上传openstack_rpm.tar.gz到/root下,

tar xf openstack_rpm.tar.gz -C /opt/ mount /dev/cdrom /mnt

sh /root/openstack-mitaka-autoinstall.sh

大概10-30分钟左右 访问http://10.0.0.11/dashboard 域:default 用户名:admin 密码:ADMIN_PASS

注意: 在windows系统上修改host解析(10.0.0.11 controller)

添加node节点:

修改ip地址 hostnamectl set-hostname compute1

重新登录让新主机名生效 上传openstack_rpm.tar.gz到/root下,

tar xf openstack_rpm.tar.gz -C /opt/ mount /dev/cdrom /mnt

上传脚本openstack_compute_install.sh

sh openstack_compute_install.sh

openstack controller

主控制节点,node节点, kvm宿主机

node节点, kvm宿主机

node节点, kvm宿主机

node节点, kvm宿主机

二、 第二部分 docker容器

- 什么是容器

容器是隔离的环境中运行的一个进程,如果进程结束,容器就会停止,容器的隔离环境,拥有自己的ip地址,系统文件,主机名,进程管理

程序: 代码,软件,命令

进程:正在运行的程序 - 容器和虚拟机的区别

虚拟机: 硬件cpu支持(vt虚拟化),模拟计算硬件,走正常的开机启动

bios开机自检–根据bios启动项–读取硬盘第一个扇区grub,uefi, centos7, 加载内核,启动系统第一个进程/sbin/init systemd

容器: 不需要硬件cpu的支持,共用宿主机内核,启动容器的第一个进程

容器优势: 启动快,性能高,损耗少,轻量级

100虚拟机 100个服务 10宿主机

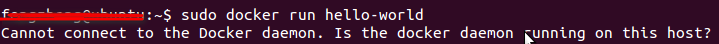

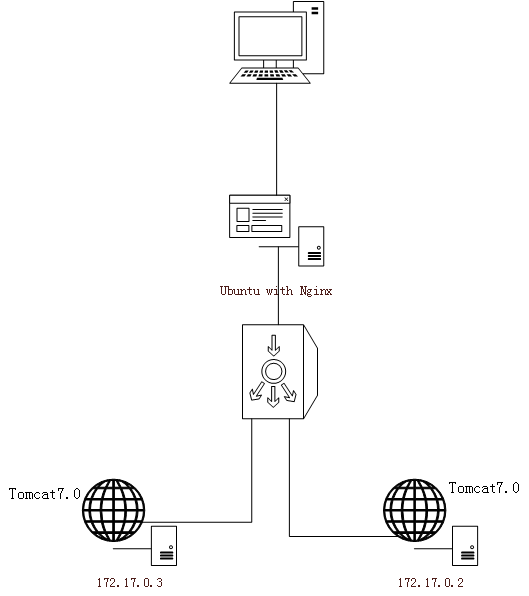

100容器 100个服务 6宿主机 - docker-ce的安装

主机名 内存 ip

docker01 2G 10.0.0.11

docker02 2G 10.0.0.12

#安装docker-ce

wget -O /etc/yum.repos.d/docker-ce.repo https://download.docker.com/linux/centos/docker-ce.repo

sed -i ‘s+download.docker.com+mirrors.tuna.tsinghua.edu.cn/docker-ce+’ /etc/yum.repos.d/docker-ce.repo

yum install docker-ce -y

systemctl enable docker

systemctl start docker

#验证

[root@docker01 yum.repos.d]# docker version

Client: Docker Engine - Community

Version: 19.03.5

API version: 1.40

Go version: go1.12.12

Git commit: 633a0ea

Built: Wed Nov 13 07:25:41 2019

OS/Arch: linux/amd64

Experimental: false

4. docker主要内容

docker是一个cs架构, docker主要:镜像 容器 仓库 网络 存储 监控

docker是一个软件的打包技术.

docker run -d -p 80:80 nginx:latest

run 创建并启动一个容器

-d 放后台启动

-p 端口映射

nginx:latest docker镜像名称

5. docker镜像常用命令

拉取/下载镜像

docker pull 镜像名称 [拉取镜像(下载镜像),注意版本]

docker push 镜像名称 [推送镜像(上传镜像)]

构建镜像

docker build -t 镜像名称

查看已经下载的镜像

docker image ls

删除本地镜像

docker rmi 镜像名称

镜像导入/导出

docker import 导入镜像

• -c :应用docker 指令创建镜像;

• -m :提交时的说明文字

docker load -i 加载本地镜像

docker save -o 导出路径 镜像id

例子:docker save centos:7 -o docker_centos7.tar.gz

搜索镜像

docker search 搜索镜像, 优先选官方,stars数量多

例子: docker load -i docker_nginx.tar.gz

给镜像打标签

docker tag 镜像id 新镜像名称:版本

查看镜像创建历史

docker history 查看指定镜像的创建历史

• -H :以可读的格式打印镜像大小和日期,默认为true;

• --no-trunc :显示完整的提交记录;

• -q :仅列出提交记录ID。

- docker容器的常用命令

运行容器

docker run 镜像标识|镜像名称

( -v -e --privilege –network=host)

例子:docker run -d -it -p 80:80 nginx:latest

-d表示后台运行 -p表示宿机与容器间的映射端口 --name表示给容器指定的命名

创建容器

docker create 创建容器 –name

容器的启动、关闭、重启

docker start 启动容器

docker stop 停止容器

docker restart 重启容器

docker kill 强制停止容器

查看正在运行的容器

docker ps 查看容器列表

docker ps -a 查看所有容器 包括未运行的

docker ps -q 查看容器的标识

docker rm 删除容器

批量删除所有容器 docker rm -fdocker ps -a -q

查看容器日志

docker logs -f 容器id 查看容器的控制台输出

-f表示查看最后几行

进入容器

docker exec 进入正在运行的容器(分配一个新终端)

例子: docker exec -it 容器id/容器名字 /bin/bash(/bin/sh)

docker attach 进入正在运行的容器(使用相同的终端),偷偷离开的快捷键ctrl +p,ctrl +q

容器想要放在后台一直运行的化,那么容器的初始命令,必须夯住(前台运行),否则容器就会退出.

前台运行

nginx -g ‘daemon off;’

/usr/sbin/php-fpm –nodaemonize

启动、关闭、删除、重命名容器

docker start 容器id 启动容器

docker stop 容器id 关闭容器

docker rm 容器id 删除容器

docker rename 容器id 重命名容器

查看容器

docker top 查看容器中运行的进程信息,支持 ps 命令参数

docker container diff 查看容器中发生变化的文件

docker container inspect 查看容器的属性

docker container port 查看容器做了哪些随机端口

docker container stats 查看容器的所耗信息(–no-stream)

docker system df 查看容器的使用情况(整体磁盘的使用情况)

docker system info 查看整个docker系统的信息[容器的运行环境:runc]

容器的导入导出

docker commit 把容器提交为镜像

docker container export 把容器导出为镜像压缩包

[docker export 3984da8164fb >docker_test.tar.gz(export导出的镜像压缩包只能用inport导入)]

容器的拷贝、挂起、释放、移除、修改、清理

docker cp 用于容器与宿主机之间的数据拷贝

docker container pause 挂起容器

docker container upause 释放挂起的容器

docker container prune 移除所有停止的容器

docker container update 修改容器的属性,(–memory --memory-swap)

docker container wait 等一个或多个容器停止,打印出退出代码

docker system prune 清理没有使用的数据,包括镜像数据,已经停止的容器

docker system events 获取docker系统实时事件,不包括容器内的。 - docker端口映射

docker run

-p 宿主机端口:容器端口

-p 宿主机ip1:宿主机端口:容器端口 (多个容器同时使用80端口)

-p 宿主机ip1::容器端口 随机端口映射

-p 宿主机ip1::容器端口/udp 使用udp协议做随机端口映射

-p 80:80 -p 3306:3306

-p 1111-1119:1111-1119 端口范围映射

-P 自动随机端口映射 - docker数据卷

docker run

-v 宿主机绝对目录:容器目录

-v 容器目录 #创建一个随机卷,来持久化容器的目录下的数据

-v 卷名:容器目录 #创建一个固定名字的卷,来持久化容器的目录下的数据

–volumes-from 跟某一个容器挂载所有相同的卷

小练习: 只启动一个nginx容器,要求访问80端口,出现nginx默认欢迎首页,访问81端口,出现小鸟飞飞. - 手动制作docker镜像

制作一个基于centos7系统的nginx镜像(单服务)

1:手动做镜像

a:启动一个基础容器,安装服务

echo “192.168.15.253 mirrors.aliyun.com” >>/etc/hosts

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

curl -o /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

yum install nginx -y

rm -fr /usr/share/nginx/html/index.html

echo ‘web01’ >/usr/share/nginx/html/index.html

b:将安装好服务的容器提交为镜像

docker container commit 0f65a315c159 centos7_nginx:v1

c:测试镜像

docker run -d -p 82:80 centos7_nginx:v1 nginx -g ‘daemon off;’

制作一个支持ssh登录的镜像

docker run -it -p 1022:22 centos:7

echo “192.168.15.253 mirrors.aliyun.com” >>/etc/hosts

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

yum install openssh-server -y

systemctl start sshd

cat /usr/lib/systemd/system/sshd.service

/usr/sbin/sshd -D

ls /etc/ssh/

cat /usr/lib/systemd/system/sshd-keygen.service

/usr/sbin/sshd-keygen

rpm -qa|grep initscripts

yum install initscripts -y

/usr/sbin/sshd-keygen

ls /etc/ssh/

/usr/sbin/sshd

ctrl+p ctrl+q 悄悄离开

docker ps -a -l

ssh root010.0.0.11 -p 1022

需要密码,然后ctrl+c退出

docker attach 6a0ece9b8778(这个是自己的容器ID)

进入容器

echo '123456 ’ |passwd --stdin root(设置密码)

ctrl+p ctrl+q 悄悄离开

ssh roota10.0.0.11 -p 1022

ps -ef

logout

docker attach 6a0ece9b8778

exit

宿主机:

docker ps -a -l

将容器提交为一个镜像

docker commit 6a0ece9b8778 centos7_sshd: v1

测试镜像

docker run -d -p 1023:22 centos7_sshd:v1 /usr/sbin/sshd -D

docker ps -a-l

ssh root010.0.0.11 -p 1023

制作一个基于centos7系统的Nginx+sshd双服务镜像

curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

curl -o /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

yum install Nginx -y

yum install openssh-server -y

yum install initscripts -y

/usr/sbin/sshd-keygen

echo ‘123456’|passwd --stdin root

提交镜像之前写脚本

vim /init.sh

Nginx

/usr/sbin/sshd -D

提交镜像

docker commit f784da45ec97 centos_Nginx_sshd: v1

(已经提交了但是没写脚本怎么办?

重新弄一个容器写脚本

/usr/sbin/sshd -D

制作一个基于centos7系统的kod网盘的镜像(多服务)

1:启动一个centos7_Nginx:v1,再安装PHP

echo ‘192.168.12.201 mirrors.aliyun.com’ >>/etc/hosts

yum install PHP-fpm PHP-gd PHP-mbstring -y

vi /etc/PHP-fpm.d/www.conf

; RPM: apache Choosed to be able to access some dir as httpd

user = Nginx

; RPM: Keep a group allowed to write in log dir.

group = Nginx

启动:

PHP-fpm -D

cd /etc/Nginx/conf.d/

vi default.conf

server {

listen 80;

server_name _;

root /html;

index index.PHP index.html index.htm;

location ~ .PHP$ {

root /html;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.PHP;

fastcgi_param SCRIPT_FILENAME /html$fastcgi_script_name;

include fastcgi_params;

}

}

mkdir /html

cd /html

curl -o kodexplorer4.40.zip http://192.168.15.253/kodexplorer4.40.zip

yum install unzip -y

unzip kodexplorer4.40.zip

vi /init.sh

#!/bin/bash

Nginx

/usr/sbin/PHP-fpm --nodaemonize

2:把安装好服务的容器,提交为镜像

docker commit 47208e3e3796 kod:v2

3:测试镜像的功能

docker run -d -p 83:80 kod:v2 /bin/bash /init.sh

10. 自动制作docker镜像

镜像: 中药

dockerfile: 配方

dockerfile常用指令

FROM 基础镜像

RUN 制作镜像过程中需要的执行命令(安装服务)

CMD 容器启动的时候执行的初始命令,容易被替换(启动服务)

ENTRYPOINT 容器启动的时候执行的初始命令,不能被替换,如果同时使用CMD和ENTRYPOINT,cmd命令将作为ENTRYPOINT命令的参数

ADD 把dockerfile当前目录下的文件拷贝到容器中(自动解压tar包)

copY 把dockerfile当前目录下的文件拷贝到容器中(不解压tar包)

workdir 指定容器的默认工作目录

EXPOSE 镜像要暴露的端口

VOLUME 持久化卷

ENV 环境变量(ssh的密码,数据库的密码)

LABEL 镜像的属性标签

MAINTAINER 管理者标识

根据dockerfile自动构建镜像的思路

a:手动制作docker镜像,记录历史命令

b:根据历史命令编写dockerfile文件

c:docker build构建docker镜像

d:测试镜像的功能

dockerfile单服务例子1:

FROM centos:6.9

RUN echo ‘192.168.19.200 mirrors.aliyun.com’ >>/etc/hosts

RUN curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-6.repo

RUN curl -o /etc/yum.repos.d/epel.repo http://mirrors.

aliyun.com/repo/epel-6.repo

RUN yum install Nginx -y

CMD [“Nginx”,"-g",“daemon off;”]

dockerfile多服务例子2:

FROM centos6.9_Nginx:v1

RUN yum install PHP-fpm PHP-gd PHP-mbstring -y

ADD www.conf /etc/PHP-fpm.d/www.conf

ADD default.conf /etc/Nginx/conf.d/default.conf

RUN mkdir /html

workdir /html

RUN curl -o kodexplorer4.40.zip http://192.168.19.200/191127/kodexplorer4.40.zip

RUN yum install unzip -y

RUN unzip kodexplorer4.40.zip

RUN chown -R Nginx:Nginx .

ADD init.sh /init.sh

CMD ["/bin/bash","/init.sh"]

vi /init.sh

#!/bin/bash

service PHP-fpm start

Nginx -g ‘daemon off;’

dockerfile使用环境变量的例子:

FROM centos:7

RUN curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

RUN curl -o /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

RUN yum install Nginx openssh-server initscripts -y

RUN /usr/sbin/sshd-keygen

ADD init.sh /init.sh

ENTRYPOINT ["/bin/bash","/init.sh"]

vi init.sh

#!/bin/bash

if [ -z $SSH_PWD ];then

SSH_PWD=$1

fi

echo $SSH_PWD|passwd --stdin root

Nginx

/usr/sbin/sshd -D

11. docker镜像的分层(复用,节省空间)

- dockerfile的优化

优化原则:

构建的镜像尽可能小,构建速度尽可能快

a: 使用体积小的linux镜像alpine作为基础镜像

[linux发行版最大的区别:安装包不一样、配置文件路径不一样、

Centos:yum rpm (red package manager ) 网卡配置路径

Suse:zypper

Ubuntu:apt-get /etc/network/interfaces /etc/int Nginx rzsz

Alpine:apk

sed -i ‘s/dl-cdn.alpinelinux.org/mirrors.tuna.tsinghua.edu.cn/g’/etc/apk/ repositories

apk add Nginx

Centos:编译器 gcc glibc jdk.rpm jdk.tar.gz

Alpine:编译器 musl libc

选择:alpine Debian/ubunto centos]

b:尽可能的清理无用的缓存文件(尽可能把多个RUN合并)

c:修改dockerfile的时候,尽可能把修改的内容放在最后

d:使用.dockerignore忽略构建docker镜像时,不需要的文件

13. 容器间的互联

容器之间通讯,面临的问题

容器IP地址按顺序分配,不知道要通讯的容器IP是多少

docker run –link docker run --name MysqL-server -it

-e MysqL_DATABASE=“zabbix”

-e MysqL_USER=“zabbix”

-e MysqL_PASSWORD=“zabbix_pwd”

-e MysqL_ROOT_PASSWORD=“root_pwd”

-d MysqL:5.7

–character-set-server=utf8 --collation-server=utf8_bin

docker run --name zabbix-java-gateway -t

-d zabbix/zabbix-java-gateway:latest

docker run --name zabbix-server-MysqL -t

-e DB_SERVER_HOST=“MysqL-server”

-e MysqL_DATABASE=“zabbix”

-e MysqL_USER=“zabbix”

-e MysqL_PASSWORD=“zabbix_pwd”

-e MysqL_ROOT_PASSWORD=“root_pwd”

-e ZBX_JAVAGATEWAY=“zabbix-java-gateway”

–link MysqL-server:MysqL

–link zabbix-java-gateway:zabbix-java-gateway

-p 10051:10051

-d zabbix/zabbix-server-MysqL:latest

docker run --name zabbix-web-Nginx-MysqL -t

-e DB_SERVER_HOST=“MysqL-server”

-e MysqL_DATABASE=“zabbix”

-e MysqL_USER=“zabbix”

-e MysqL_PASSWORD=“zabbix_pwd”

-e MysqL_ROOT_PASSWORD=“root_pwd”

–link MysqL-server:MysqL

–link zabbix-server-MysqL:zabbix-server

-p 80:80

-d zabbix/zabbix-web-Nginx-MysqL:latest

14. 单机版的容器编排

yum install docker-compose -y(需要epel源)

docker-compose:批量管理一组容器

批量启动

批量关闭

批量重启

docker-compose up -d 创建并启动一组容器

docker-compose down 停止并删除一组容器

docker-compose start 批量启动

docker-compose stop 批量停止

docker-compose restart 重启

docker-compose scale 设置服务的容器数

Yaml文件

缩进

运行容器的名字(单方向)

version: ‘3’

services:

MysqL-server:

image: MysqL:5.7

restart: always

environment:

MysqL_ROOT_PASSWORD: root_pwd

MysqL_DATABASE: zabbix

MysqL_USER: zabbix

MysqL_PASSWORD: zabbix_pwd

command: --character-set-server=utf8 --collation-server=utf8_bin

zabbix-java-gateway:

image: zabbix/zabbix-java-gateway:latest

restart: always

zabbix-server:

depends_on:

- MysqL-server

image: zabbix/zabbix-server-MysqL:latest

restart: always

environment:

DB_SERVER_HOST: MysqL-server

MysqL_DATABASE: zabbix

MysqL_USER: zabbix

MysqL_PASSWORD: zabbix_pwd

MysqL_ROOT_PASSWORD: root_pwd

ZBX_JAVAGATEWAY: zabbix-java-gateway

ports:

- “10051:10051”

zabbix-web-Nginx-MysqL:

depends_on:

- zabbix-server

image: zabbix/zabbix-web-Nginx-MysqL:latest

ports:

- “80:80”

restart: always

environment:

DB_SERVER_HOST: MysqL-server

MysqL_DATABASE: zabbix

MysqL_USER: zabbix

MysqL_PASSWORD: zabbix_pwd

MysqL_ROOT_PASSWORD: root_pwd

docker-compose up -d 启动服务

docker-compose down 停止服务

15. 私有仓库docker-registry

.上传镜像的步骤:

1:打标签

2: docker push. 上传

#启动私有仓库

docker run -d -p 5000:5000 --restart=always --name registry -v /opt/myregistry:/var/lib/registry registry :latest

#镜像地址

Nginx:1.15 官方仓库的官方镜像

Nginx/Nginx:1.15 官方仓库的用户镜像

daocloud.io/Nginx/Nginx:1.15 私有仓库的镜像

#上传镜像

docker tag alpine:3.9 10.0.0.11:5000/alpine:3.9

docker image push 10.0.0.11:5000/alpine:3.9

#第一次上传镜像会报错

vim /etc/docker/daemon.json

{

“registry-mirrors”: [“https://registry.docker-cn.com”],

“insecure-registries”: [“10.0.0.11:5000”]

}

systemctl restart docker

docker image push 10.0.0.11:5000/alpine:3.9

#下载镜像

docker image pull 10.0.0.11:5000/alpine:3.9

16. 企业级私有仓库harbor(docker-compose)

#下载安装器

[root@docker02 ~]# cd /opt/

[root@docker02 opt]# wget http://192.168.15.253/harbor-offline-installer-v2.1.0.tgz

#解压

[root@docker02 opt]# tar xf harbor-offline-installer-v2.1.0.tgz

#修改配置文件

[root@docker02 opt]# cd harbor/

[root@docker02 harbor]# curl -o /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

[root@docker02 harbor]# yum -y install docker-compose

[root@docker02 harbor]# cp harbor.yml.tmpl harbor.yml

[root@docker02 harbor]# vim harbor.yml

hostname: 10.0.0.12

注释https的配置

harbor_admin_password: 123456

#执行安装脚本

./install.sh

[root@docker01 ~]$vim /etc/docker/daemon.json

{

“registry-mirrors”: [" https://registry.docker-cn.com"],

“insecure-registries”: [" 10.0.0.12"]

}

[root@docker01 ~]$systemctl restart docker

[root@docker01 ~]

d

o

c

k

e

r

t

a

g

a

l

p

i

n

e

:

3.910.0.0.12

/

l

i

b

r

a

r

y

/

a

l

p

i

n

e

:

3.9

[

r

o

o

t

@

d

o

c

k

e

r

01

]

docker tag alpine:3.9 10.0.0.12/library/alpine:3.9 [root@docker01 ~]

dockertagalpine:3.910.0.0.12/library/alpine:3.9[root@docker01 ]docker login 10.0.0.12

[root@docker01 ~]$docker push 10.0.0.12/library/alpine:3.9

安全上传镜像(使用证书)

[root@docker02 opt]# mkdir cert

[root@docker02 opt]# cd cert

[root@docker02 cert]# pwd

/opt/cert

[root@docker02 cert]# wget http://192.168.15.253/blog.oldqiang.com.zip

[root@docker02 cert]# unzip blog.oldqiang.com.zip

[root@docker02 cert]# ls Nginx/

1_blog.oldqiang.com_bundle.crt 2_blog.oldqiang.com.key

[root@docker02 cert]# cd /opt/harbor/

[root@docker02 harbor]# pwd

/opt/harbor

[root@docker02 harbor]# cd /opt/

[root@docker02 opt]# cd cert

[root@docker02 cert]# ls

Apache blog.oldqiang.com.csr blog.oldqiang.com.zip IIS Nginx Tomcat

为harbor配置h#修改harbor.yml

[root@docker02 harbor]# vim harbor.yml

#配置域名

hostname: blog.oldqiang.com

#配置证书

https:

port: 443

certificate: /opt/certs/Nginx/1_blog.oldqiang.com_bundle.crt

private_key: /opt/certs/Nginx/2_blog.oldqiang.com.key

#重新执行安装脚本

./install.sh

[root@docker01 ~]# vim /etc/docker/daemon.json

[root@docker01 ~]# systemctl restart docker

[root@docker01 ~]# vim /etc/hosts

10.0.0.12 blog.oldqiang.com

[root@docker01 ~]# docker pull blog.oldqiang.com/library/alpine:3.9

docker images|grep Zabbix

docker tag zabbix/zabbix-server-MysqL:latest blog.oldqiang.com/zabbix/zabbix-server-MysqL:latest

docker login blog.oldqiang.com

docker pushblog.oldqiang.com/zabbix/zabbix-server-MysqL:latest

rm -rf/root/.docker/config.json

docker login blog.oldqiang.com

docker pull blog.oldqiang.com/zabbix/zabbix-server-MysqL:latest

docker-registry和harbor的区别,为什么优先选择harbor?

docker-registry 管理不方便,相对来说比较省资源

harbor 友好的web界面,功能更完善

17. docker基础网络

四种基础网络类型https证书

bridge 默认类型 NAT模式 访问外网需要端口映射

host host类型,使用宿主机网络,网络性能最高,不能有端口冲突,速度最高

container 容器类型。使用其他容器共用网络,k8s中使用

none 没有网络,上不了外网 不给IP地址

创建自定义网络

docker network create -d bridge --subnet 172.18.0.0/16 --gateway 172.18.0.1 oldqiang

-d 指定网络类型

–subnet 子网

–gateway 网关

18. 跨宿主机容器间的通讯之macvlan

macvlan类似与虚拟机的桥接网络

macvlan:容器拥有和宿主机同一网段的IP,不能检测IP地址,需手动管理IP地址分配

#创建网络

docker network create -d macvlan --subnet 10.0.0.0/24 --gateway 10.0.0.2 -o parent=eth0 macvlan_1

#启动容器

docker run -it --network macvlan_1 --ip 10.0.0.105 alpine:3.9

19. 跨宿主机容器间的通讯之overlay

overlay: IP存储在consul服务里面,使用该网络的容器,默认有两张网卡,eth0:容器之间通讯使用,eth1:访问外网,可实现容器之间的双向通讯

docker03上: consul存储ip地址的分配

docker run -d -p 8500:8500 -h consul --name consul progrium/consul -server -bootstrap

docker01、02上:

vim /etc/docker/daemon.json

{

“cluster-store”: “consul://10.0.0.13:8500”,

“cluster-advertise”: “10.0.0.11:2376”

}

systemctl restart docker

2)创建overlay网络

docker network create -d overlay --subnet 172.26.0.0/16 --gateway 172.26.0.1 ol1

3)启动容器测试

docker run -it --network ol1 --name oldboy01 alpine:3.9 /bin/sh

每个容器有两块网卡,eth0实现容器间的通讯,eth1实现容器访问外网

20. docker容器的监控

Linux监控:实现事前预警,

监控工具:

zabbix 容易使用,功能强大 监控传统业务,监控主要靠模板,不好监控容器,

nagios 不保存历史数据,

catic 保存历史数据,每五分钟监控一次,

openfalcon 不好用,上手程度不如zabbix

监控软件:

Prometheus 普罗米修斯,

docker使用,监控容器业务,

功能:实现对数据的处理,目前不能替代zabbix,要监控就得有exporter,

(exporter主要作用:采集数据提供HTML页面,页面有采集好的数据,) [启动Prometheus时自动生成prometheus.yml配置文件(target),]

作用:最终实现数据的集中处理。

Prometheus内置tsdb时间序列数据库,以时间作为索引,方便快速查询,

同时支持外置数据库,

需要在Prometheus中指定alterManager的IP和端口,实现报警(邮件报警、微信报警、钉钉报警,)

[报警规则:rule.yml文件]

官网下载:Prometheus.io/download

#配置普罗米修斯:prometheus节点:docker03

[root@oldboyedu ~]# cd /opt/

[root@oldboyedu opt]# wget

http://192.168.15.253/prometheus-2.23.0.linux-amd64.tar.gz

[root@oldboyedu opt]# tar xf prometheus-2.23.0.linux-amd64.tar.gz

[root@oldboyedu opt]# cd prometheus-2.23.0.linux-amd64/

[root@oldboyedu prometheus-2.23.0.linux-amd64]# vim prometheus.yml

#启动prometheus

[root@oldboyedu prometheus-2.23.0.linux-amd64]# ./prometheus --config.file=“prometheus.yml” &

#客户端节点 docker01\02

#启动node-exporter

docker run -d -p 9100:9100 -v “/:/host:ro,rslave” --name=node_exporter quay.io/prometheus/node-exporter --path.rootfs /host

#启动cadvisor

docker run --volume=/:/rootfs:ro --volume=/var/run:/var/run:rw --volume=/sys:/sys:ro --volume=/var/lib/docker/:/var/lib/docker:ro --publish=8080:8080 --detach=true --name=cadvisor google/cadvisor:latest

-p (publish)

-v (volume)

-d (detach)

浏览器访问:10.0.0.13:9090

prometheus节点

cd prometheus-2.12.0.linux-amd64/

vim prometheus.yml

{scrape_configs:

- job_name: ‘prometheus’

static_configs:- targets: [‘localhost:9090’]

- job_name: ‘cadvisor’

static_configs:- targets: [‘10.0.0.11:8080’,‘10.0.0.12:8080’]

- job_name: ‘node_exporter’

static_configs:- targets: [‘10.0.0.11:9100’,‘10.0.0.12:9100’]} (静态报警)

{ - job_name: ‘cadvisor’

file_sd_configs: - files:

- job/server.json

refresh_interval: 10s }(动态报警)

[root@oldboyedu prometheus-2.23.0.linux-amd64]# mkdir job

[root@oldboyedu prometheus-2.23.0.linux-amd64]# vi job/server.json

[

{

“targets”: [" 10.0.0.11:8080"," 10.0.0.12:8080"]

}

]

[root@oldboyedu prometheus-2.23.0.linux-amd64]# ps -ef |grep prome

root 27748 26657 0 10:46 pts/0 00:00:02 ./prometheus --config.file=prometheus.yml

root 27987 26657 0 11:18 pts/0 00:00:00 grep --color=auto prome

[root@oldboyedu prometheus-2.23.0.linux-amd64]# kill 26657

[root@oldboyedu prometheus-2.23.0.linux-amd64]# ./prometheus --config.file=“prometheus.yml” &

- job/server.json

- targets: [‘10.0.0.11:9100’,‘10.0.0.12:9100’]} (静态报警)

#启动prometheus

./prometheus --config.file=“prometheus.yml” &

浏览器访问:10.0.0.13:9090

alterManager报警:

思路:alterManager配置收件人和发件人

普罗米修斯上配置报警规则rule.yml(重启生效)

Grafana(开源的数据可视化工具)

普罗米修斯节点:

#安装grafana

yum localinstall grafana-6.3.3-1.x86_64.rpm -y

systemctl start grafana-server.service

systemctl enable grafana-server.service

#访问grafana http://10.0.0.13:3000,默认账号admin:admin

插件;zabbix的插件

数据源:要写上普罗米修斯的地址

作用:优化web界面

新建数据源导入dashboard模板

保存并退出:

保存后我们发现普罗米修斯数据源添加成功:

Dashboard:出图模板(grafan.doc官网下载)

浏览器访问grafana官网:grafana.com/docs

上传刚刚下载的json文件

实现监控nodeExporter:

实现监控cadvisor:

下载json文件:

在普罗米修斯中的图:

三、 第三部分:k8s

- k8s集群的安装

1.1 k8s的架构

一个master对应一群node

Kubectl:用户通过这个工具去调用api-server管理集群

Master:

api-server :相当于k8s的网关,所有的请求都得经过api-server转发

scheduler:使用调度算法将请求调度到某一个node节点

controller:控制器,维护k8s资源 删除增加等

etcd:存储资源对象 服务注册 发现

node:

docker:运行容器的环境 即容器引擎

kubelet:每个node节点都有一个,在node资源相关指令就由kubelet来执行。扫描etcd获取相关指令,扫描请求。一旦发现请求,就在node执行。

Kube-proxy: 代理服务

Pod: 最小单元 ,内部是容器 。k8s不直接管理容器,是通过管理pod来管理容器

Fluented:日志收集服务

Service:

Scheduler的调度:

请求交给api-server,然后将指令数据存储在etcd,node节点的kubelet扫描etcd,从etcd之中获取相关数据信息,然后再node节点执行相关的指令

ReplicationControler/replicaset: rs 副本控制器 管理pod

Deployment:管理rs与pod

StatefulSet:

Daemonset:确保多节点部署同一个pod.

核心服务:API server (解析执行任何的k8s命令)[所有k8s组都受API server控制,调用docker创建容器]

etcd :数据库 (存储k8s中创建的资源)[非关系型数据库]

Schedule:调度器 (创建容器时,选择合适的目前资源较多,负载不是很高的,剩余内存较多的节点)

node节点安装一个服务(kubelet:调用docker来实现对容器的管理,随时可以接受API server的远程控制)

所有容器封装在pod中

API server调用kubelet创建容器–kubelet调用docker

监管的角色(controller manager—控制管理,检测容器数量与状态,确保数量不减少)

k8s与cadvisor谷歌公司开发

Kube-proxy作用:实现负载均衡

Plugin network网络插件

Calico 3层acl

Fiannel(简单、高效、容器达到跨宿主机通讯)

k8s构建:

master:etcd api-server controller-manager scheduler

node : kubelet kube-proxy

kubelet作用:接受api-server指令,调用docker启动容器

除了核心组件,还有一些推荐的Add-ons:(附加组件是可选的)

组件名称 说明

kube-dns 负责为整个集群提供DNS服务

Ingress Controller 为服务提供外网入口

Heapster 提供资源监控

Dashboard 提供GUI(web界面)

Federation 提供跨可用区的集群(联邦集群,管理多套环境)

Fluentd-elasticsearch 提供集群日志采集、存储与查询

Kubectl命令:

create

describe

edit

get

exec

scale

set image

Run 默认创建deployment

expose

rolling-update

rolllout

logs

1.2 k8s的架构(二进制安装)

1.3 k8s的安装(二进制安装)

环境准备(修改ip地址,主机名,host解析)

做hosts解析和秘钥推送(四个节点都要做)

vim /etc/hosts

10.0.0.11 k8s-master

10.0.0.12 k8s-node1

10.0.0.13 k8s-node2

10.0.0.14 k8s-node3

ssh-keygen

ssh-copy-id root@10.0.0.11

ssh-copy-id root@10.0.0.12

ssh-copy-id root@10.0.0.13

ssh-copy-id root@10.0.0.14

主机 ip 内存 软件

k8s-master 10.0.0.11 1g etcd,api-server,controller-manager,scheduler

k8s-node1 100.0.12 2g etcd,kubelet,kube-proxy,docker,flannel

k8s-node2 10.0.0.13 2g ectd,kubelet,kube-proxy,docker,flannel

k8s-node3 10.0.0.14 1g kubelet,kube-proxy,docker,flannel

1.3.1 颁发证书:

K8s组件都是通过http协议,节点和节点之间通讯需要证书

etcd–etcd—etcd

api-server – etcd

flanneld –> etcd

api-server –> kubelet

api-server -> kube-proxy

6443 https

api-server –> controller-manager

api-server -> scheduler

8080 http 127.0.0.1

准备证书颁发工具[openssl生成ca.crt证书,生成xxx.csr请求文件,生成xxx.key私钥,比较麻烦,现在使用cfssl生成证书比较简单,cfssl-certinfo验证证书的有效期]

在node3节点上

[root@k8s-node3 ~]# mkdir /opt/softs

[root@k8s-node3 ~]# cd /opt/softs

[root@k8s-node3 softs]# rz -E

[root@k8s-node3 softs]# ls

cfssl cfssl-certinfo cfssl-json

[root@k8s-node3 softs]# chmod +x /opt/softs/*

[root@k8s-node3 softs]# ln -s /opt/softs/* /usr/bin/

[root@k8s-node3 softs]# mkdir /opt/certs

[root@k8s-node3 softs]# cd /opt/certs

编辑ca证书配置文件

vi /opt/certs/ca-config.json

i{

“signing”: {

“default”: {

“expiry”: “175200h”

},

“profiles”: {

“server”: {

“expiry”: “175200h”,

“usages”: [

“signing”,

“key encipherment”,

“server auth”

]

},

“client”: {

“expiry”: “175200h”,

“usages”: [

“signing”,

“key encipherment”,

“client auth”

]

},

“peer”: {

“expiry”: “175200h”,

“usages”: [

“signing”,

“key encipherment”,

“server auth”,

“client auth”

]

}

}

}

}

编辑ca证书请求配置文件

vi /opt/certs/ca-csr.json

i{

“CN”: “kubernetes-ca”,

“hosts”: [

],

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

],

“ca”: {

“expiry”: “175200h”

}

}

生成CA证书和私钥

[root@k8s-node3 certs]# cfssl gencert -initca ca-csr.json | cfssl-json -bare ca -

[root@k8s-node3 certs]# ls

ca-config.json ca.csr ca-csr.json ca-key.pem ca.pem

1.3.2 部署etcd集群

主机名 ip 角色

k8s-master 10.0.0.11 etcd lead

k8s-node1 10.0.0.12 etcd follow

k8s-node2 10.0.0.13 etcd follow

颁发etcd节点之间通信的证书

vi /opt/certs/etcd-peer-csr.json

i{

“CN”: “etcd-peer”,

“hosts”: [

“10.0.0.11”,

“10.0.0.12”,

“10.0.0.13”

],

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

]

}

[root@k8s-node3 certs]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=peer etcd-peer-csr.json | cfssl-json -bare etcd-peer

[root@k8s-node3 certs]# ls etcd-peer*

etcd-peer.csr etcd-peer-csr.json etcd-peer-key.pem etcd-peer.pem

安装etcd服务

在k8s-master,k8s-node1,k8s-node2上

yum install etcd -y

#在node3上发送证书到/etc/etcd目录

[root@k8s-node3 certs]# scp -rp *.pem root@10.0.0.11:/etc/etcd/

[root@k8s-node3 certs]# scp -rp *.pem root@10.0.0.12:/etc/etcd/

[root@k8s-node3 certs]# scp -rp .pem root@10.0.0.13:/etc/etcd/

#所有节点

[root@k8s-master ~]# chown -R etcd:etcd /etc/etcd/.pem

#master节点

[root@k8s-master ~]# grep -Ev ‘^$|#’ /etc/etcd/etcd.conf

ETCD_data_dir="/var/lib/etcd/"

ETCD_LISTEN_PEER_URLS=“https://10.0.0.11:2380”

ETCD_LISTEN_CLIENT_URLS=“https://10.0.0.11:2379,http://127.0.0.1:2379”

ETCD_NAME=“node1”

ETCD_INITIAL_ADVERTISE_PEER_URLS=“https://10.0.0.11:2380”

ETCD_ADVERTISE_CLIENT_URLS=“https://10.0.0.11:2379,http://127.0.0.1:2379”

ETCD_INITIAL_CLUSTER=“node1=https://10.0.0.11:2380,node2=https://10.0.0.12:2380,node3=https://10.0.0.13:2380”

ETCD_INITIAL_CLUSTER_TOKEN=“etcd-cluster”

ETCD_INITIAL_CLUSTER_STATE=“new”

ETCD_CERT_FILE="/etc/etcd/etcd-peer.pem"

ETCD_KEY_FILE="/etc/etcd/etcd-peer-key.pem"

ETCD_CLIENT_CERT_AUTH=“true”

ETCD_TRUSTED_CA_FILE="/etc/etcd/ca.pem"

ETCD_AUTO_TLS=“true”

ETCD_PEER_CERT_FILE="/etc/etcd/etcd-peer.pem"

ETCD_PEER_KEY_FILE="/etc/etcd/etcd-peer-key.pem"

ETCD_PEER_CLIENT_CERT_AUTH=“true”

ETCD_PEER_TRUSTED_CA_FILE="/etc/etcd/ca.pem"

ETCD_PEER_AUTO_TLS=“true”

#node1和node2需修改

ETCD_LISTEN_PEER_URLS=“https://10.0.0.11:2380”

ETCD_LISTEN_CLIENT_URLS=“https://10.0.0.11:2379,http://127.0.0.1:2379”

ETCD_NAME=“node1”

ETCD_INITIAL_ADVERTISE_PEER_URLS=“https://10.0.0.11:2380”

ETCD_ADVERTISE_CLIENT_URLS=“https://10.0.0.11:2379,http://127.0.0.1:2379”

#3个etcd节点同时启动

systemctl start etcd

systemctl enable etcd

#验证

[root@k8s-master ~]# etcdctl member list

1.3.3 master节点的安装

安装api-server服务

上传kubernetes-server-linux-amd64-v1.15.4.tar.gz到node3上,然后解压

[root@k8s-node3 softs]# ls

cfssl cfssl-certinfo cfssl-json kubernetes-server-linux-amd64-v1.15.4.tar.gz

[root@k8s-node3 softs]# tar xf kubernetes-server-linux-amd64-v1.15.4.tar.gz

[root@k8s-node3 softs]# ls

cfssl cfssl-certinfo cfssl-json kubernetes kubernetes-server-linux-amd64-v1.15.4.tar.gz

[root@k8s-node3 softs]# cd /opt/softs/kubernetes/server/bin/

[root@k8s-node3 bin]# rm -rf *.tar *_tag

[root@k8s-node3 bin]# scp -rp kube-apiserver kube-controller-manager kube-scheduler kubectl root@10.0.0.11:/usr/sbin/

签发client证书

[root@k8s-node3 bin]# cd /opt/certs/

[root@k8s-node3 certs]# vi /opt/certs/client-csr.json

i{

“CN”: “k8s-node”,

“hosts”: [

],

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

]

}

[root@k8s-node3 certs]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=client client-csr.json | cfssl-json -bare client

[root@k8s-node3 certs]# ls client*

client.csr client-csr.json client-key.pem client.pem

签发kube-apiserver证书

[root@k8s-node3 certs]# vi /opt/certs/apiserver-csr.json

i{

“CN”: “apiserver”,

“hosts”: [

“127.0.0.1”,

“10.254.0.1”,

“kubernetes.default”,

“kubernetes.default.svc”,

“kubernetes.default.svc.cluster”,

“kubernetes.default.svc.cluster.local”,

“10.0.0.11”,

“10.0.0.12”,

“10.0.0.13”

],

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

]

}

#注意10.254.0.1为clusterIP网段的第一个ip,做为pod访问api-server的内部ip,oldqiang在这一块被坑了很久

[root@k8s-node3 certs]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=server apiserver-csr.json | cfssl-json -bare apiserver

[root@k8s-node3 certs]# ls apiserver*

apiserver.csr apiserver-csr.json apiserver-key.pem apiserver.pem

配置api-server服务

master节点

#拷贝证书

[root@k8s-master ~]# mkdir /etc/kubernetes

[root@k8s-master ~]# cd /etc/kubernetes

[root@k8s-master kubernetes]# scp -rp root@10.0.0.14:/opt/certs/capem .

[root@k8s-master kubernetes]# scp -rp root@10.0.0.14:/opt/certs/apiserverpem .

[root@k8s-master kubernetes]# scp -rp root@10.0.0.14:/opt/certs/client*pem .

[root@k8s-master kubernetes]# ls

apiserver-key.pem apiserver.pem ca-key.pem ca.pem client-key.pem client.pem

#api-server审计日志规则

[root@k8s-master kubernetes]# vi audit.yaml

iapiVersion: audit.k8s.io/v1beta1 # This is required.

kind: Policy

Don’t generate audit events for all requests in RequestReceived stage.

omitStages:

- “RequestReceived”

rules:

Log pod changes at RequestResponse level

- level: RequestResponse

resources:

Log “pods/log”, “pods/status” at Metadata level

- level: Metadata

resources:- group: “”

resources: [“pods/log”, “pods/status”]

- group: “”

Don’t log requests to a configmap called “controller-leader”

Don’t log watch requests by the “system:kube-proxy” on endpoints or services

- level: None

users: [“system:kube-proxy”]

verbs: [“watch”]

resources:- group: “” # core API group

resources: [“endpoints”, “services”]

- group: “” # core API group

Don’t log authenticated requests to certain non-resource URL paths.

- level: None

userGroups: [“system:authenticated”]

nonResourceURLs:- “/api*” # Wildcard matching.

- “/version”

Log the request body of configmap changes in kube-system.

- level: Request

resources:- group: “” # core API group

resources: [“configmaps”]

This rule only applies to resources in the “kube-system” namespace.

The empty string “” can be used to select non-namespaced resources.

namespaces: [“kube-system”] - group: “” # core API group

Log configmap and secret changes in all other namespaces at the Metadata level.

Log all other resources in core and extensions at the Request level.

- level: Request

resources:- group: “” # core API group

- group: “extensions” # Version of group should NOT be included.

A catch-all rule to log all other requests at the Metadata level.

-

level: Metadata

Long-running requests like watches that fall under this rule will not

generate an audit event in RequestReceived.

omitStages:

- “RequestReceived”

vi /usr/lib/systemd/system/kube-apiserver.service

i[Unit]

Description=Kubernetes API Server

Documentation=https://github.com/kubernetes/kubernetes

After=etcd.service

[Service]

ExecStart=/usr/sbin/kube-apiserver

–audit-log-path /var/log/kubernetes/audit-log

–audit-policy-file /etc/kubernetes/audit.yaml

–authorization-mode RBAC

–client-ca-file /etc/kubernetes/ca.pem

–requestheader-client-ca-file /etc/kubernetes/ca.pem

–enable-admission-plugins NamespaceLifecycle,LimitRanger,ServiceAccount,DefaultStorageClass,DefaultTolerationSeconds,MutatingAdmissionWebhook,ValidatingAdmissionWebhook,ResourceQuota

–etcd-cafile /etc/kubernetes/ca.pem

–etcd-certfile /etc/kubernetes/client.pem

–etcd-keyfile /etc/kubernetes/client-key.pem

–etcd-servers https://10.0.0.11:2379,https://10.0.0.12:2379,https://10.0.0.13:2379

–service-account-key-file /etc/kubernetes/ca-key.pem

–service-cluster-ip-range 10.254.0.0/16

–service-node-port-range 30000-59999

–kubelet-client-certificate /etc/kubernetes/client.pem

–kubelet-client-key /etc/kubernetes/client-key.pem

–log-dir /var/log/kubernetes/

–logtostderr=false

–tls-cert-file /etc/kubernetes/apiserver.pem

–tls-private-key-file /etc/kubernetes/apiserver-key.pem

–v 2 #(日志级别)

Restart=on-failure

[Install]

WantedBy=multi-user.target #(安装到多个用户级别)

[root@k8s-master kubernetes]# mkdir /var/log/kubernetes

[root@k8s-master kubernetes]# systemctl daemon-reload

[root@k8s-master kubernetes]# systemctl start kube-apiserver.service

[root@k8s-master kubernetes]# systemctl enable kube-apiserver.service

#检验

[root@k8s-master kubernetes]# kubectl get cs

安装controller-manager服务

[root@k8s-master kubernetes]# vi /usr/lib/systemd/system/kube-controller-manager.service

i[Unit]

Description=Kubernetes Controller Manager

Documentation=https://github.com/kubernetes/kubernetes

After=kube-apiserver.service

[Service]

ExecStart=/usr/sbin/kube-controller-manager

–cluster-cidr 172.18.0.0/16 \ #(pod节点的网段)

–log-dir /var/log/kubernetes/

–master http://127.0.0.1:8080

–service-account-private-key-file /etc/kubernetes/ca-key.pem

–service-cluster-ip-range 10.254.0.0/16 \ #(vip 的网段)

–root-ca-file /etc/kubernetes/ca.pem

–logtostderr=false

–v 2

Restart=on-failure

[Install]

WantedBy=multi-user.target

[root@k8s-master kubernetes]# systemctl daemon-reload

[root@k8s-master kubernetes]# systemctl start kube-controller-manager.service

[root@k8s-master kubernetes]# systemctl enable kube-controller-manager.service

安装scheduler服务

[root@k8s-master kubernetes]# vi /usr/lib/systemd/system/kube-scheduler.service

i[Unit]

Description=Kubernetes Scheduler

Documentation=https://github.com/kubernetes/kubernetes

After=kube-apiserver.service

[Service]

ExecStart=/usr/sbin/kube-scheduler

–log-dir /var/log/kubernetes/

–master http://127.0.0.1:8080

–logtostderr=false

–v 2

Restart=on-failure

[Install]

WantedBy=multi-user.target

[root@k8s-master kubernetes]# systemctl daemon-reload

[root@k8s-master kubernetes]# systemctl start kube-scheduler.service

[root@k8s-master kubernetes]# systemctl enable kube-scheduler.service

验证master节点

[root@k8s-master kubernetes]# kubectl get cs

1.3.4 node节点的安装

安装kubelet服务

在node3节点上签发证书

[root@k8s-node3 bin]# cd /opt/certs/

[root@k8s-node3 certs]# vi kubelet-csr.json

i{

“CN”: “kubelet-node”,

“hosts”: [

“127.0.0.1”,

“10.0.0.11”,

“10.0.0.12”,

“10.0.0.13”,

“10.0.0.14”,

“10.0.0.15”

],

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

]

}

[root@k8s-node3 certs]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=server kubelet-csr.json | cfssl-json -bare kubelet

[root@k8s-node3 certs]# ls kubelet*

kubelet.csr kubelet-csr.json kubelet-key.pem kubelet.pem

#生成kubelet启动所需的kube-config文件

[root@k8s-node3 certs]# ln -s /opt/softs/kubernetes/server/bin/kubectl /usr/sbin/

#设置集群参数

[root@k8s-node3 certs]# kubectl config set-cluster myk8s

–certificate-authority=/opt/certs/ca.pem

–embed-certs=true

–server=https://10.0.0.11:6443

–kubeconfig=kubelet.kubeconfig

#设置客户端认证参数

[root@k8s-node3 certs]# kubectl config set-credentials k8s-node --client-certificate=/opt/certs/client.pem --client-key=/opt/certs/client-key.pem --embed-certs=true --kubeconfig=kubelet.kubeconfig

#生成上下文参数

[root@k8s-node3 certs]# kubectl config set-context myk8s-context

–cluster=myk8s

–user=k8s-node

–kubeconfig=kubelet.kubeconfig

#切换默认上下文

[root@k8s-node3 certs]# kubectl config use-context myk8s-context --kubeconfig=kubelet.kubeconfig

#查看生成的kube-config文件

[root@k8s-node3 certs]# ls kubelet.kubeconfig

kubelet.kubeconfig

master节点上

[root@k8s-master ~]# vi k8s-node.yaml

iapiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding #(集群角色绑定)

Metadata:

name: k8s-node

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:node

subjects:

- apiGroup: rbac.authorization.k8s.io

kind: User

name: k8s-node

[root@k8s-master ~]# kubectl create -f k8s-node.yaml

node1节点:

#安装docker-ce

[root@k8s-node1 ~]# wget http://192.168.15.253/docker1903_rpm.tar.gz

[root@k8s-node1 ~]# tar xf docker1903_rpm.tar.gz

[root@k8s-node1 ~]# cd docker1903_rpm/

[root@k8s-node1 docker1903_rpm]# yum -y localinstall *.rpm

[root@k8s-node1 docker1903_rpm]# systemctl start docker.service

[root@k8s-node1 docker1903_rpm]# systemctl enable docker.service

vim /etc/docker/daemon.json

i{

“registry-mirrors”: [“https://registry.docker-cn.com”],

“exec-opts”: [“native.cgroupdriver=systemd”]

}

systemctl restart docker.service

systemctl enable docker.service

[root@k8s-node1 ~]# mkdir /etc/kubernetes

[root@k8s-node1 ~]# cd /etc/kubernetes

[root@k8s-node1 kubernetes]# scp -rp root@10.0.0.14:/opt/certs/kubelet.kubeconfig .

[root@k8s-node1 kubernetes]# scp -rp root@10.0.0.14:/opt/certs/capem .

[root@k8s-node1 kubernetes]# scp -rp root@10.0.0.14:/opt/certs/kubeletpem .

[root@k8s-node1 kubernetes]# scp -rp root@10.0.0.14:/opt/softs/kubernetes/server/bin/kubelet /usr/bin/

[root@k8s-node1 kubernetes]# mkdir /var/log/kubernetes

[root@k8s-node1 kubernetes]# vi /usr/lib/systemd/system/kubelet.service

i[Unit]

Description=Kubernetes Kubelet

After=docker.service

Requires=docker.service

[Service]

ExecStart=/usr/bin/kubelet

–anonymous-auth=false

–cgroup-driver systemd

–cluster-dns 10.254.230.254

–cluster-domain cluster.local

–runtime-cgroups=/systemd/system.slice

–kubelet-cgroups=/systemd/system.slice

–fail-swap-on=false

–client-ca-file /etc/kubernetes/ca.pem

–tls-cert-file /etc/kubernetes/kubelet.pem

–tls-private-key-file /etc/kubernetes/kubelet-key.pem

–hostname-override 10.0.0.12

–image-gc-high-threshold 20

–image-gc-low-threshold 10

–kubeconfig /etc/kubernetes/kubelet.kubeconfig

–log-dir /var/log/kubernetes/

–pod-infra-container-image t29617342/pause-amd64:3.0

–logtostderr=false

–v=2

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

注释: --fail-swap-on=false \ #(默认值是true,kubelate在启动的时候默认不支持swap,有swap的时候默认是有缓存的,)

–image-gc-high-threshold 20

–image-gc-low-threshold 10 \ #做镜像回收

–pod-infra-container-image t29617342/pause-amd64:3.0 \ #基础pod镜像容器地址

[root@k8s-node1 kubernetes]# systemctl daemon-reload

[root@k8s-node1 kubernetes]# systemctl start kubelet.service

[root@k8s-node1 kubernetes]# systemctl enable kubelet.service

node2节点:

以上步骤同node1节点只需改配置文件

[root@k8s-node2 kubernetes]# vi /usr/lib/systemd/system/kubelet.service

i[Unit]

Description=Kubernetes Kubelet

After=docker.service

Requires=docker.service

[Service]

ExecStart=/usr/bin/kubelet

–anonymous-auth=false

–cgroup-driver systemd

–cluster-dns 10.254.230.254

–cluster-domain cluster.local

–runtime-cgroups=/systemd/system.slice

–kubelet-cgroups=/systemd/system.slice

–fail-swap-on=false

–client-ca-file /etc/kubernetes/ca.pem

–tls-cert-file /etc/kubernetes/kubelet.pem

–tls-private-key-file /etc/kubernetes/kubelet-key.pem

–hostname-override 10.0.0.13

–image-gc-high-threshold 20

–image-gc-low-threshold 10

–kubeconfig /etc/kubernetes/kubelet.kubeconfig

–log-dir /var/log/kubernetes/

–pod-infra-container-image t29617342/pause-amd64:3.0

–logtostderr=false

–v=2

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

[root@k8s-node1 kubernetes]# systemctl daemon-reload

[root@k8s-node1 kubernetes]# systemctl start kubelet.service

[root@k8s-node1 kubernetes]# systemctl enable kubelet.service

master节点验证

[root@k8s-master ~]# kubectl get nodes

安装kube-proxy服务

在node3节点上签发证书

[root@k8s-node3 ~]# cd /opt/certs/

[root@k8s-node3 certs]# vi /opt/certs/kube-proxy-csr.json

i{

“CN”: “system:kube-proxy”,

“key”: {

“algo”: “rsa”,

“size”: 2048

},

“names”: [

{

“C”: “CN”,

“ST”: “beijing”,

“L”: “beijing”,

“O”: “od”,

“OU”: “ops”

}

]

}

[root@k8s-node3 certs]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=client kube-proxy-csr.json | cfssl-json -bare kube-proxy-client

[root@k8s-node3 certs]# ls kube-proxy-c*

kube-proxy-client.csr kube-proxy-client-key.pem kube-proxy-client.pem kube-proxy-csr.json

#生成kube-proxy启动所需要kube-config

[root@k8s-node3 certs]# kubectl config set-cluster myk8s

–certificate-authority=/opt/certs/ca.pem

–embed-certs=true

–server=https://10.0.0.11:6443

–kubeconfig=kube-proxy.kubeconfig

[root@k8s-node3 certs]# kubectl config set-credentials kube-proxy

–client-certificate=/opt/certs/kube-proxy-client.pem

–client-key=/opt/certs/kube-proxy-client-key.pem

–embed-certs=true

–kubeconfig=kube-proxy.kubeconfig

[root@k8s-node3 certs]# kubectl config set-context myk8s-context

–cluster=myk8s

–user=kube-proxy

–kubeconfig=kube-proxy.kubeconfig

[root@k8s-node3 certs]# kubectl config use-context myk8s-context --kubeconfig=kube-proxy.kubeconfig

[root@k8s-node3 certs]# ls kube-proxy.kubeconfig

kube-proxy.kubeconfig

[root@k8s-node3 certs]# scp -rp kube-proxy.kubeconfig root@10.0.0.12:/etc/kubernetes/

[root@k8s-node3 certs]# scp -rp kube-proxy.kubeconfig root@10.0.0.13:/etc/kubernetes/

[root@k8s-node3 certs]# cd /opt/softs/kubernetes/server/bin/

[root@k8s-node3 bin]# scp -rp kube-proxy root@10.0.0.12:/usr/bin/

[root@k8s-node3 bin]# scp -rp kube-proxy root@10.0.0.13:/usr/bin/

在node1节点上配置kube-proxy

[root@k8s-node1 ~]# vi /usr/lib/systemd/system/kube-proxy.service

i[Unit]

Description=Kubernetes Proxy

After=network.target

[Service]

ExecStart=/usr/bin/kube-proxy

–kubeconfig /etc/kubernetes/kube-proxy.kubeconfig

–cluster-cidr 172.18.0.0/16

–hostname-override 10.0.0.12

–logtostderr=false

–v=2

Restart=on-failure

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

[root@k8s-node1 ~]# systemctl daemon-reload

[root@k8s-node1 ~]# systemctl start kube-proxy.service

[root@k8s-node1 ~]# systemctl enable kube-proxy.service

Node2 节点上配置:

和node1一样,node2的/usr/lib/systemd/system/kube-proxy.service配置文件修改

–hostname-override 10.0.0.13

验证;

1.3.5 配置flannel网络

所有节点安装flannel(11、12、13)

yum install flannel -y

mkdir /opt/certs/

在node3上分发证书

[root@k8s-node3 ~]# cd /opt/certs/

[root@k8s-node3 certs]# scp -rp ca.pem clientpem root@10.0.0.11:/opt/certs/

[root@k8s-node3 certs]# scp -rp ca.pem clientpem root@10.0.0.12:/opt/certs/

[root@k8s-node3 certs]# scp -rp ca.pem client*pem root@10.0.0.13:/opt/certs/

在master节点上

etcd创建flannel的key

#通过这个key定义pod的ip地址范围

etcdctl mk /atomic.io/network/config ‘{ “Network”: “172.18.0.0/16”,“Backend”: {“Type”: “vxlan”} }’

#注意可能会失败提示

Error: x509: certificate signed by unkNown authority

#多重试几次就好了

配置启动flannel

vi /etc/sysconfig/flanneld

第4行:FLANNEL_ETCD_ENDPOINTS=“https://10.0.0.11:2379,https://10.0.0.12:2379,https://10.0.0.13:2379”

第8行不变:FLANNEL_ETCD_PREFIX="/atomic.io/network"

第11行:FLANNEL_OPTIONS="-etcd-cafile=/opt/certs/ca.pem -etcd-certfile=/opt/certs/client.pem -etcd-keyfile=/opt/certs/client-key.pem"

systemctl start flanneld.service

systemctl enable flanneld.service

[root@k8s-master ~]# scp -rp /etc/sysconfig/flanneld root@10.0.0.12:/etc/sysconfig/flanneld

[root@k8s-master ~]# scp -rp /etc/sysconfig/flannel root@10.0.0.13:/etc/sysconfig/flanneld

#验证

[root@k8s-master ~]# ifconfig flannel.1

flannel.1: flags=4163<UP,broADCAST,RUNNING,MULTICAST> mtu 1450

inet 172.18.43.0 netmask 255.255.255.255 broadcast 0.0.0.0

inet6 fe80::30d9:50ff:fe47:599e prefixlen 64 scopeid 0x20

ether 32:d9:50:47:59:9e txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 8 overruns 0 carrier 0 collisions 0

在node1和node2上

[root@k8s-node1 ~]# vim /usr/lib/systemd/system/docker.service

将ExecStart=/usr/bin/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

修改为ExecStart=/usr/bin/dockerd $DOCKER_NETWORK_OPTIONS -H fd:// --containerd=/run/containerd/containerd.sock

增加一行ExecStartPost=/usr/sbin/iptables -P FORWARD ACCEPT

[root@k8s-node1 ~]# systemctl daemon-reload

[root@k8s-node1 ~]# systemctl restart docker

验证:启动一个容器,测试网络通不通

Node1节点、node2节点启动一个容器

[root@k8s-node1 ~]# wget http://192.168.15.253/docker_images/docker_alpine3.9.tar.gz

[root@k8s-node1 ~]# docker load -i docker_alpine3.9.tar.gz

[root@k8s-node1 ~]# docker run -it alpine:3.9

/ # ifconfig

eth0 Link encap:Ethernet HWaddr 02:42:AC:12:4D:02

inet addr:172.18.77.2 Bcast:172.18.77.255 Mask:255.255.255.0

UP broADCAST RUNNING MULTICAST MTU:1450 Metric:1

RX packets:11 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:962 (962.0 B) TX bytes:0 (0.0 B)

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

UP LOOPBACK RUNNING MTU:65536 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

/ #

[root@k8s-node2 ~]# wget http://192.168.15.253/docker_images/docker_alpine3.9.tar.gz

[root@k8s-node2 ~]# docker load -i docker_alpine3.9.tar.gz

[root@k8s-node2 ~]# docker run -it alpine:3.9

/ # ifconfig

eth0 Link encap:Ethernet HWaddr 02:42:AC:12:48:02

inet addr:172.18.72.2 Bcast:172.18.72.255 Mask:255.255.255.0

UP broADCAST RUNNING MULTICAST MTU:1450 Metric:1

RX packets:11 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:0

RX bytes:962 (962.0 B) TX bytes:0 (0.0 B)

lo Link encap:Local Loopback

inet addr:127.0.0.1 Mask:255.0.0.0

UP LOOPBACK RUNNING MTU:65536 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

TX packets:0 errors:0 dropped:0 overruns:0 carrier:0

collisions:0 txqueuelen:1000

RX bytes:0 (0.0 B) TX bytes:0 (0.0 B)

/ #

在master节点上测试网络:

[root@k8s-master ~]# ping 172.18.77.2

PING 172.18.77.2 (172.18.77.2) 56(84) bytes of data.

64 bytes from 172.18.77.2: icmp_seq=1 ttl=63 time=1.73 ms

^C

— 172.18.77.2 ping statistics —

1 packets transmitted, 2 received, 0% packet loss, time 1001ms

rtt min/avg/max/mdev = 0.367/1.049/1.732/0.683 ms

[root@k8s-master ~]# ping 172.18.72.2

PING 172.18.72.2 (172.18.72.2) 56(84) bytes of data.

64 bytes from 172.18.72.2: icmp_seq=1 ttl=63 time=2.57 ms

^C

— 172.18.72.2 ping statistics —

1 packets transmitted, 2 received, 0% packet loss, time 1002ms

rtt min/avg/max/mdev = 0.387/1.480/2.573/1.093 ms

#验证,docker0网络为172.18网段就ok了

[root@k8s-node1 ~]# ifconfig docker0

docker0: flags=4099<UP,broADCAST,MULTICAST> mtu 1500

inet 172.18.41.1 netmask 255.255.255.0 broadcast 172.18.41.255

ether 02:42:07:3e:8a:09 txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

验证k8s集群的安装

[root@k8s-master ~]# kubectl run Nginx --image=Nginx:1.13 --replicas=2

#多等待一段时间,再查看pod状态

[root@k8s-master ~]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READInesS GATES

Nginx-6459cd46fd-8lln4 1/1 Running 0 3m27s 172.18.41.2 10.0.0.12

Nginx-6459cd46fd-xxt24 1/1 Running 0 3m27s 172.18.96.2 10.0.0.13

[root@k8s-master ~]# kubectl expose deployment Nginx --port=80 --target-port=80 --type=NodePort

[root@k8s-master ~]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.254.0.1 443/TCP 6h46m

Nginx NodePort 10.254.160.83 80:41760/TCP 3s

#打开浏览器访问http://10.0.0.12:41760,能访问就ok了

1.4 修改IP地址、主机名和host解析

10.0.0.11 k8s-master

10.0.0.12 k8s-node-1

10.0.0.13 k8s-node-2

所有节点需要做hosts解析

1.5 master节点安装etcd

yum install etcd -y

vim /etc/etcd/etcd.conf

6行:ETCD_LISTEN_CLIENT_URLS=“http://0.0.0.0:2379”

21行:ETCD_ADVERTISE_CLIENT_URLS=“http://10.0.0.11:2379”

systemctl start etcd.service

systemctl enable etcd.service

etcdctl set testdir/testkey0 0

etcdctl get testdir/testkey0

etcdctl -C http://10.0.0.11:2379 cluster-health

etcd原生支持做集群,

etcd通过http协议启动

1.6 master节点安装kubernetes

yum install kubernetes-master.x86_64 -y

vim /etc/kubernetes/apiserver

8行: KUBE_API_ADDRESS="–insecure-bind-address=0.0.0.0"

11行:KUBE_API_PORT="–port=8080"

14行: KUBELET_PORT="–kubelet-port=10250"

17行:KUBE_ETCD_SERVERS="–etcd-servers=http://10.0.0.11:2379"

23行:KUBE_ADMISSION_CONTROL="–admission-control=NamespaceLifecycle,NamespaceExists,LimitRanger,SecurityContextDeny,ResourceQuota"

vim /etc/kubernetes/config

22行:KUBE_MASTER="–master=http://10.0.0.11:8080"

systemctl enable kube-apiserver.service

systemctl restart kube-apiserver.service

systemctl enable kube-controller-manager.service

systemctl restart kube-controller-manager.service

systemctl enable kube-scheduler.service

systemctl restart kube-scheduler.service

检查服务是否安装正常

[root@k8s-master ~]# kubectl get componentstatus

NAME STATUS MESSAGE ERROR

scheduler Healthy ok

controller-manager Healthy ok

etcd-0 Healthy {“health”:“true”}

[k8s日志级别]

1.7 node节点安装kubernetes

yum install kubernetes-node.x86_64 -y

vim /etc/kubernetes/config

22行:KUBE_MASTER="–master=http://10.0.0.11:8080"

vim /etc/kubernetes/kubelet[注意:node节点的IP]

5行:KUBELET_ADDRESS="–address=0.0.0.0"

8行:KUBELET_PORT="–port=10250"

11行:KUBELET_HOSTNAME="–hostname-override=10.0.0.12"

14行:KUBELET_API_SERVER="–api-servers=http://10.0.0.11:8080"

systemctl enable kubelet.service

systemctl restart kubelet.service

systemctl enable kube-proxy.service

systemctl restart kube-proxy.service

在master节点检查

[root@k8s-master ~]# kubectl get nodes

NAME STATUS AGE

10.0.0.12 Ready 6m

10.0.0.13 Ready 3s

1.8 所有节点配置flannel网络

Flannel网络的特点:所有容器组合在一起,形成一个超大的局域网

Flannel三种模式:

Udp 模式:性能较差,配置最简单

Vxlan模式:性能比较好,

Host-gw:性能最好 云主机

#所有节点:

yum install flannel -y

sed -i ‘s#http://127.0.0.1:2379#http://10.0.0.11:2379#g’ /etc/sysconfig/flanneld

##master节点:

etcdctl mk /atomic.io/network/config ‘{ “Network”: “172.18.0.0/16”,“Backend”: {“Type”: “vxlan”} }’

[注意:复制的时候有没有特殊符号,有特殊符号的话,启动会报错]

为何不用172.17网段?

至少16位子网掩码,

systemctl enable flanneld.service

systemctl restart flanneld.service

##node节点:

systemctl enable flanneld.service

systemctl restart flanneld.service

systemctl restart docker (没有重启docker的话,docker和flannel不在同一网段)

systemctl restart kubelet.service

systemctl restart kube-proxy.service

Systemd的配置

Nginx

ExecStartPre=Nginx -t

ExecStart=Nginx 启动之前

ExecStartPost 启动之后

vim /usr/lib/systemd/system/docker.service

#在[Service]区域下增加一行

ExecStartPost=/usr/sbin/iptables -P FORWARD ACCEPT

systemctl daemon-reload

systemctl restart docker

1.9 配置master为镜像仓库

为什么要有一个私有仓库?

最快的速度启动容器

为了安全性,

#master节点

yum install docker -y

若安装失败:

yum clean all

vi /etc/docker/daemon.json

{

“registry-mirrors”: [“https://registry.docker-cn.com”],

“insecure-registries”: [“10.0.0.11:5000”]

}

systemctl enable docker

systemctl start docker

docker run -d -p 5000:5000 --restart=always --name registry -v /opt/myregistry:/var/lib/registry registry

#node节点

vi /etc/docker/daemon.json

{

“registry-mirrors”: [“https://registry.docker-cn.com”],

“insecure-registries”: [“10.0.0.11:5000”]

}

systemctl restart docker

2. 什么是k8s,k8s有什么功能?

k8s是一个docker集群的管理工具 ,[官方文档:kubernetes.io]

k8s是容器的编排工具,可以实现批量管理容器

2.1 k8s的核心功能

自愈: 重新启动失败的容器,在节点不可用时,替换和重新调度节点上的容器,对用户定义的健康检查不响应的容器会被中止,并且在容器准备好服务之前不会把其向客户端广播。[自我修复]

弹性伸缩: 通过监控容器的cpu的负载值,如果这个平均高于80%,增加容器的数量,如果这个平均低于10%,减少容器的数量

服务的自动发现和负载均衡: 不需要修改您的应用程序来使用不熟悉的服务发现机制,Kubernetes 为容器提供了自己的 IP 地址和一组容器的单个 DNS 名称,并可以在它们之间进行负载均衡。

滚动升级和一键回滚: Kubernetes 逐渐部署对应用程序或其配置的更改,同时监视应用程序运行状况,以确保它不会同时终止所有实例。 如果出现问题,Kubernetes会为您恢复更改,利用日益增长的部署解决方案的生态系统。

私密配置文件管理: web容器里面,数据库的账户密码(测试库密码)

2.2 k8s的历史

2013年 docker开源,容器

2014年 docker容器编排工具,立项,谷歌15年容器运维生产经验borg borg-monitor

2015年7月 发布kubernetes 1.0, 加入cncf基金会(谷歌公司牵头成立) 孵化

2016年,kubernetes干掉两个对手,docker swarm,mesos marathon 1.2版

2017年 1.5 -1.9

2018年 k8s 从cncf基金会 毕业项目1.10 1.11 1.12

2019年: 1.13, 1.14 ,1.15,1.16 1.17

cncf :cloud native compute foundation 孵化器

kubernetes (k8s): 希腊语 舵手,领航者 容器编排领域,

谷歌15年容器使用经验,borg容器管理平台,使用golang重构[代码重构:重新写代码]borg,kubernetes

2.3 k8s的应用场景

k8s最适合跑微服务项目!

微服务:软件开发架构,微小的服务,[多套架构]

每个公司有一个独立的域名,拆了多少个功能就有多少个集群,

消息队列实现数据库的回滚功能,eg:RabbitMQ、kafka、redis、

微服务的好处:1)支持更高的并发

2)业务更加的健壮

3)更新迭代更快

mvc架构:(model viewer controller)[一套架构]

数据库:事务

K8s更适合微服务,为什么?

MVC维护一套集群,微服务维护上百套集群

开发环境:微服务,测试环境:微服务,预生产环境:微服务,生产环境:微服务

Docker镜像,快速部署,

K8s弹性伸缩:(容器不够加,多了减)

2.4 k8s的安装方式

yum安装 1.5 最容易安装成功,最适合学习的

源码编译安装—难度最大 可以安装最新版(go语言安装的,不推荐)

二进制安装—步骤繁琐 可以安装最新版 shell,ansible,saltstack(官方已经编辑好二进制包,只需要配置[但是配置繁琐],)[生产中最适合使用]

kubeadm 安装最容易, 网络(早期集群所需的镜像,必须访问谷歌的镜像仓库 ,) 可以安装最新版(容易使用) [生产中最适合使用]

minikube 适合开发人员体验k8s, 网络(仅限于单机)

3. k8s常用的资源

3.1 创建pod资源

创建pod流程:

yaml文件 kubectl create -f .

api-server 写入到etcd

api-server 调用scheduler

api-server调用kubeletpod配置文件

删除pod流程:

kubectl delete pod Nginx

api-server修改etcd中改pod的状态

api-server调用kubelet 停止并删除容器

api-server 删除etcd的pod记录

pod是最小资源单位.[pod是用来启动容器]

任何的一个k8s资源都可以由yml清单文件来定义[任何资源都可以用yml文件创建]

k8s yaml的主要组成[yml文件注意缩进]

apiVersion: v1 api版本

kind: pod 资源类型

Metadata: 属性

spec: 详细

步骤:(使用低版本的Nginx镜像,是方便后面的滚动升级)

Master节点:

⑴ #下载Nginx镜像

wget http://192.168.15.253/docker_images/docker_Nginx1.13.tar.gz

⑵ #导入Nginx镜像

docker load -i docker_Nginx1.13.tar.gz

⑶ #给Nginx镜像打标签

docker tag docker.io/Nginx:1.13 10.0.0.11:5000/Nginx:1.13

⑷ 上传镜像

docker push 10.0.0.11:5000/Nginx:1.13

⑸ 创建pod资源

#创建目录

mkdir k8s_yaml

cd k8s_yaml

mkdir pod

cd pod

vim k8s_pod.yml

apiVersion: v1

kind: Pod

Metadata:

name: Nginx

labels:

app: web

spec:

containers:

- name: Nginx

image: 10.0.0.11:5000/Nginx:1.13

ports:

- containerPort: 80

kubectl create -f k8s_pod.yml

#创建pod类型的资源

kubectl get pod

注意:pod资源名字不能相同

#查看pod类型的资源的状态

kubectl describe pod Nginx

51m 51m 1 {default-scheduler } normal Scheduled Successfully assigned Nginx to 10.0.0.13

51m 45m 6 {kubelet 10.0.0.13} Warning FailedSync Error syncing pod, skipping: Failed to “StartContainer” for “POD” with ErrImagePull: “image pull Failed for registry.access.redhat.com/rhel7/pod-infrastructure:latest, this may be because there are no credentials on this request. details: (open /etc/docker/certs.d/registry.access.redhat.com/redhat-ca.crt: no such file or directory)”

51m 43m 33 {kubelet 10.0.0.13} Warning FailedSync Error syncing pod, skipping: Failed to “StartContainer” for “POD” with ImagePullBackOff: “Back-off pulling image “registry.access.redhat.com/rhel7/pod-infrastructure:latest””

报错:

解决方法:解决软链接失效的问题,修改仓库为私有镜像

#node节点:

vim /etc/kubernetes/kubelet

KUBELET_POD_INFRA_CONTAINER="–pod-infra-container-image=10.0.0.11:5000/pod-infrastructure:latest"

systemctl restart kubelet.service

pod资源:至少由两个容器组成,pod基础容器和业务容器组成(最多1+4)

pod逻辑单元

创建一个pod资源,启动了两个容器(一个基础容器pod,一个业务容器Nginx+定制化操作)

K8s为什么要给业务容器绑定一个基础容器pod?

普通容器Nginx不能实现k8s的高级功能,把基础容器和业务容器捆绑在一块,看作是一个,共同实现k8s的高级功能

Pod资源至少有两个容器组成,一个基础容器pod,一个业务容器

pod配置文件2:

apiVersion: v1

kind: Pod

Metadata:

name: test

labels:

app: web

spec:

containers:

- name: Nginx

image: 10.0.0.11:5000/Nginx:1.13

ports:

- containerPort: 80

- name: alpine

image: 10.0.0.11:5000/alpine:latest

command: [“sleep”,“1000”]

pod配置文件containers写了3个业务容器4个容器

k8s指定容器的初始命令args:

command :

dockerfile指定容器的初始命令CMD

ENTRYPOINT

imagePullPolicy:Always总是更新镜像Never从不更新

工fNotPresent如果本地没有,就去pull

spec:

containers:

image: 10.0.0.11:5000/wordpress :latestimagePullPolicy: Always

name : myweb

ports:

- containerPort: 80

nodeName: 10.0.0.13

3.2 ReplicationController资源

rc:保证指定数量的pod始终存活,rc通过标签选择器来关联pod(管理pod数量)

几个副本数,启动几个pod

k8s资源的常见操作:

kubectl create -f xxx.yaml

kubectl get pod|rc

kubectl describe pod Nginx

kubectl delete pod Nginx 或者kubectl delete -f xxx.yaml kubectl edit pod Nginx

创建一个rc

vi k8s_rc.yml

apiVersion: v1

kind: ReplicationController

Metadata:

name: Nginx

spec:

replicas: 5 #副本5

selector:

app: myweb

template: #模板

Metadata:

labels:

app: myweb

spec:

containers:

- name: myweb

image: 10.0.0.11:5000/Nginx:1.13

ports:

- containerPort: 80

rc的滚动升级

新建一个Nginx-rc1.15.yaml

升级

kubectl rolling-update Nginx -f Nginx-rc1.15.yaml --update-period=10s

回滚

kubectl rolling-update Nginx2 -f Nginx-rc.yaml --update-period=1s

3.3 service资源(访问问题)

[创建service资源,自动分配vip,虚拟IP ping不通,虚拟IP,所有的cube-proxy上都有,一个pod死了,提出service资源]

提供负载均衡的资源,实现服务的自动发现和负载均衡,service的负载均衡是虚拟的,有虚拟的IP地址(cluster ip)[随机生成], service帮助pod暴露端口

创建一个service

apiVersion: v1

kind: Service #简称svc

Metadata:

name: myweb

spec:

type: NodePort #默认ClusterIP

ports:

- port: 80 #clusterIP

nodePort: 30000 #node port

targetPort: 80 #pod port

selector:

app: myweb2

#调整rc的副本书

kubectl scale rc Nginx --replicas=2

#进入pod容器

kubectl exec -it pod_name /bin/bash

修改nodePort范围

vim /etc/kubernetes/apiserver

KUBE_API_ARGS="–service-node-port-range=3000-50000"

命令行创建service资源(非交互式创建)

kubectl expose rc Nginx --type=NodePort --port=80

区别:命令行创建service,vip不能固定,宿主机端口都是随机分配的,

service默认使用iptables来实现负载均衡, k8s 1.8新版本中推荐使用lvs(四层负载均衡 传输层tcp,udp)

[iptables: 四表五链

{四表:

filter(实现数据包的过滤,把不安全的数据包拦截,)

nat(数据包地址转换)

raw(追踪,Linux追踪命令:traceroute Nginx.org #追踪Nginx.org)

mangle(数据包修改,数据包经过一个路由,-1,最后减完数据包丢弃,mangle负责修复这些数据);

五链:

数据包–prerouting链(判断是否是找后面)(不走input就去forWord转发)—input(过滤)–内核(判断属于哪个进程)–对应进程收到–返回内核–output–postrouting

Input(进来的数据包应用此规则链中的规则)

Preprouting(对数据包作路由选择前应用此链中的规则)

Forword(转发数据包时应用此规则链中的规则)

Postrouting(对数据包作路由选择后应用此链中的规则)

output(外出的数据包应用此规则链中的规则)}]

3.4 deployment资源(rc滚动升级,标签选择器变了,svc关联不上,服务中断)

创建deployment流程

yaml文件kubectl create -f .

api-server写入到etcd

controller-manager创建rs

controller-manager申请创建pod

有rc在滚动升级之后,会造成服务访问中断,于是k8s引入了deployment资源

创建deployment

apiVersion: extensions/v1beta1

kind: Deployment

Metadata:

name: Nginx

spec:

replicas: 3

strategy:

rollingUpdate:

maxSurge: 1 #多启动几个容器

maxUnavailable: 1 #最大不可用的pod数量

type: RollingUpdate

minReadySeconds: 30 #升级间隔30秒,超过30秒后,升级好了,

template:

Metadata:

labels:

app: Nginx

spec:

containers:

- name: Nginx

image: 10.0.0.11:5000/Nginx:1.13

ports:

- containerPort: 80

resources:

limits:

cpu: 100m

requests:

cpu: 100m

deployment升级和回滚

deployment滚动升级服务不中断

deployment不依赖配置文件

修改配置文件立即生效

命令行创建deployment

kubectl run Nginx --image=10.0.0.11:5000/Nginx:1.13 --replicas=3 –record

命令行升级版本

kubectl set image deployment Nginx Nginx=10.0.0.11:5000/Nginx:1.15

查看deployment所有历史版本

kubectl rollout history deployment Nginx

deployment回滚到上一个版本

kubectl rollout undo deployment Nginx

deployment回滚到指定版本

kubectl rollout undo deployment Nginx --to-revision=2

3.5 tomcat+MysqL练习

#node节点:

#下载MysqL和Tomcat镜像文件

[root@k8s-node02 ~]# wget http://192.168.15.253/docker_images/docker-MysqL-5.7.tar.gz

[root@k8s-node02 ~]# wget http://192.168.15.253/docker_images/tomcat-app-v2.tar.gz

#导入MysqL和Tomcat镜像

[root@k8s-node02 ~]# docker load -i docker-MysqL-5.7.tar.gz

[root@k8s-node02 ~]# docker load -i tomcat-app-v2.tar.gz

#打标签推送MysqL和Tomcat镜像到私有仓库

[root@k8s-node02 ~]# docker tag docker.io/kubeguide/tomcat-app:v2

[root@k8s-node02 ~]# docker tag docker.io/MysqL:5.7 10.0.0.11:5000/MysqL:5.7

[root@k8s-node02 ~]# docker push 10.0.0.11:5000/tomcat-app:v2

[root@k8s-node02 ~]# docker push 10.0.0.11:5000/MysqL:5.7

#master节点:

#查看镜像文件是否推送成功

[root@k8s-master k8s_yaml]# ls /opt/myregistry/docker/registry/v2/repositories/

alpine MysqL Nginx pod-infrastructure tomcat-app

#上传MysqL和Tomcat的yaml文件并解压

[root@k8s-master k8s_yaml]# ls

pod rc svc tomcat_demo.zip

[root@k8s-master k8s_yaml]# unzip tomcat_demo.zip

[root@k8s-master k8s_yaml]# ls

pod rc svc tomcat_demo tomcat_demo.zip

[root@k8s-master k8s_yaml]# cd tomcat_demo/

[root@k8s-master tomcat_demo]# rm -rf pv

[root@k8s-master tomcat_demo]# ls

MysqL-rc.yml MysqL-svc.yml tomcat-rc.yml tomcat-svc.yml

[root@k8s-master tomcat_demo]# kubectl create -f MysqL-rc.yml

[root@k8s-master tomcat_demo]# kubectl create -f MysqL-svc.yml

[root@k8s-master tomcat_demo]# kubectl get svc

NAME CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes 10.254.0.1 443/TCP 1d

MysqL 10.254.215.126 3306/TCP 9s

myweb 10.254.165.253 80:30000/TCP 5h

[root@k8s-master tomcat_demo]# vim tomcat-rc.yml

- name: MysqL_SERVICE_HOST

value: ‘10.254.215.126’

[root@k8s-master tomcat_demo]# kubectl create -f tomcat-rc.yml

[root@k8s-master tomcat_demo]# kubectl create -f tomcat-svc.yml

[root@k8s-master tomcat_demo]# kubectl get pod

NAME READY STATUS RESTARTS AGE

MysqL-m2qws 1/1 Running 0 2m

myweb-x2jl6 1/1 Running 0 1m

Nginx 1/1 Running 1 22h

Nginx2-j0xw7 1/1 Running 1 18h

Nginx2-m5jzg 1/1 Running 0 18h

Nginx2-w4gzl 1/1 Running 0 18h

test 2/2 Running 34 21h

在k8s中容器之间相互访问,通过VIP地址!

浏览器访问10.0.0.1:30008/demo

- k8s的常用资源(二进制)

4.1 k8s资源的常见操作:

kubectl get

kubectl create

kubectl delete

kubectl edit

kubectl describe

kubectl path “ixxx: {“xxx” :test;xcxc:[3}”

kubectl explain #查看帮助

4.2 pod资源

pod资源至少由两个容器组成,一个基础容器pod+业务容器

动态pod,这个pod的yaml文件从etcd获取的yaml

静态pod,kubelet本地目录读取yaml文件,启动的pod

mkdir /etc/kubernetes/manifest

vim /usr/lib/systemd/system/kubelet.service

#启动参数增加一行

–pod-manifest-path /etc/kubernetes/manifest \

systemctl daemon-reload

systemctl restart kubelet.service

cd /etc/kubernetes/manifest/

vi k8s_pod.yaml

iapiVersion: v1

kind: Pod

Metadata:

name: static-pod

spec:

containers:

- name: Nginx

image: Nginx:1.13

ports:

- containerPort: 80

#验证

[root@k8s-master ~]# kubectl get pod

4.3 污点和容忍度(二进制)

K8s里面为什么需要有污点和容忍度,它的适用范围是什么?

污点taints是定义在节点之上的键值型属性数据,用于让节点拒绝将Pod调度运行于其上, 除非该Pod对象具有接纳节点污点的容忍度。而容忍度tolerations是定义在 Pod对象上的键值型属性数据,用于配置其可容忍的节点污点,而且调度器仅能将Pod对象调度至其能够容忍该节点污点的节点之上,如图所示

节点选择器nodeselector和节点亲和性nodeAffinity两种调度方式都是通过在 Pod对象上添加标签选择器来完成对特定类型节点标签的匹配,它们实现的是由Pod选择节点的机制。而污点和容忍度则是通过向节点添加污点信息来控制Pod对象的调度结果,从而赋予了节点控制何种Pod对象能够调度于其上的主控权。简单来说,节点亲和性使得Pod对象被吸引到一类特定的节点,而污点则相反,它提供了让节点排斥特定Pod对象的能力。

Kubernetes使用PodToleratesNodeTaints预选策略和 TaintTolerationPriority优选函数来完成此种类型的高级调度机制。

污点: 给node节点加污点

污点是node节点的属性,通过打标签实现,[如何加标签?kubectl label nodes 10.0.0.12 node-role.kubernetes.io/node=;删除标签:kubectl label nodes 10.0.0.12 node-role.kubernetes.io/node-]

污点的类型:

NoSchedule:[不要再往该node节点调度,不会影响已有的pod]

PreferNoSchedule:[备用,尽量不要调度]

NoExecute:[清场,驱逐,]